Regressioonanalüüs on meetod uuritavate tunnuste vahelise stohhastilise seose analüütilise väljenduse tuvastamiseks. Regressioonivõrrand näitab, kuidas keskmiselt muutub juures kui muudate mõnda neist x i , ja näeb välja selline:

kus y - sõltuv muutuja (see on alati üks);

X i - sõltumatud muutujad (tegurid) (neid võib olla mitu).

Kui on ainult üks sõltumatu muutuja, on see lihtne regressioonanalüüs. Kui neid on mitu P  2),

siis nimetatakse sellist analüüsi mitmemõõtmeliseks.

2),

siis nimetatakse sellist analüüsi mitmemõõtmeliseks.

Regressioonanalüüsi käigus lahendatakse kaks peamist ülesannet:

regressioonivõrrandi konstrueerimine, s.o. tulemusnäitaja ja sõltumatute tegurite vahelise seose tüübi leidmine x 1 , x 2 , …, x n .

saadud võrrandi olulisuse hindamine, s.o. selle kindlaksmääramine, kui palju valitud faktortunnused selgitavad tunnuse varieerumist y.

Regressioonanalüüsi kasutatakse peamiselt planeerimisel, samuti regulatiivse raamistiku väljatöötamisel.

Erinevalt korrelatsioonianalüüsist, mis vastab vaid küsimusele, kas analüüsitavate tunnuste vahel on seos, annab regressioonanalüüs ka selle formaliseeritud väljenduse. Lisaks, kui korrelatsioonianalüüs uurib mingit tegurite seost, siis regressioonanalüüs uurib ühepoolset sõltuvust, s.o. seos, mis näitab, kuidas faktorimärkide muutus mõjutab resultatiivset märki.

Regressioonanalüüs on üks enim arenenud matemaatilise statistika meetodeid. Rangelt võttes eeldab regressioonanalüüsi rakendamine mitmete erinõuete täitmist (eelkõige x l ,x 2 ,...,x n ;y peavad olema sõltumatud, normaalse jaotusega juhuslikud muutujad konstantse dispersiooniga). Reaalses elus on regressioon- ja korrelatsioonanalüüsi nõuete range järgimine väga haruldane, kuid majandusuuringutes on need mõlemad meetodid väga levinud. Sõltuvused majanduses võivad olla mitte ainult otsesed, vaid ka pöördvõrdelised ja mittelineaarsed. Regressioonimudeli saab koostada mis tahes sõltuvuse olemasolul, kuid mitme muutujaga analüüsis kasutatakse ainult vormi lineaarseid mudeleid:

Regressioonivõrrandi konstrueerimine toimub reeglina vähimruutude meetodil, mille põhiolemus on minimeerida saadud atribuudi tegelike väärtuste ruutude kõrvalekallete summa selle arvutatud väärtustest, st:

kus T - vaatluste arv;

j

=a+b 1 x 1 j +b 2 x 2 j + ... + b n X n j

-

tulemusteguri arvutatud väärtus.

j

=a+b 1 x 1 j +b 2 x 2 j + ... + b n X n j

-

tulemusteguri arvutatud väärtus.

Regressioonikoefitsiendid on soovitatav määrata personaalarvuti analüütiliste pakettide või spetsiaalse finantskalkulaatori abil. Lihtsamal juhul vormi ühefaktorilise lineaarse regressioonivõrrandi regressioonikordajad y = a + bx saab leida valemite abil:

klastri analüüs

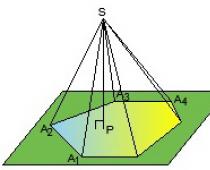

Klasteranalüüs on üks mitmemõõtmelise analüüsi meetoditest, mis on mõeldud populatsiooni rühmitamiseks (klastrimiseks), mille elemente iseloomustavad paljud tunnused. Iga tunnuse väärtused toimivad mitmemõõtmelises tunnuste ruumis uuritava populatsiooni iga üksuse koordinaatidena. Iga vaatlust, mida iseloomustavad mitme indikaatori väärtused, saab esitada punktina nende indikaatorite ruumis, mille väärtusi käsitletakse koordinaatidena mitmemõõtmelises ruumis. Punktide vaheline kaugus R Ja q alates k koordinaadid on määratletud järgmiselt:

Klasterdamise põhikriteerium on see, et erinevused klastrite vahel peaksid olema olulisemad kui samale klastrile määratud vaatluste vahel, s.t. mitmemõõtmelises ruumis tuleb jälgida ebavõrdsust:

kus r 1, 2 – 1. ja 2. klastrite vaheline kaugus.

Nagu ka regressioonanalüüsi protseduurid, on ka klasterdamise protseduur üsna töömahukas, seda on soovitav teha arvutis.

Regressioonanalüüsi põhieesmärk seisneb seose analüütilise vormi määramises, mille puhul resultanttunnuse muutus on tingitud ühe või mitme faktorimärgi mõjust ning konstantseteks ja keskmisteks väärtusteks võetakse kõigi muude tegurite hulk, mis samuti resultantatribuuti mõjutavad. .Regressioonanalüüsi ülesanded:

a) Sõltuvuse vormi kindlakstegemine. Nähtuste omavahelise seose olemuse ja vormi osas on positiivne lineaarne ja mittelineaarne ning negatiivne lineaarne ja mittelineaarne regressioon.

b) Regressioonifunktsiooni defineerimine üht või teist tüüpi matemaatilise võrrandi kujul ja selgitavate muutujate mõju kindlaksmääramine sõltuvale muutujale.

c) Sõltuva muutuja tundmatute väärtuste hindamine. Regressioonifunktsiooni kasutades saate sõltuva muutuja väärtused reprodutseerida selgitavate muutujate etteantud väärtuste intervallis (st lahendada interpolatsiooniülesanne) või hinnata protsessi kulgu väljaspool määratud intervalli (st lahendage ekstrapoleerimise probleem). Tulemuseks on sõltuva muutuja väärtuse hinnang.

Paar regressioon - kahe muutuja y ja x seose võrrand: y=f(x), kus y on sõltuv muutuja (tulemusmärk); x - sõltumatu, selgitav muutuja (omadus-tegur).

On lineaarsed ja mittelineaarsed regressioonid.

Lineaarne regressioon: y = a + bx + ε

Mittelineaarsed regressioonid jagunevad kahte klassi: regressioonid, mis on analüüsis sisalduvate selgitavate muutujate suhtes mittelineaarsed, kuid hinnanguliste parameetrite suhtes lineaarsed, ja regressioonid, mis on hinnanguliste parameetrite suhtes mittelineaarsed.

Regressioonid, mis on seletavates muutujates mittelineaarsed:

Regressioonid, mis on hinnangulistes parameetrites mittelineaarsed:

- võimsus y=a x b ε

- eksponentsiaalne y=a b x ε

- eksponentsiaalne y=e a+b x ε

Lineaarseks taandatavate lineaarsete ja mittelineaarsete võrrandite jaoks lahendatakse a ja b jaoks järgmine süsteem:

Võite kasutada sellest süsteemist tulenevaid valmis valemeid:

Uuritud nähtuste vahelise seose tihedust hinnatakse lineaarse regressiooni lineaarse paari korrelatsioonikordaja r xy (-1≤r xy ≤1) abil:

ja korrelatsiooniindeks p xy – mittelineaarse regressiooni jaoks (0≤p xy ≤1):

Konstrueeritud mudeli kvaliteedile annab hinnangu määramiskoefitsient (indeks), samuti keskmine lähendusviga.

Keskmine lähendusviga on arvutatud väärtuste keskmine kõrvalekalle tegelikest väärtustest:

Lubatud väärtuste piir A - mitte rohkem kui 8-10%.

Keskmine elastsustegur E näitab, mitu protsenti keskmiselt muutub tulemus y oma keskmisest väärtusest, kui tegur x muutub selle keskmisest väärtusest 1% võrra:

.

Dispersioonanalüüsi ülesanne on analüüsida sõltuva muutuja dispersiooni:

∑(y-y )²=∑(y x -y )²+∑(y-y x)²

kus ∑(y-y)² on hälvete ruudu summa;

∑(y x -y)² – regressioonist tingitud kõrvalekallete ruudu summa ("selgitatud" või "faktoriaalne");

∑(y-y x)² - hälvete ruudu jääksumma.

Regressiooniga seletatava dispersiooni osakaalu efektiivse tunnuse y summaarses dispersioonis iseloomustab määramise koefitsient (indeks) R2:

Determinatsioonikordaja on koefitsiendi või korrelatsiooniindeksi ruut.

F-test - regressioonivõrrandi kvaliteedi hindamine - seisneb hüpoteesi kontrollimises Aga regressioonivõrrandi statistilise ebaolulisuse ja seose tiheduse näitaja kohta. Selleks võrreldakse tegelikku F-fakti ja Fisheri F-kriteeriumi väärtuste kriitilist (tabelikujulist) F-tabelit. F-faktuur määratakse ühe vabadusastme jaoks arvutatud faktoriaal- ja jääkvariansside vahekorrast:  ,

,

kus n on rahvastiku ühikute arv; m on muutujate x parameetrite arv.

F tabel on kriteeriumi maksimaalne võimalik väärtus juhuslike tegurite mõjul antud vabadusastmete ja olulisuse taseme a korral. Olulisuse tase a – õige hüpoteesi tagasilükkamise tõenäosus, eeldusel, et see on tõene. Tavaliselt võetakse a väärtuseks 0,05 või 0,01.

Kui F tabel< F факт, то Н о - гипотеза о случайной природе оцениваемых характеристик отклоняется и признается их статистическая значимость и надежность. Если F табл >F on fakt, siis hüpoteesi H kohta ei lükata ümber ja tunnistatakse regressioonivõrrandi statistilist ebaolulisust, ebausaldusväärsust.

Regressiooni- ja korrelatsioonikordajate statistilise olulisuse hindamiseks arvutatakse iga näitaja Studenti t-test ja usaldusvahemikud. Esitatakse hüpotees H näitajate juhuslikkuse kohta, s.t. nende ebaolulisest erinevusest nullist. Regressiooni- ja korrelatsioonikordajate olulisuse hindamine Studenti t-testi abil viiakse läbi nende väärtuste võrdlemisel juhusliku vea suurusega:

; ; .

Lineaarse regressiooni parameetrite ja korrelatsioonikordaja juhuslikud vead määratakse valemitega:

Võrreldes t-statistika tegelikke ja kriitilisi (tabelikujulisi) väärtusi - t tabl ja t fact - aktsepteerime või lükkame tagasi hüpoteesi H o.

Fisheri F-testi ja Studenti t-statistika vahelist seost väljendab võrdsus

Kui t tabel< t факт то H o отклоняется, т.е. a , b и r xy не случайно отличаются от нуля и сформировались под влиянием систематически действующего фактора х. Если t табл >t asjaolu, et hüpoteesi H umbes ei lükata tagasi ja tunnistatakse a, b või r xy moodustumise juhuslikkus.

Usaldusvahemiku arvutamiseks määrame iga näitaja piirvea D:

Δ a =t tabel m a , Δ b =t tabel m b .

Usaldusvahemike arvutamise valemid on järgmised:

γ a \u003d aΔ a; γ a \u003d a-Δ a; γ a =a+Δa

γb = bΔb; γb = b-Δb; γb =b+Δb

Kui null jääb usaldusvahemiku piiridesse, st. Kui alumine piir on negatiivne ja ülemine piir on positiivne, siis eeldatakse, et hinnanguline parameeter on null, kuna see ei saa samaaegselt võtta nii positiivseid kui ka negatiivseid väärtusi.

Prognoositav väärtus y p määratakse, asendades vastava (prognoositava) väärtuse x p regressioonivõrrandis y x =a+b·x . Prognoosi m y x keskmine standardviga arvutatakse:  ,

,

kus

ja prognoosi usaldusvahemik koostatakse:

γ y x =y p Δ y p ; y y x min=y p -Δ y p; γ y x max=y p +Δ y p

kus Δ y x =t tabel ·m y x .

Lahenduse näide

Ülesanne number 1. Uurali piirkonna seitsme territooriumi jaoks 199X on teada kahe märgi väärtused.Tabel 1.

Nõutud: 1. Et iseloomustada y sõltuvust x-st, arvuta järgmiste funktsioonide parameetrid:

a) lineaarne;

b) astmeseadus (varem on vaja läbi viia muutujate lineariseerimise protseduur, võttes mõlema osa logaritmi);

c) demonstratiivne;

d) võrdkülgne hüperbool (peate ka välja mõtlema, kuidas seda mudelit eelnevalt lineariseerida).

2. Hinnake iga mudelit keskmise lähendusvea A ja Fisheri F-testi abil.

Lahendus (valik nr 1)

Lineaarse regressiooni parameetrite a ja b arvutamiseks y=a+b·x (arvutuse saab teha kalkulaatori abil).lahendada normaalvõrrandi süsteemi suhtes aga Ja b:

Algandmete põhjal arvutame ∑y, ∑x, ∑y x, ∑x², ∑y²:

| y | x | yx | x2 | y2 | y x | y-y x | Ai | |

| l | 68,8 | 45,1 | 3102,88 | 2034,01 | 4733,44 | 61,3 | 7,5 | 10,9 |

| 2 | 61,2 | 59,0 | 3610,80 | 3481,00 | 3745,44 | 56,5 | 4,7 | 7,7 |

| 3 | 59,9 | 57,2 | 3426,28 | 3271,84 | 3588,01 | 57,1 | 2,8 | 4,7 |

| 4 | 56,7 | 61,8 | 3504,06 | 3819,24 | 3214,89 | 55,5 | 1,2 | 2,1 |

| 5 | 55,0 | 58,8 | 3234,00 | 3457,44 | 3025,00 | 56,5 | -1,5 | 2,7 |

| 6 | 54,3 | 47,2 | 2562,96 | 2227,84 | 2948,49 | 60,5 | -6,2 | 11,4 |

| 7 | 49,3 | 55,2 | 2721,36 | 3047,04 | 2430,49 | 57,8 | -8,5 | 17,2 |

| Kokku | 405,2 | 384,3 | 22162,34 | 21338,41 | 23685,76 | 405,2 | 0,0 | 56,7 |

| kolmap väärtus (kokku/n) | 57,89 y | 54,90 x | 3166,05 x y | 3048,34 x² | 3383,68 y² | X | X | 8,1 |

| s | 5,74 | 5,86 | X | X | X | X | X | X |

| s2 | 32,92 | 34,34 | X | X | X | X | X | X |

a=y -b x = 57,89+0,35 54,9 ≈ 76,88

Regressioonivõrrand: y= 76,88 - 0,35X. Keskmise päevapalga tõusuga 1 rubla võrra. toidukaupade ostmiseks tehtavate kulutuste osakaalu vähendatakse keskmiselt 0,35% punkti võrra.

Arvutage paari korrelatsiooni lineaarne koefitsient: ![]()

Suhtlemine on mõõdukas, vastupidine.

Määrame determinatsioonikoefitsiendi: r² xy =(-0,35)=0,127

Tulemuse 12,7% kõikumine on seletatav x-teguri varieerumisega. Tegelike väärtuste asendamine regressioonivõrrandis X, määrame y x teoreetilised (arvutatud) väärtused. Leiame keskmise lähendusvea A väärtuse:

Arvutatud väärtused erinevad tegelikest keskmiselt 8,1%.

Arvutame F-kriteeriumi:

Saadud väärtus viitab vajadusele nõustuda hüpoteesiga H 0 ilmnenud sõltuvuse juhuslikkuse ning võrrandi parameetrite ja seose tiheduse näitaja statistilise ebaolulisuse kohta.

1b. Võimsuse mudeli y=a x b konstrueerimisele eelneb muutujate lineariseerimise protseduur. Näites tehakse lineariseerimine võrrandi mõlema poole logaritmi abil:

lg y=lg a + b lg x

Y=C+b Y

kus Y=lg(y), X=lg(x), C=lg(a).

Arvutusteks kasutame tabelis olevaid andmeid. 1.3.

Tabel 1.3

| Y | X | YX | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 1,6542 | 3,0398 | 3,3768 | 2,7364 | 61,0 | 7,8 | 60,8 | 11,3 |

| 2 | 1,7868 | 1,7709 | 3,1642 | 3,1927 | 3,1361 | 56,3 | 4,9 | 24,0 | 8,0 |

| 3 | 1,7774 | 1,7574 | 3,1236 | 3,1592 | 3,0885 | 56,8 | 3,1 | 9,6 | 5,2 |

| 4 | 1,7536 | 1,7910 | 3,1407 | 3,0751 | 3,2077 | 55,5 | 1,2 | 1,4 | 2,1 |

| 5 | 1,7404 | 1,7694 | 3,0795 | 3,0290 | 3,1308 | 56,3 | -1,3 | 1,7 | 2,4 |

| 6 | 1,7348 | 1,6739 | 2,9039 | 3,0095 | 2,8019 | 60,2 | -5,9 | 34,8 | 10,9 |

| 7 | 1,6928 | 1,7419 | 2,9487 | 2,8656 | 3,0342 | 57,4 | -8,1 | 65,6 | 16,4 |

| Kokku | 12,3234 | 12,1587 | 21,4003 | 21,7078 | 21,1355 | 403,5 | 1,7 | 197,9 | 56,3 |

| Tähendab | 1,7605 | 1,7370 | 3,0572 | 3,1011 | 3,0194 | X | X | 28,27 | 8,0 |

| σ | 0,0425 | 0,0484 | X | X | X | X | X | X | X |

| σ2 | 0,0018 | 0,0023 | X | X | X | X | X | X | X |

Arvutage C ja b:

C=Y -b X = 1,7605 + 0,298 1,7370 = 2,278126

Saame lineaarvõrrandi: Y=2,278-0,298 X

Pärast selle võimendamist saame: y=10 2,278 x -0,298

Asendades selles võrrandis tegelikud väärtused X, saame tulemuse teoreetilised väärtused. Nende põhjal arvutame välja näitajad: ühenduse tihedus - korrelatsiooniindeks p xy ja keskmine lähendusviga A .

Võimsuse mudeli omadused näitavad, et see kirjeldab seost mõnevõrra paremini kui lineaarfunktsioon.

1c. Eksponentkõvera y \u003d a b x võrrandi koostamisele eelneb protseduur muutujate lineariseerimiseks võrrandi mõlema osa logaritmi võtmisel:

lg y=lg a + x lg b

Y=C+B x

Arvutusteks kasutame tabeliandmeid.

| Y | x | Yx | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 45,1 | 82,8758 | 3,3768 | 2034,01 | 60,7 | 8,1 | 65,61 | 11,8 |

| 2 | 1,7868 | 59,0 | 105,4212 | 3,1927 | 3481,00 | 56,4 | 4,8 | 23,04 | 7,8 |

| 3 | 1,7774 | 57,2 | 101,6673 | 3,1592 | 3271,84 | 56,9 | 3,0 | 9,00 | 5,0 |

| 4 | 1,7536 | 61,8 | 108,3725 | 3,0751 | 3819,24 | 55,5 | 1,2 | 1,44 | 2,1 |

| 5 | 1,7404 | 58,8 | 102,3355 | 3,0290 | 3457,44 | 56,4 | -1,4 | 1,96 | 2,5 |

| 6 | 1,7348 | 47,2 | 81,8826 | 3,0095 | 2227,84 | 60,0 | -5,7 | 32,49 | 10,5 |

| 7 | 1,6928 | 55,2 | 93,4426 | 2,8656 | 3047,04 | 57,5 | -8,2 | 67,24 | 16,6 |

| Kokku | 12,3234 | 384,3 | 675,9974 | 21,7078 | 21338,41 | 403,4 | -1,8 | 200,78 | 56,3 |

| kolmap zn. | 1,7605 | 54,9 | 96,5711 | 3,1011 | 3048,34 | X | X | 28,68 | 8,0 |

| σ | 0,0425 | 5,86 | X | X | X | X | X | X | X |

| σ2 | 0,0018 | 34,339 | X | X | X | X | X | X | X |

Regressiooniparameetrite väärtused A ja IN ulatus:

A=Y -B x = 1,7605+0,0023 54,9 = 1,887

Saadakse lineaarvõrrand: Y=1,887-0,0023x. Potentseerime saadud võrrandit ja kirjutame selle tavalisel kujul:

y x = 10 1,887 10 -0,0023 x = 77,1 0,9947 x

Hindame seose tihedust korrelatsiooniindeksi p xy kaudu:

Regressioonanalüüs on enamiku ökonomeetriliste mudelite loomise aluseks, mille hulka tuleks lisada ka kuluhinnangu mudelid. Hindamismudelite koostamiseks saab seda meetodit kasutada juhul, kui analoogide (võrreldavate objektide) ja kulutegurite (võrdluselementide) arv korreleeruvad üksteisega järgmiselt: P> (5 -g-10) x selleks, need. analooge peaks olema 5-10 korda rohkem kui kulutegureid. Sama nõue andmemahu ja tegurite arvu suhte kohta kehtib ka muude ülesannete puhul: objekti maksumuse ja tarbija parameetrite vahelise seose loomine; parandusindeksite arvutamise korra põhjendus; hinnasuundumuste selgitamine; kulumise ja mõjutegurite muutuste vahelise seose tuvastamine; kulunormide arvutamiseks sõltuvuste saamine jne. Selle nõude täitmine on vajalik selleks, et vähendada tõenäosust töötada andmevalimiga, mis ei rahulda juhuslike suuruste normaaljaotuse nõuet.

Regressioonisuhe kajastab ainult saadud muutuja, näiteks maksumuse, keskmist trendi, mis tuleneb muutustest ühes või mitmes faktorimuutujas, nagu asukoht, tubade arv, pindala, korrus jne. See on erinevus regressiooniseose ja funktsionaalse seose vahel, mille puhul on saadud muutuja väärtus faktormuutujate antud väärtuse jaoks rangelt määratletud.

Regressioonisuhte olemasolu / tulemuse vahel juures ja faktorimuutujad x lk ..., x k(tegurid) näitab, et seda seost ei määra mitte ainult valitud tegurimuutujate mõju, vaid ka muutujate mõju, millest mõned on üldiselt teadmata, teisi ei saa hinnata ja arvesse võtta:

Arvestamata muutujate mõju tähistatakse selle võrrandi teise liikmega ?, mida nimetatakse lähendusveaks.

Regressioonisõltuvusi on järgmist tüüpi:

- ? paarisregressioon – seos kahe muutuja vahel (resultant ja faktoriaal);

- ? mitmekordne regressioon – ühe saadud muutuja ja kahe või enama uuringusse kaasatud faktorimuutuja sõltuvus.

Regressioonanalüüsi põhiülesanne on kvantifitseerida muutujate (paarisregressioonis) ja mitme muutuja (mitmekordses regressioonis) vahelise seose lähedust. Seoste tihedust kvantifitseeritakse korrelatsioonikordaja abil.

Regressioonanalüüsi kasutamine võimaldab kindlaks teha peamiste tegurite (hedooniliste omaduste) mõju mustri uuritavale indikaatorile nii nende tervikuna kui ka igaüks eraldi. Regressioonanalüüsi kui matemaatilise statistika meetodi abil on võimalik esiteks leida ja kirjeldada saadava (soovitava) muutuja analüütilise sõltuvuse vorm faktoriaalsetest ning teiseks hinnata muutujate lähedust. see sõltuvus.

Esimese ülesande lahendamisel saadakse matemaatiline regressioonimudel, mille abil arvutatakse seejärel etteantud faktorite väärtustele soovitud näitaja. Teise ülesande lahendus võimaldab kindlaks teha arvutatud tulemuse usaldusväärsuse.

Seega võib regressioonanalüüsi defineerida kui formaalsete (matemaatiliste) protseduuride kogumit, mis on kavandatud mõõtma tulemus- ja faktorimuutujate vahelise seose tihedust, suunda ja vormi analüütilist väljendust, s.o. sellise analüüsi väljundiks peaks olema vormi struktuurselt ja kvantitatiivselt määratletud statistiline mudel:

![]()

kus y - saadud muutuja (soovitava näitaja, näiteks maksumus, üür, kapitalisatsioonimäär) keskmine väärtus üle P tema tähelepanekud; x on tegurimuutuja väärtus (/-th kulutegur); kuni - tegurimuutujate arv.

Funktsioon f(x l ,...,x lc), kirjeldades saadud muutuja sõltuvust faktoriaalsetest, nimetatakse regressioonivõrrandiks (funktsiooniks). Mõiste "regressioon" (regressioon (lat.) - taganemine, millegi juurde naasmine) on seotud ühe konkreetse meetodi kujunemise etapis lahendatud ülesande spetsiifikaga ja praegu ei kajasta see meetodi kogu olemust. meetod, kuid seda kasutatakse jätkuvalt.

Regressioonianalüüs sisaldab tavaliselt järgmisi samme:

- ? homogeensete objektide valimi moodustamine ja nende objektide kohta esialgse teabe kogumine;

- ? saadud muutujat mõjutavate peamiste tegurite valik;

- ? proovi normaalsuse kontrollimine kasutades X 2 ehk binoomkriteerium;

- ? suhtlusvormi puudutava hüpoteesi aktsepteerimine;

- ? matemaatiline andmetöötlus;

- ? regressioonimudeli saamine;

- ? selle statistiliste näitajate hindamine;

- ? kontrollarvutused regressioonimudeli abil;

- ? tulemuste analüüs.

Määratud toimingute jada leiab aset nii faktormuutuja ja ühe tulemuseks oleva muutuja vahelise paarisuhte kui ka saadud muutuja ja mitme faktormuutuja vahelise mitmekordse seose uurimisel.

Regressioonanalüüsi kasutamine seab esialgsele teabele teatud nõuded:

- ? objektide statistiline valim peaks olema funktsionaalselt ja konstruktiivtehnoloogiliselt homogeenne;

- ? üsna palju;

- ? uuritav kulunäitaja - tulenev muutuja (hind, maksumus, kulud) - tuleb selle arvutamiseks kõigi valimis olevate objektide puhul taandada samadele tingimustele;

- ? tegurmuutujaid tuleb mõõta piisavalt täpselt;

- ? tegurmuutujad peavad olema sõltumatud või minimaalselt sõltuvad.

Valimi homogeensuse ja täielikkuse nõuded on vastuolus: mida rangemalt toimub objektide valik nende homogeensuse järgi, seda väiksem on valim, ja vastupidi, valimi suurendamiseks on vaja kaasata objekte, mis ei ole üksteisega väga sarnased.

Pärast andmete kogumist homogeensete objektide rühma kohta analüüsitakse neid, et teha kindlaks teoreetilise regressioonijoone kujul saadud ja faktormuutujate vaheline seos. Teoreetilise regressioonisirge leidmise protsess seisneb lähendava kõvera mõistlikus valikus ja selle võrrandi kordajate arvutamises. Regressioonijoon on sujuv kõver (konkreetsel juhul sirgjoon), mis kirjeldab matemaatilist funktsiooni kasutades uuritava sõltuvuse üldist trendi ja silub kõrvaltegurite mõju ebaregulaarseid juhuslikke kõrvalekaldeid.

Paaritud regressioonisõltuvuste kuvamiseks hindamisülesannetes kasutatakse kõige sagedamini järgmisi funktsioone: lineaarne - y - a 0 + ars + s võimsus - y - aj&i + c demonstratiivne - y - lineaarne eksponentsiaalne - y - a 0 + ar * + s. Siin - e ligikaudne viga, mis tuleneb arvestamata juhuslike tegurite toimest.

Nendes funktsioonides on y saadud muutuja; x - tegur muutuja (tegur); aga 0 , a r a 2 - regressioonimudeli parameetrid, regressioonikordajad.

Lineaarne eksponentsiaalne mudel kuulub nn hübriidmudelite klassi järgmisel kujul:

kus

kus x (i = 1, /) - tegurite väärtused;

b t (i = 0, /) on regressioonivõrrandi koefitsiendid.

Selles võrrandis on komponendid A, B Ja Z vastavad hinnatava vara üksikute komponentide maksumusele, näiteks maatüki maksumusele ja parendustööde maksumusele ning parameetrile K on levinud. Selle eesmärk on kohandada hinnatava vara kõigi komponentide väärtust ühise mõjuteguri (nt asukoha) alusel.

Vastavate koefitsientide astmes olevate tegurite väärtused on binaarsed muutujad (0 või 1). Kraadi aluseks olevad tegurid on diskreetsed või pidevad muutujad.

Korrutamismärgikoefitsientidega seotud tegurid on samuti pidevad või diskreetsed.

Spetsifikatsioon viiakse reeglina läbi empiirilise lähenemisviisi abil ja see hõlmab kahte etappi:

- ? regressioonivälja punktide joonistamine graafikule;

- ? võimaliku lähenduskõvera tüübi graafiline (visuaalne) analüüs.

Regressioonikõvera tüüp ei ole alati koheselt valitav. Selle määramiseks kantakse esmalt graafikule vastavalt algandmetele regressioonivälja punktid. Seejärel tõmmatakse piki punktide asukohta visuaalselt joon, püüdes välja selgitada seose kvalitatiivse mustri: ühtlane kasv või ühtlane langus, kasv (vähenemine) koos dünaamika kiiruse suurenemisega (vähenemisega), sujuv lähenemine teatud tase.

Seda empiirilist lähenemist täiendab loogiline analüüs, mis lähtub juba teadaolevatest ideedest uuritavate tegurite majandusliku ja füüsilise olemuse ning nende vastastikuse mõju kohta.

Näiteks on teada, et saadud muutujate - majandusnäitajate (hinnad, üür) sõltuvused mitmetest faktormuutujatest - hinda kujundavad tegurid (kaugus asula keskusest, pindala jne) on mittelineaarsed , ja neid saab üsna rangelt kirjeldada astme-, eksponentsiaal- või ruutfunktsiooni abil. Kuid väikeste tegurite vahemikega saab vastuvõetavaid tulemusi saada ka lineaarfunktsiooni abil.

Kui ühe funktsiooni kohta ei ole siiski võimalik koheselt kindlat valikut teha, siis valitakse kaks või kolm funktsiooni, arvutatakse nende parameetrid ja seejärel, kasutades sobivaid ühenduse tiheduse kriteeriume, valitakse lõpuks funktsioon.

Teoreetiliselt nimetatakse kõvera kuju leidmise regressiooniprotsessi spetsifikatsioon mudel ja selle koefitsiendid - kalibreerimine mudelid.

Kui leitakse, et saadud muutuja y sõltub mitmest faktoriaalmuutujast (tegurist) x ( , x 2 , ..., x k, seejärel kasutavad nad mitmekordse regressioonimudeli loomist. Tavaliselt kasutatakse kolme mitmekordse suhtluse vormi: lineaarne - y - a 0 + a x x x + a^x 2 + ... + a k x k, demonstratiivne - y - a 0 a*i a x t- a x b, võimsus - y - a 0 x x ix 2 a 2. .x^ või nende kombinatsioonid.

Eksponent- ja eksponentsiaalfunktsioonid on universaalsemad, kuna need on ligikaudsed mittelineaarsetele seostele, mis on suurem osa hindamisel uuritud sõltuvustest. Lisaks saab neid kasutada objektide hindamisel ja massihindamise statistilise modelleerimise meetodil ning parandustegurite kehtestamisel individuaalsel hindamisel otsese võrdluse meetodil.

Kalibreerimisetapis arvutatakse regressioonimudeli parameetrid vähimruutude meetodil, mille põhiolemus on see, et saadud muutuja arvutatud väärtuste ruutude hälvete summa. juures., st. arvutatud vastavalt valitud seose võrrandile, tegelikest väärtustest peaks olema minimaalne:

Väärtused j) (. ja y. seega teada K on funktsioon ainult võrrandi kordajatest. Et leida miinimum S võtta osatuletised K võrrandi koefitsientide järgi ja võrdsusta need nulliga:

Selle tulemusena saame normaalvõrrandi süsteemi, mille arv on võrdne soovitud regressioonivõrrandi määratud kordajate arvuga.

Oletame, et peame leidma lineaarvõrrandi koefitsiendid y - a 0 + ars. Ruuthälvete summa on:

/=1

Funktsiooni eristamine K tundmatute koefitsientide järgi a 0 ja võrdsustage osatuletised nulliga:

Pärast teisendusi saame:

kus P - algsete tegelike väärtuste arv juures neid (analoogide arv).

Ülaltoodud regressioonivõrrandi kordajate arvutamise protseduur on rakendatav ka mittelineaarsete sõltuvuste puhul, kui neid sõltuvusi on võimalik lineariseerida, s.t. muuta muutujate muutust kasutades lineaarsele kujule. Positiivsed ja eksponentsiaalfunktsioonid pärast logaritmi ja vastava muutujate muutuse võtmist omandavad lineaarse kuju. Näiteks on võimsusfunktsioon pärast logaritmi võtmist järgmisel kujul: In y \u003d 1n 0 +a x 1ph. Pärast muutujate muutumist Y- sisse y, L 0 - sisse ja nr X- X-is saame lineaarse funktsiooni

Y = A0 + cijX, mille koefitsiendid leitakse ülalkirjeldatud viisil.

Vähimruutude meetodit kasutatakse ka mitmekordse regressioonimudeli koefitsientide arvutamiseks. Niisiis, normaalvõrrandi süsteem kahe muutujaga lineaarfunktsiooni arvutamiseks Xj Ja x 2 pärast mitmeid ümberkujundamisi näeb see välja järgmine:

Tavaliselt lahendatakse see võrrandisüsteem lineaaralgebra meetodite abil. Mitmekordne eksponentsiaalfunktsioon viiakse lineaarsesse vormi, võttes logaritme ja muutes muutujaid samamoodi nagu paaris eksponentsiaalfunktsioon.

Hübriidmudelite kasutamisel leitakse mitmekordsed regressioonikoefitsiendid, kasutades järjestikuste lähenduste meetodi arvprotseduure.

Lõpliku valiku tegemiseks mitme regressioonivõrrandi vahel on vaja testida iga võrrandit seose tiheduse suhtes, mida mõõdetakse korrelatsioonikordaja, dispersiooni ja variatsioonikordaja abil. Hindamisel saab kasutada ka Studenti ja Fisheri kriteeriume. Mida suurem on ühenduse tihedus, mis näitab kõverat, seda eelistatavam on see, kui kõik muud asjad on võrdsed.

Kui lahendatakse sellise klassi probleem, kui on vaja kindlaks teha kulunäitaja sõltuvus kuluteguritest, siis on soov võtta arvesse võimalikult palju mõjutegureid ja seeläbi koostada täpsem mitme regressiooni mudel. arusaadav. Kuid kaks objektiivset piirangut takistavad tegurite arvu laienemist. Esiteks nõuab mitme regressioonimudeli loomine palju suuremat objektide valimit kui paarismudeli loomine. Üldtunnustatud seisukoht on, et objektide arv valimis peaks ületama arvu P tegurid, vähemalt 5-10 korda. Sellest järeldub, et kolme mõjuteguriga mudeli koostamiseks on vaja koguda ligikaudu 20 erineva teguriväärtuste kogumiga objektist koosnev valim. Teiseks peaksid mudelisse valitud tegurid oma mõjus väärtusindikaatorile olema üksteisest piisavalt sõltumatud. Seda pole lihtne tagada, kuna valim ühendab tavaliselt samasse perekonda kuuluvaid objekte, mille puhul toimub mitmete tegurite korrapärane muutumine objektide lõikes.

Regressioonimudelite kvaliteeti testitakse tavaliselt järgmise statistika abil.

Regressioonivõrrandi vea standardhälve (hinnanguviga):

kus P - valimi suurus (analoogide arv);

kuni - tegurite arv (kulutegurid);

Regressioonivõrrandiga seletamatu viga (joonis 3.2);

y. - saadud muutuja tegelik väärtus (näiteks maksumus); y t - saadud muutuja arvutatud väärtus.

Seda indikaatorit nimetatakse ka hinnangu standardviga (RMS-viga). Joonisel tähistavad punktid valimi konkreetseid väärtusi, sümbol näitab valimi keskmiste väärtuste joont, kaldkriipsjoon on regressioonijoon.

Riis. 3.2.

Hindamisvea standardhälve mõõdab, kui palju erinevad tegelikud y väärtused vastavatest arvutatud väärtustest. juures( , saadud regressioonimudeli abil. Kui valim, millele mudel on üles ehitatud, allub normaaljaotuse seadusele, siis võib väita, et 68% reaalväärtustest juures on vahemikus juures ± & e regressioonijoonest ja 95% - vahemikus juures ± 2d e. See indikaator on mugav, kuna mõõtühikud vm? sobitada mõõtühikutega juures,. Sellega seoses saab seda kasutada hindamisprotsessis saadud tulemuse täpsuse näitamiseks. Näiteks väärtussertifikaadil saate näidata, et regressioonimudeli abil saadud turuväärtuse väärtus V tõenäosusega 95% on vahemikus alates (V-2d,.) enne (at + 2ds).

Saadud muutuja variatsioonikoefitsient:

kus y - saadud muutuja keskmine väärtus (joonis 3.2).

Regressioonanalüüsis on variatsioonikordaja var tulemuse standardhälve, väljendatuna protsendina tulemusmuutuja keskmisest. Variatsioonikordaja võib olla saadud regressioonimudeli ennustamisomaduste kriteeriumiks: mida väiksem on väärtus var, seda kõrgemad on mudeli ennustavad omadused. Variatsioonikordaja kasutamine on eelistatavam eksponendile &e, kuna see on suhteline astendaja. Selle indikaatori praktilisel kasutamisel võib soovitada mitte kasutada mudelit, mille variatsioonikordaja ületab 33%, kuna sel juhul ei saa väita, et need valimid alluksid normaaljaotuse seadusele.

Määramiskoefitsient (mitmekordne korrelatsioonikordaja ruudus):

Seda indikaatorit kasutatakse saadud regressioonimudeli üldise kvaliteedi analüüsimiseks. See näitab, kui suur protsent saadud muutuja variatsioonist tuleneb kõigi mudelis sisalduvate faktorimuutujate mõjust. Määramiskoefitsient jääb alati vahemikku nullist üheni. Mida lähemal on determinatsioonikoefitsiendi väärtus ühtsusele, seda paremini kirjeldab mudel algset andmerida. Määramiskoefitsienti saab esitada muul viisil:

Siin on regressioonimudeliga seletatav viga,

![]() aga

aga ![]() - seletamatu viga

- seletamatu viga

regressioonimudel. Majanduslikust vaatenurgast võimaldab see kriteerium hinnata, mitu protsenti hinnakõikumistest seletatakse regressioonivõrrandiga.

Indikaatori täpne vastuvõtupiir R2 seda on võimatu kõigil juhtudel täpsustada. Arvesse tuleb võtta nii valimi suurust kui ka võrrandi mõtestatud tõlgendamist. Reeglina on sama tüüpi objektide andmete uurimisel, mis on saadud ligikaudu samal ajal, väärtus R2 ei ületa taset 0,6-0,7. Kui kõik ennustusvead on nullid, st. kui seos tulemus- ja faktorimuutujate vahel on funktsionaalne, siis R2 =1.

Kohandatud määramiskoefitsient:

Kohandatud määramiskoefitsiendi kasutuselevõtu vajadus on seletatav asjaoluga, et tegurite arvu suurenemisega juurde tavaline määramistegur peaaegu alati suureneb, kuid vabadusastmete arv väheneb (n-k- üks). Sisestatud korrigeerimine vähendab väärtust alati R2, niivõrd kui (P - 1) > (p- kuni-üks). Selle tulemusena väärtus R 2 CKOf) võib muutuda isegi negatiivseks. See tähendab, et väärtus R2 oli enne korrigeerimist nullilähedane ja dispersiooni osakaal on seletatav muutuja regressioonivõrrandiga juures väga väike.

Kahest regressioonimudeli variandist, mis erinevad korrigeeritud determinatsioonikoefitsiendi väärtuse poolest, kuid millel on sama head muud kvaliteedikriteeriumid, eelistatakse suure korrigeeritud determinantkoefitsiendi väärtusega varianti. Determinatsioonikoefitsienti ei korrigeerita, kui (n - k): k> 20.

Fisheri suhe:

Seda kriteeriumi kasutatakse määramiskoefitsiendi olulisuse hindamiseks. Ruudude jääksumma ![]() on ennustusvea mõõt, mis kasutab teadaolevate kuluväärtuste regressiooni aadressil.. Selle võrdlus ruutude regressioonisummaga näitab, mitu korda ennustab regressioonisõltuvus tulemust keskmisest paremini juures. Seal on kriitiliste väärtuste tabel F R Fisheri koefitsient sõltuvalt lugeja vabadusastmete arvust - et, nimetaja v 2 = p - k- 1 ja olulisuse tase a. Kui Fisheri kriteeriumi arvutatud väärtus F R on suurem kui tabeli väärtus, siis hüpotees determinatsioonikordaja ebaolulisusest, s.o. regressioonivõrrandis sisalduvate seoste ja reaalselt eksisteerivate seoste lahknevuse kohta tõenäosusega p = 1 - a lükatakse tagasi.

on ennustusvea mõõt, mis kasutab teadaolevate kuluväärtuste regressiooni aadressil.. Selle võrdlus ruutude regressioonisummaga näitab, mitu korda ennustab regressioonisõltuvus tulemust keskmisest paremini juures. Seal on kriitiliste väärtuste tabel F R Fisheri koefitsient sõltuvalt lugeja vabadusastmete arvust - et, nimetaja v 2 = p - k- 1 ja olulisuse tase a. Kui Fisheri kriteeriumi arvutatud väärtus F R on suurem kui tabeli väärtus, siis hüpotees determinatsioonikordaja ebaolulisusest, s.o. regressioonivõrrandis sisalduvate seoste ja reaalselt eksisteerivate seoste lahknevuse kohta tõenäosusega p = 1 - a lükatakse tagasi.

Keskmine lähendusviga(keskmine protsentuaalne hälve) arvutatakse keskmise suhtelise erinevusena, väljendatuna protsentides, saadud muutuja tegelike ja arvutatud väärtuste vahel:

Mida madalam on selle indikaatori väärtus, seda parem on mudeli prognoositav kvaliteet. Kui selle indikaatori väärtus ei ole suurem kui 7%, näitavad need mudeli suurt täpsust. Kui 8 > 15%, näitavad mudeli ebarahuldavat täpsust.

Regressioonikordaja standardviga:

kus (/I) -1 .- maatriksi diagonaalelement (X G X) ~ 1 kuni - tegurite arv;

X- tegurmuutujate väärtuste maatriks:

X7- tegurimuutujate väärtuste transponeeritud maatriks;

(JL) _| on maatriksi pöördvõrdeline maatriks.

Mida väiksemad on need skoorid iga regressioonikordaja kohta, seda usaldusväärsem on vastava regressioonikordaja hinnang.

Õpilase test (t-statistika):

See kriteerium võimaldab mõõta seose usaldusväärsuse (olulisuse) astet antud regressioonikordaja tõttu. Kui arvutatud väärtus t. suurem kui tabeli väärtus

t av , kus v - p - k - 1 on vabadusastmete arv, siis lükatakse tagasi hüpotees, et see koefitsient on statistiliselt ebaoluline, tõenäosusega (100 - a)%. On olemas spetsiaalsed /-jaotuse tabelid, mis võimaldavad määrata kriteeriumi kriitilist väärtust etteantud olulisuse taseme a ja vabadusastmete arvu v järgi. Kõige sagedamini kasutatav a väärtus on 5%.

Multikollineaarsus, st. faktormuutujate vaheliste vastastikuste seoste mõju toob kaasa vajaduse olla rahul nende piiratud arvuga. Kui seda arvesse ei võeta, võib tulemuseks olla ebaloogiline regressioonimudel. Multikollineaarsuse negatiivse mõju vältimiseks arvutatakse enne mitme regressioonimudeli loomist paari korrelatsioonikordajad rxjxj valitud muutujate vahel X. Ja X

Siin XjX; - kahe faktoriaalmuutuja korrutise keskmine väärtus;

XjXj- kahe teguri muutuja keskmiste väärtuste korrutis;

Tegurmuutuja x dispersiooni hindamine..

Kaht muutujat peetakse regressiivselt seotud (st kollineaarseks), kui nende paaridevaheline korrelatsioonikordaja on absoluutväärtuses rangelt suurem kui 0,8. Sel juhul tuleks kõik neist muutujatest arvesse võtta.

Saadud regressioonimudelite majandusliku analüüsi võimaluste laiendamiseks kasutatakse keskmisi elastsuskoefitsiendid, määratakse valemiga:

kus Xj- vastava tegurimuutuja keskmine väärtus;

y - saadud muutuja keskmine väärtus; a i - vastava tegurimuutuja regressioonikordaja.

Elastsustegur näitab, mitu protsenti muutub keskmiselt saadud muutuja väärtus, kui tegurmuutuja muutub 1%, s.o. kuidas saadud muutuja reageerib tegurimuutuja muutusele. Näiteks kuidas kujuneb ruutmeetri hind? m suurune korter kesklinnast eemal.

Konkreetse regressioonikordaja olulisuse analüüsimise seisukohalt on kasulik hinnang privaatne määramise koefitsient:

Siin on tulemuse dispersiooni hinnang

muutuv. See koefitsient näitab, mitu protsenti on saadud muutuja kõikumine seletatav regressioonivõrrandis sisalduva /-nda faktori muutuja variatsiooniga.

- Hedoonilised omadused on objekti omadused, mis peegeldavad selle kasulikke (väärtuslikke) omadusi ostjate ja müüjate seisukohalt.

Õpingute ajal puutuvad õpilased väga sageli kokku mitmesuguste võrranditega. Ühte neist – regressioonivõrrandit – käsitletakse käesolevas artiklis. Seda tüüpi võrrandit kasutatakse spetsiaalselt matemaatiliste parameetrite vahelise seose omaduste kirjeldamiseks. Seda tüüpi võrdsust kasutatakse statistikas ja ökonomeetrias.

Regressiooni definitsioon

Matemaatikas mõistetakse regressiooni kui teatud suurust, mis kirjeldab andmekogumi keskmise väärtuse sõltuvust mõne teise suuruse väärtustest. Regressioonivõrrand näitab konkreetse tunnuse funktsioonina teise tunnuse keskmist väärtust. Regressioonifunktsioonil on lihtne võrrand y \u003d x, milles y toimib sõltuva muutujana ja x on sõltumatu muutuja (tunnustegur). Tegelikult väljendatakse regressiooni järgmiselt: y = f (x).

Millised on muutujatevahelised seosed

Üldiselt eristatakse kahte vastandlikku seost: korrelatsioon ja regressioon.

Esimest iseloomustab tingimuslike muutujate võrdsus. Sel juhul pole kindlalt teada, milline muutuja teisest sõltub.

Kui muutujate vahel puudub võrdsus ja tingimused ütlevad, milline muutuja on seletav ja milline sõltuv, siis saame rääkida teist tüüpi seose olemasolust. Lineaarse regressioonivõrrandi koostamiseks on vaja välja selgitada, millist tüüpi seost täheldatakse.

Regressioonide tüübid

Praeguseks on regressiooni 7 erinevat tüüpi: hüperboolne, lineaarne, mitmekordne, mittelineaarne, paariline, pöördvõrdeline, logaritmiliselt lineaarne.

Hüperboolne, lineaarne ja logaritmiline

Lineaarse regressiooni võrrandit kasutatakse statistikas võrrandi parameetrite selgeks selgitamiseks. Näib, et y = c + m * x + E. Hüperboolsel võrrandil on regulaarne hüperbool y \u003d c + m / x + E. Logaritmiliselt lineaarne võrrand väljendab seost logaritmilise funktsiooni abil: In y \u003d In c + m * In x + In E.

Mitmekordne ja mittelineaarne

Kaks keerukamat regressiooni tüüpi on mitmekordne ja mittelineaarne. Mitmekordse regressiooni võrrandit väljendab funktsioon y \u003d f (x 1, x 2 ... x c) + E. Selles olukorras on y sõltuv muutuja ja x selgitav muutuja. Muutuja E on stohhastiline ja sisaldab võrrandi teiste tegurite mõju. Mittelineaarse regressiooni võrrand on veidi vastuoluline. Ühelt poolt ei ole see arvessevõetavate näitajate osas lineaarne, teisest küljest on see näitajate hindamise rollis lineaarne.

Pöörd- ja paarisregressioonid

Pöördfunktsioon on teatud tüüpi funktsioon, mis tuleb teisendada lineaarseks vormiks. Kõige traditsioonilisemates rakendusprogrammides on see funktsioonina y \u003d 1 / c + m * x + E. Paaritud regressioonivõrrand näitab andmete vahelist seost funktsioonina y = f(x) + E. Nii nagu teised võrrandid, sõltub y x-st ja E on stohhastiline parameeter.

Korrelatsiooni mõiste

See on näitaja, mis näitab seose olemasolu kahe nähtuse või protsessi vahel. Seose tugevust väljendatakse korrelatsioonikordajana. Selle väärtus kõigub vahemikus [-1;+1]. Negatiivne indikaator näitab tagasiside olemasolu, positiivne indikaator näitab otsest tagasisidet. Kui koefitsiendi väärtus on 0, siis seost pole. Mida lähemal on väärtus 1-le – seda tugevam on seos parameetrite vahel, mida lähemal 0-le – seda nõrgem.

meetodid

Parameetriliste korrelatsioonimeetoditega saab hinnata seose tihedust. Neid kasutatakse jaotushinnangute alusel normaaljaotuse seadusele alluvate parameetrite uurimiseks.

Lineaarse regressioonivõrrandi parameetrid on vajalikud sõltuvuse tüübi, regressioonivõrrandi funktsiooni tuvastamiseks ja valitud seose valemi näitajate hindamiseks. Korrelatsioonivälja kasutatakse seose tuvastamise meetodina. Selleks tuleb kõik olemasolevad andmed esitada graafiliselt. Ristkülikukujulises kahemõõtmelises koordinaatsüsteemis tuleb joonistada kõik teadaolevad andmed. Nii moodustub korrelatsiooniväli. Kirjeldava teguri väärtus on märgitud piki abstsissi, sõltuva teguri väärtused aga piki ordinaati. Kui parameetrite vahel on funktsionaalne seos, reastuvad need joone kujul.

Kui selliste andmete korrelatsioonikoefitsient on alla 30%, võime rääkida peaaegu täielikust ühenduse puudumisest. Kui see on vahemikus 30% kuni 70%, näitab see keskmise lähedusega linkide olemasolu. 100% indikaator näitab funktsionaalset ühendust.

Mittelineaarset regressioonivõrrandit, nagu ka lineaarset, tuleb täiendada korrelatsiooniindeksiga (R).

Korrelatsioon mitmekordse regressiooni jaoks

Determinatsioonikoefitsient on mitmikkorrelatsiooni ruudu näitaja. Ta räägib esitatud näitajate kogumi seose tihedusest uuritava tunnusega. See võib rääkida ka parameetrite mõju olemusest tulemusele. Mitmekordse regressiooni võrrandit hinnatakse selle indikaatori abil.

Mitmekordse korrelatsiooniindeksi arvutamiseks on vaja arvutada selle indeks.

Vähima ruudu meetod

See meetod on regressioonitegurite hindamise viis. Selle olemus seisneb teguri sõltuvusest funktsioonist saadud hälvete ruudu summa minimeerimises.

Sellist meetodit kasutades saab hinnata paaris lineaarse regressiooni võrrandit. Seda tüüpi võrrandeid kasutatakse paaris lineaarse seose näitajate tuvastamisel.

Võrrandi valikud

Lineaarse regressioonifunktsiooni igal parameetril on konkreetne tähendus. Paariline lineaarse regressiooni võrrand sisaldab kahte parameetrit: c ja m. Parameeter t näitab funktsiooni y lõppnäitaja keskmist muutust, tingimusel et muutuja x väheneb (suurenemine) ühe kokkuleppelise ühiku võrra. Kui muutuja x on null, on funktsioon võrdne parameetriga c. Kui muutuja x ei ole null, siis ei ole teguril c majanduslikult mõtet. Ainus mõju funktsioonile on märk teguri c ees. Kui on miinus, siis võime öelda tulemuse aeglase muutumise kohta võrreldes teguriga. Kui pluss on, näitab see tulemuse kiirendatud muutust.

Iga parameetrit, mis muudab regressioonivõrrandi väärtust, saab väljendada võrrandi kaudu. Näiteks tegur c on kujul c = y - mx.

Grupeeritud andmed

On olemas sellised ülesande tingimused, kus kogu teave on rühmitatud atribuudi x järgi, kuid samal ajal näidatakse teatud rühma jaoks sõltuva indikaatori vastavad keskmised väärtused. Sel juhul iseloomustavad keskmised väärtused, kuidas indikaator sõltub x-st. Seega aitab grupeeritud info leida regressioonivõrrandit. Seda kasutatakse suhteanalüüsina. Sellel meetodil on aga omad puudused. Kahjuks on keskmised sageli väliste kõikumiste all. Need kõikumised ei peegelda suhte mustreid, vaid maskeerivad selle "müra". Keskmised näitavad seoste mustreid palju halvemini kui lineaarse regressiooni võrrand. Neid saab aga võtta aluseks võrrandi leidmisel. Korrutades konkreetse populatsiooni suuruse vastava keskmisega, saate rühmasisese y summa. Järgmiseks peate kõik laekunud summad välja lööma ja leidma lõpliku indikaatori y. Veidi keerulisem on arvutusi teha summanäitaja xy abil. Kui intervallid on väikesed, võime tinglikult võtta indikaatori x kõigi ühikute jaoks (grupi sees) samaks. Korrutage see y summaga, et leida x ja y korrutiste summa. Edasi lüüakse kõik summad kokku ja saadakse kogusumma xy.

Mitme paari võrrandi regressioon: suhte olulisuse hindamine

Nagu varem mainitud, on mitmekordse regressiooni funktsioon kujul y \u003d f (x 1, x 2, ..., x m) + E. Kõige sagedamini kasutatakse sellist võrrandit toote nõudluse ja pakkumise, tagasiostetud aktsiate intressitulu probleemi lahendamiseks, tootmiskulude funktsiooni põhjuste ja tüübi uurimisel. Seda kasutatakse aktiivselt ka mitmesugustes makroökonoomilistes uuringutes ja arvutustes, kuid mikroökonoomika tasandil kasutatakse sellist võrrandit veidi harvemini.

Mitmekordse regressiooni põhiülesanne on koostada tohutul hulgal teavet sisaldav andmemudel, et täpsemalt määrata, milline on iga teguri mõju individuaalselt ja tervikuna modelleeritavale näitajale ja selle koefitsientidele. Regressioonivõrrand võib võtta mitmesuguseid väärtusi. Sel juhul kasutatakse seose hindamiseks tavaliselt kahte tüüpi funktsioone: lineaarset ja mittelineaarset.

Lineaarne funktsioon on kujutatud sellise seose kujul: y \u003d a 0 + a 1 x 1 + a 2 x 2, + ... + a m x m. Sel juhul loetakse a2, a m "puhta" regressiooni koefitsientideks. Need on vajalikud parameetri y keskmise muutuse iseloomustamiseks iga vastava parameetri x muutumise (vähenemise või suurenemisega) ühe ühiku võrra, teiste näitajate stabiilse väärtuse tingimusel.

Mittelineaarsetel võrranditel on näiteks astmefunktsiooni kuju y=ax 1 b1 x 2 b2 ...x m bm . Sel juhul nimetatakse näitajaid b 1, b 2 ..... bm - elastsuskoefitsientideks, need näitavad, kuidas tulemus muutub (kui palju%) vastava näitaja x suurenemisel (vähenemisel) 1% võrra. ja muude tegurite stabiilse näitajaga.

Milliseid tegureid tuleks mitmekordse regressiooni koostamisel arvesse võtta

Mitmekordse regressiooni õigeks konstrueerimiseks tuleb välja selgitada, millistele teguritele tuleks erilist tähelepanu pöörata.

Majandustegurite ja modelleeritava vahelise seose olemusest on vaja teatud arusaama. Kaasatavad tegurid peavad vastama järgmistele kriteeriumidele:

- Peab olema mõõdetav. Objekti kvaliteeti kirjeldava teguri kasutamiseks tuleks sellele igal juhul anda kvantitatiivne vorm.

- Ei tohiks olla tegurite vastastikust korrelatsiooni ega funktsionaalset seost. Sellised toimingud põhjustavad enamasti pöördumatuid tagajärgi - tavaliste võrrandite süsteem muutub tingimusteta ja see toob kaasa selle ebausaldusväärsuse ja hägused hinnangud.

- Hiiglasliku korrelatsiooninäitaja puhul ei ole kuidagi võimalik välja selgitada tegurite isoleeritud mõju näitaja lõpptulemusele, mistõttu muutuvad koefitsiendid tõlgendamatuks.

Ehitusmeetodid

Võrrandi tegurite valimise selgitamiseks on tohutult palju meetodeid ja viise. Kõik need meetodid põhinevad aga koefitsientide valikul korrelatsiooniindeksi abil. Nende hulgas on:

- Välistamismeetod.

- Lülitage meetod sisse.

- Astmeline regressioonanalüüs.

Esimene meetod hõlmab kõigi koefitsientide väljasõelumist koondkomplektist. Teine meetod hõlmab paljude täiendavate tegurite kasutuselevõttu. Noh, kolmas on tegurite kõrvaldamine, mida võrrandile varem rakendati. Igal neist meetoditest on õigus eksisteerida. Neil on oma plussid ja miinused, kuid nad saavad omal moel lahendada mittevajalike näitajate väljasõelumise. Reeglina on iga üksiku meetodi abil saadud tulemused üsna lähedased.

Mitmemõõtmelise analüüsi meetodid

Sellised tegurite määramise meetodid põhinevad omavahel seotud tunnuste individuaalsete kombinatsioonide arvestamisel. Nende hulka kuuluvad diskriminantanalüüs, mustrituvastus, põhikomponentide analüüs ja klastrianalüüs. Lisaks on olemas ka faktoranalüüs, kuid see ilmnes komponentmeetodi väljatöötamise tulemusena. Kõiki neid rakendatakse teatud asjaoludel, teatud tingimustel ja teguritel.

Kaasaegne politoloogia lähtub positsioonist kõigi ühiskonnas toimuvate nähtuste ja protsesside seoste kohta. On võimatu mõista sündmusi ja protsesse, ennustada ja juhtida poliitilise elu nähtusi, uurimata ühiskonna poliitilises sfääris eksisteerivaid seoseid ja sõltuvusi. Poliitikauuringute üks levinumaid ülesandeid on uurida seoseid mõne vaadeldava muutuja vahel. Seda probleemi aitab lahendada terve hulk statistilisi analüüsimeetodeid, mida ühendab üldnimetus "regressioonanalüüs" (või, nagu seda nimetatakse ka "korrelatsioon-regressioonanalüüs"). Kui aga korrelatsioonianalüüs võimaldab hinnata kahe muutuja vahelise seose tugevust, siis regressioonanalüüsi abil on võimalik määrata selle seose tüüp, ennustada mis tahes muutuja väärtuse sõltuvust mõne teise muutuja väärtusest. .

Kõigepealt meenutagem, mis on korrelatsioon. Korrelatiivne nimetatakse statistilise seose kõige olulisemaks erijuhtumiks, mis seisneb selles, et ühe muutuja võrdsed väärtused vastavad erinevatele keskmised väärtused teine. Atribuudi x väärtuse muutumisel muutub loomulikult atribuudi y keskmine väärtus, samas kui igal üksikjuhul atribuudi väärtus juures(erineva tõenäosusega) võib võtta palju erinevaid väärtusi.

Mõiste "korrelatsioon" ilmumine statistikas (ja politoloogia meelitab oma probleemide lahendamiseks statistika saavutusi, mis on seega politoloogiaga seotud distsipliin) on seotud inglise bioloogi ja statistiku Francis Galtoni nimega, kes tegi ettepaneku 19. sajandil. korrelatsioon-regressioonanalüüsi teoreetilised alused. Mõiste "korrelatsioon" oli teaduses tuntud juba varem. Eelkõige paleontoloogias 18. sajandil. seda rakendas prantsuse teadlane Georges Cuvier. Ta tutvustas nn korrelatsiooniseadust, mille abil oli väljakaevamistel leitud loomade jäänuste järgi võimalik taastada nende välimus.

Selle teadlase nime ja tema korrelatsiooniseadusega on seotud tuntud lugu. Nii tõmbasid tudengid, kes otsustasid kuulsale professorile vingerpussi mängida, ülikoolivahepäevadel ühe õpilase peale sarvede ja kabjadega kitsenaha. Ta ronis Cuvier' magamistoa aknast sisse ja hüüdis: "Ma söön su ära." Professor ärkas, vaatas siluetti ja vastas: “Kui sul on sarved ja kabjad, siis oled rohusööja ega saa mind ära süüa. Ja korrelatsiooniseaduse mitteteadmise eest saate kahekohalise. Ta pöördus ümber ja jäi magama. Nali on nali, kuid selles näites näeme mitme korrelatsioon-regressioonanalüüsi kasutamise erijuhtu. Siin tuletas professor kahe vaadeldud tunnuse (sarvede ja sõrgade olemasolu) väärtuste teadmiste põhjal korrelatsiooniseaduse alusel kolmanda tunnuse (klass, kuhu see loom kuulub) keskmise väärtuse. on taimtoiduline). Sel juhul me ei räägi selle muutuja konkreetsest väärtusest (st see loom võib nominaalsel skaalal omandada erinevaid väärtusi - see võib olla kits, jäär või pull ...).

Liigume nüüd edasi mõiste "regressioon" juurde. Rangelt võttes ei ole see seotud nende statistiliste probleemide tähendusega, mida selle meetodi abil lahendatakse. Mõiste selgitust saab anda ainult tunnustevaheliste seoste uurimise meetodite kujunemisloo teadmiste põhjal. Üks esimesi sedalaadi uuringute näiteid oli statistikute F. Galtoni ja K. Pearsoni tööd, kes püüdsid leida mustrit isade ja nende laste kasvu vahel kahe jälgitava märgi järgi (kus X- isa pikkus ja U- laste kasv). Oma uuringus kinnitasid nad esialgset hüpoteesi, et keskmiselt kasvatavad pikad isad keskmiselt pikki lapsi. Sama põhimõte kehtib ka madalate isade ja laste kohta. Kui aga teadlased oleksid seal peatunud, poleks nende töid statistikaõpikutes kunagi mainitud. Teadlased leidsid juba mainitud kinnitatud hüpoteesi raames veel ühe mustri. Nad tõestasid, et väga pikad isad toodavad lapsi, kes on keskmiselt pikad, kuid mitte väga erineva pikkusega lastest, kelle isad, kuigi keskmisest kõrgemad, ei erine kuigivõrd keskmisest pikkusest. Sama kehtib ka väga väikese kasvuga isade kohta (lahknedes lühikese rühma keskmisest) - nende lapsed ei erinenud keskmiselt pikkuselt eakaaslastest, kelle isad olid lihtsalt lühikesed. Nad nimetasid seda regulaarsust kirjeldavat funktsiooni regressioonifunktsioon. Pärast seda uuringut hakati kõiki sarnaseid funktsioone kirjeldavaid ja sarnaselt konstrueeritud võrrandeid nimetama regressioonivõrranditeks.

Regressioonanalüüs on üks mitme muutujaga statistilise andmeanalüüsi meetoditest, mis ühendab statistiliste tehnikate komplekti, mis on mõeldud ühe sõltuva ja mitme (või ühe) sõltumatu muutuja vaheliste suhete uurimiseks või modelleerimiseks. Sõltuvat muutujat nimetatakse statistikas aktsepteeritud traditsiooni kohaselt vastuseks ja seda tähistatakse kui V Sõltumatuid muutujaid nimetatakse ennustajateks ja neid tähistatakse kui x. Analüüsi käigus on mõned muutujad vastusega nõrgalt seotud ja jäetakse lõpuks analüüsist välja. Ülejäänud sõltuvaga seotud muutujaid võib nimetada ka teguriteks.

Regressioonanalüüs võimaldab ennustada ühe või mitme muutuja väärtusi sõltuvalt teisest muutujast (näiteks kalduvus ebatavaliseks poliitiliseks käitumiseks sõltuvalt haridustasemest) või mitmest muutujast. Arvutatakse arvutis. Regressioonivõrrandi koostamiseks, mis võimaldab mõõta juhitava tunnuse sõltuvusastet faktoritest, on vaja kaasata professionaalsed matemaatikud-programmeerijad. Regressioonanalüüs võib pakkuda hindamatut teenust poliitilise olukorra arengu ennustavate mudelite koostamisel, sotsiaalsete pingete põhjuste hindamisel ja teoreetiliste eksperimentide läbiviimisel. Regressioonanalüüsi kasutatakse aktiivselt selleks, et uurida mitmete sotsiaaldemograafiliste parameetrite mõju kodanike valimiskäitumisele: sugu, vanus, elukutse, elukoht, rahvus, sissetuleku tase ja laad.

Seoses regressioonanalüüsiga mõisted sõltumatu Ja sõltuv muutujad. Sõltumatu muutuja on muutuja, mis selgitab või põhjustab muutusi mõnes teises muutujas. Sõltuv muutuja on muutuja, mille väärtus on seletatav esimese muutuja mõjuga. Näiteks 2004. aasta presidendivalimistel olid määravad tegurid, s.o. sõltumatuteks muutujateks olid sellised näitajad nagu riigi elanikkonna finantsolukorra stabiliseerumine, kandidaatide populaarsuse tase ja tegur ametisolekul. Sel juhul võib kandidaatidele antud häälte protsenti pidada sõltuvaks muutujaks. Samamoodi on muutujate paaris “valija vanus” ja “valimisaktiivsuse tase” esimene sõltumatu, teine sõltuv.

Regressioonanalüüs võimaldab teil lahendada järgmised probleemid:

- 1) tuvastab Ci vahelise statistiliselt olulise seose olemasolu või puudumise x;

- 2) koostab regressioonifunktsiooni parimad (statistilises mõttes) hinnangud;

- 3) vastavalt etteantud väärtustele X koostage ennustus tundmatu jaoks Kell

- 4) hindab iga teguri mõju erikaalu X peal Kell ja vastavalt sellele välistada mudelist ebaolulised omadused;

- 5) tuvastades muutujate vahelisi põhjuslikke seoseid, hallata osaliselt P väärtusi, kohandades selgitavate muutujate väärtusi x.

Regressioonanalüüs on seotud vajadusega valida uuritava indikaatori väärtust mõjutavad vastastikku sõltumatud muutujad, määrata regressioonivõrrandi vorm ja hinnata parameetreid esmaste sotsioloogiliste andmete töötlemise statistiliste meetodite abil. Seda tüüpi analüüs põhineb ideel suhte vormist, suunast ja lähedusest (tihedusest). Eristama leiliruum Ja mitmekordne regressioon olenevalt uuritud tunnuste arvust. Praktikas tehakse regressioonanalüüsi tavaliselt koos korrelatsioonianalüüsiga. Regressioonivõrrand kirjeldab suuruste vahelist arvulist seost, mida väljendatakse tendentsina, et üks muutuja suureneb või väheneb, samal ajal kui teine suureneb või väheneb. Samal ajal razl ja h a yut l härmatis Ja mittelineaarne regressioon. Poliitiliste protsesside kirjeldamisel leitakse võrdselt mõlemad regressioonivariandid.

Huvijoonis poliitiliste artiklite vastastikuse sõltuvuse jaotamiseks ( U) ja vastajate haridus (X) on lineaarne regressioon (joonis 30).

Riis. kolmkümmend.

Valimisaktiivsuse taseme jaotuse hajuvusskeem ( U) ja vastaja vanus (A) (tinglik näide) on mittelineaarne regressioon (joonis 31).

Riis. 31.

Kahe tunnuse (A ja Y) seose kirjeldamiseks paaris regressioonimudelis kasutatakse lineaarset võrrandit

![]()

kus a, on võrrandi vea juhuslik väärtus koos tunnuste varieerumisega, st. võrrandi kõrvalekalle "lineaarsusest".

Koefitsientide hindamiseks aga Ja b kasutada vähimruutude meetodit, mis eeldab, et hajuvusgraafiku iga punkti ruudus kõrvalekalde summa regressioonijoonest peaks olema minimaalne. Koefitsiendid a h b saab arvutada võrrandisüsteemi abil:

Vähimruutude hindamise meetod annab sellised koefitsientide hinnangud aga Ja b, mille puhul sirge koordinaatidega punkti läbib X Ja y, need. on suhe juures = kirves + b. Regressioonivõrrandi graafilist esitust nimetatakse teoreetiline regressioonisirge. Lineaarse sõltuvuse korral esindab regressioonikordaja graafikul teoreetilise regressioonijoone kalde puutujat x-telje suhtes. Koefitsiendi juures olev märk näitab ühenduse suunda. Kui see on suurem kui null, on seos otsene, kui see on väiksem, siis pöördvõrdeline.

Järgnev näide uuringust "Political Petersburg-2006" (tabel 56) näitab lineaarset seost kodanike arusaamade vahel oma eluga rahulolu tasemest olevikus ja ootuste vahel elukvaliteedi muutustele tulevikus. Seos on otsene, lineaarne (standardiseeritud regressioonikordaja on 0,233, olulisuse nivoo on 0,000). Sel juhul ei ole regressioonikordaja kõrge, kuid see ületab statistiliselt olulise näitaja alampiiri (Pearsoni koefitsiendi statistiliselt olulise näitaja ruudu alumine piir).

Tabel 56

Kodanike elukvaliteedi mõju ootustele olevikus

(Peterburi, 2006)

* Sõltuv muutuja: "Kuidas teie arvates teie elu järgmise 2-3 aasta jooksul muutub?"

Poliitilises elus sõltub uuritava muutuja väärtus kõige sagedamini korraga mitmest tunnusest. Näiteks poliitilise aktiivsuse taset ja olemust mõjutavad üheaegselt riigi poliitiline režiim, poliitilised traditsioonid, inimeste poliitilise käitumise iseärasused antud piirkonnas ja vastaja sotsiaalne mikrogrupp, tema vanus, haridus, sissetulek. tase, poliitiline orientatsioon jne. Sel juhul peate kasutama võrrandit mitmekordne regressioon, millel on järgmine vorm:

kus koefitsient b.- osalise regressiooni koefitsient. See näitab iga sõltumatu muutuja panust sõltumatu (tulemuse) muutuja väärtuste määramisel. Kui osalise regressiooni koefitsient on nullilähedane, siis võime järeldada, et sõltumatute ja sõltuvate muutujate vahel otsest seost ei ole.

Sellise mudeli saab arvutada arvutis maatriksalgebra abil. Mitmekordne regressioon võimaldab kajastada sotsiaalsete sidemete mitmefaktorilist olemust ja selgitada iga teguri mõju mõõtu individuaalselt ja kõik koos sellest tulenevale tunnusele.

Koefitsient tähistatud b, nimetatakse lineaarse regressiooni koefitsiendiks ja see näitab faktortunnuse variatsiooni vahelise seose tugevust X ja efektiivse funktsiooni variatsioon Y See koefitsient mõõdab seose tugevust tunnuste absoluutsetes mõõtühikutes. Tunnuste korrelatsiooni lähedust saab aga väljendada ka saadud tunnuse standardhälbe kaudu (sellist koefitsienti nimetatakse korrelatsioonikordajaks). Erinevalt regressioonikoefitsiendist b korrelatsioonikoefitsient ei sõltu tunnuste aktsepteeritud mõõtühikutest ja seetõttu on see võrreldav kõigi tunnuste puhul. Tavaliselt peetakse ühendust tugevaks, kui /> 0,7, keskmise tihedusega - 0,5 g juures 0,5.

Nagu teate, on lähim seos funktsionaalne ühendus, kui iga üksik väärtus on Y saab väärtusele unikaalselt määrata x. Seega, mida lähemal on korrelatsioonikordaja 1-le, seda lähemal on seos funktsionaalsele. Regressioonanalüüsi olulisuse tase ei tohiks ületada 0,001.

Korrelatsioonikordajat on pikka aega peetud tunnuste seose läheduse peamiseks näitajaks. Hiljem sai aga selliseks näitajaks determinatsioonikoefitsient. Selle koefitsiendi tähendus on järgmine - see peegeldab saadud tunnuse kogu dispersiooni osakaalu Kell, mis on seletatav tunnuse dispersiooniga x. See leitakse korrelatsioonikordaja lihtsalt ruudustamisel (muutub 0-lt 1-le) ja omakorda peegeldab lineaarse seose osakaalu 0-st (0%). 1 (100%) iseloomulikud väärtused jah määratud atribuudi väärtustega x. See on salvestatud kui ma 2, ja saadud regressioonanalüüsi tabelites SPSS-paketis - ilma ruuduta.

Tähistame mitmekordse regressiooni võrrandi koostamise põhiprobleeme.

- 1. Regressioonivõrrandis sisalduvate tegurite valik. Selles etapis koostab teadlane esmalt üldise loetelu peamistest põhjustest, mis teooria kohaselt määravad uuritava nähtuse. Seejärel peab ta valima regressioonivõrrandi tunnused. Peamine valikureegel on, et analüüsi kaasatud tegurid peaksid omavahel võimalikult vähe korreleeruma; ainult sel juhul on võimalik teatud faktori-atribuudile omistada mõju kvantitatiivne mõõt.

- 2. Mitme regressioonivõrrandi vormi valimine(praktikas kasutatakse sagedamini lineaarset või lineaarlogaritmilist). Nii et mitmekordse regressiooni kasutamiseks peab uurija esmalt koostama hüpoteetilise mudeli mitme sõltumatu muutuja mõjust saadud muutujale. Et saadud tulemused oleksid usaldusväärsed, on vajalik, et mudel vastaks täpselt tegelikule protsessile, s.t. muutujate vaheline seos peab olema lineaarne, tähelepanuta ei saa jätta ainsatki olulist sõltumatut muutujat, samuti ei saa analüüsi kaasata ühtki muutujat, mis ei ole otseselt seotud uuritava protsessiga. Lisaks peavad kõik muutujate mõõtmised olema ülitäpsed.

Ülaltoodud kirjeldusest tuleneb selle meetodi rakendamiseks mitmeid tingimusi, ilma milleta on võimatu jätkata mitmekordse regressioonanalüüsi (MRA) protseduuri. Ainult kõigi järgmiste punktide järgimine võimaldab korrektselt regressioonianalüüsi läbi viia.

- Kokkupuutel 0

- Google+ 0

- Okei 0

- Facebook 0