Regressionsanalys är en metod för att etablera ett analytiskt uttryck för ett stokastiskt samband mellan de studerade dragen. Regressionsekvationen visar hur i genomsnitt förändras på när du ändrar någon av x i , och ser ut som:

var y - beroende variabel (det är alltid en);

X i - oberoende variabler (faktorer) (det kan finnas flera av dem).

Om det bara finns en oberoende variabel är detta en enkel regressionsanalys. Om det är flera P  2),

då kallas en sådan analys multivariat.

2),

då kallas en sådan analys multivariat.

Under regressionsanalysen löses två huvuduppgifter:

konstruktion av regressionsekvationen, dvs. hitta typen av samband mellan resultatindikatorn och oberoende faktorer x 1 , x 2 , …, x n .

bedömning av betydelsen av den resulterande ekvationen, dvs. bestämning av hur mycket de valda faktoregenskaperna förklarar funktionens variation y.

Regressionsanalys används främst för planering, samt för utveckling av ett regelverk.

Till skillnad från korrelationsanalys, som endast svarar på frågan om det finns ett samband mellan de analyserade dragen, ger regressionsanalysen också sitt formaliserade uttryck. Dessutom, om korrelationsanalysen studerar något samband av faktorer, så studerar regressionsanalysen ensidigt beroende, d.v.s. ett samband som visar hur en förändring i faktortecken påverkar det resulterande tecknet.

Regressionsanalys är en av de mest utvecklade metoderna för matematisk statistik. Strängt taget kräver implementeringen av regressionsanalys uppfyllandet av ett antal särskilda krav (särskilt, x l ,x 2 ,...,x n ;y måste vara oberoende, normalfördelade stokastiska variabler med konstanta varianser). I det verkliga livet är strikt efterlevnad av kraven för regressions- och korrelationsanalys mycket sällsynt, men båda dessa metoder är mycket vanliga inom ekonomisk forskning. Beroenden i ekonomin kan inte bara vara direkta, utan också inversa och icke-linjära. En regressionsmodell kan byggas i närvaro av vilket beroende som helst, men i multivariatanalys används endast linjära modeller av formen:

Konstruktionen av regressionsekvationen utförs som regel med minsta kvadratmetoden, vars kärna är att minimera summan av kvadrerade avvikelser av de faktiska värdena för det resulterande attributet från dess beräknade värden, dvs:

var T - antal observationer;

j

=a+b 1 x 1 j +b 2 x 2 j + ... + b n X n j

-

beräknat värde av resultatfaktorn.

j

=a+b 1 x 1 j +b 2 x 2 j + ... + b n X n j

-

beräknat värde av resultatfaktorn.

Regressionskoefficienter rekommenderas att bestämmas med hjälp av analytiska paket för en persondator eller en speciell finansiell miniräknare. I det enklaste fallet, regressionskoefficienterna för en linjär enfaktors regressionsekvation av formen y = a + bx kan hittas med formlerna:

klusteranalys

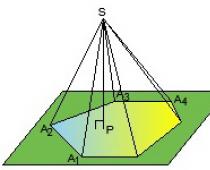

Klusteranalys är en av metoderna för multivariat analys, designad för att gruppera (klustera) en population, vars element kännetecknas av många funktioner. Värdena för var och en av funktionerna fungerar som koordinaterna för varje enhet av den studerade befolkningen i det flerdimensionella utrymmet av funktioner. Varje observation, som kännetecknas av värden för flera indikatorer, kan representeras som en punkt i utrymmet för dessa indikatorer, vars värden betraktas som koordinater i ett flerdimensionellt utrymme. Avstånd mellan punkter R Och q från k koordinater definieras som:

Huvudkriteriet för klustring är att skillnaderna mellan kluster ska vara mer signifikanta än mellan observationer som tilldelats samma kluster, d.v.s. i ett flerdimensionellt utrymme måste ojämlikheten observeras:

var r 1, 2 - avstånd mellan kluster 1 och 2.

Förutom regressionsanalysprocedurerna är klustringsproceduren ganska mödosam, det är tillrådligt att utföra det på en dator.

Huvudmålet med regressionsanalys består i att bestämma den analytiska formen av sambandet, där förändringen i det resulterande attributet beror på inverkan av ett eller flera faktortecken, och mängden av alla andra faktorer som också påverkar det resulterande attributet tas som konstanta och medelvärden. .Uppgifter för regressionsanalys:

a) Fastställande av beroendeform. När det gäller karaktären och formen på sambandet mellan fenomen finns det positiv linjär och icke-linjär och negativ linjär och icke-linjär regression.

b) Definition av regressionsfunktionen i form av en matematisk ekvation av en eller annan typ och fastställande av förklaringsvariablers inflytande på den beroende variabeln.

c) Uppskattning av okända värden för den beroende variabeln. Med hjälp av regressionsfunktionen kan du reproducera värdena för den beroende variabeln inom intervallet för givna värden för de förklarande variablerna (dvs lösa interpolationsproblemet) eller utvärdera processens förlopp utanför det angivna intervallet (dvs. lösa extrapoleringsproblemet). Resultatet är en uppskattning av värdet av den beroende variabeln.

Parregression - ekvationen för förhållandet mellan två variabler y och x: y=f(x), där y är den beroende variabeln (resultant tecken); x - oberoende, förklarande variabel (feature-factor).

Det finns linjära och icke-linjära regressioner.

Linjär regression: y = a + bx + ε

Icke-linjära regressioner delas in i två klasser: regressioner som är icke-linjära med avseende på de förklarande variablerna som ingår i analysen, men linjära med avseende på de estimerade parametrarna, och regressioner som är olinjära med avseende på de estimerade parametrarna.

Regressioner som är icke-linjära i förklarande variabler:

Regressioner som är icke-linjära i de uppskattade parametrarna:

- potens y=a x b ε

- exponentiell y=a b x ε

- exponentiell y=e a+b x ε

För linjära och icke-linjära ekvationer som kan reduceras till linjära, löses följande system för a och b:

Du kan använda färdiga formler som följer av detta system:

Närheten till sambandet mellan de studerade fenomenen uppskattas av den linjära parets korrelationskoefficient r xy för linjär regression (-1≤r xy ≤1):

och korrelationsindex p xy - för icke-linjär regression (0≤p xy ≤1):

En bedömning av kvaliteten på den konstruerade modellen kommer att ges av bestämningskoefficienten (index) samt det genomsnittliga approximationsfelet.

Det genomsnittliga approximationsfelet är den genomsnittliga avvikelsen för de beräknade värdena från de faktiska:

Tillåten gräns för värden A - inte mer än 8-10%.

Den genomsnittliga elasticitetskoefficienten E visar hur många procent, i genomsnitt, resultatet y kommer att ändras från sitt medelvärde i genomsnitt när faktorn x ändras med 1 % från sitt medelvärde:

.

Uppgiften med variansanalys är att analysera variansen för den beroende variabeln:

∑(y-y )²=∑(y x -y )²+∑(y-y x)²

där ∑(y-y)² är den totala summan av kvadrerade avvikelser;

∑(y x -y)² - summan av kvadrerade avvikelser på grund av regression ("förklarad" eller "faktoriell");

∑(y-y x)² - restsumman av kvadrerade avvikelser.

Andelen av variansen som förklaras av regression i den totala variansen av den effektiva egenskapen y kännetecknas av koefficienten (index) för bestämning R2:

Bestämningskoefficienten är kvadraten på koefficienten eller korrelationsindexet.

F-test - utvärdering av kvaliteten på regressionsekvationen - består i att testa hypotesen Men om regressionsekvationens statistiska insignifikans och indikatorn på sambandsnärhet. För detta utförs en jämförelse av det faktiska F-faktumet och den kritiska (tabellformiga) F-tabellen av värdena för Fisher F-kriteriet. F-faktum bestäms av förhållandet mellan värdena för faktoriella och resterande varianser beräknade för en frihetsgrad:  ,

,

där n är antalet befolkningsenheter; m är antalet parametrar för variabler x.

F-tabellen är det maximalt möjliga värdet av kriteriet under påverkan av slumpmässiga faktorer för givna frihetsgrader och signifikansnivå a. Signifikansnivå a - sannolikheten att förkasta den korrekta hypotesen, förutsatt att den är sann. Vanligtvis tas a lika med 0,05 eller 0,01.

Om F tabell< F факт, то Н о - гипотеза о случайной природе оцениваемых характеристик отклоняется и признается их статистическая значимость и надежность. Если F табл >F är ett faktum, då förkastas inte hypotesen H om och den statistiska insignifikansen, regressionsekvationens opålitlighet erkänns.

För att bedöma den statistiska signifikansen av regressions- och korrelationskoefficienterna, beräknas Students t-test och konfidensintervall för var och en av indikatorerna. En hypotes H om indikatorernas slumpmässiga karaktär läggs fram, d.v.s. om deras obetydliga skillnad från noll. Bedömningen av betydelsen av regressions- och korrelationskoefficienterna med hjälp av studentens t-test utförs genom att jämföra deras värden med storleken på det slumpmässiga felet:

; ; .

Slumpmässiga fel för linjära regressionsparametrar och korrelationskoefficient bestäms av formlerna:

Genom att jämföra de faktiska och kritiska (tabell)värdena för t-statistik - t tabl och t fact - accepterar eller förkastar vi hypotesen H o.

Sambandet mellan Fishers F-test och Students t-statistik uttrycks av likheten

Om t tabell< t факт то H o отклоняется, т.е. a , b и r xy не случайно отличаются от нуля и сформировались под влиянием систематически действующего фактора х. Если t табл >t det faktum att hypotesen H om inte förkastas och slumpmässigheten av bildningen av a, b eller r xy erkänns.

För att beräkna konfidensintervallet bestämmer vi marginalfelet D för varje indikator:

Δa =t tabell ma, Δb =t tabell m b.

Formlerna för att beräkna konfidensintervall är följande:

γ a \u003d aΔ a; γ a \u003d a-Δ a; ya =a+Aa

yb = bAb; yb = b-Ab; yb =b+Ab

Om noll faller inom gränserna för konfidensintervallet, d.v.s. Om den undre gränsen är negativ och den övre gränsen är positiv, antas den uppskattade parametern vara noll, eftersom den inte samtidigt kan anta både positiva och negativa värden.

Prognosvärdet y p bestäms genom att ersätta motsvarande (prognos) värde x p i regressionsekvationen y x =a+b·x . Det genomsnittliga standardfelet för prognosen m y x beräknas:  ,

,

var

och konfidensintervallet för prognosen byggs:

yyx =yp Δyp; yyxmin=yp-Δyp; y y x max=y p +Δ y p

där Δ y x =t tabell ·m y x .

Lösningsexempel

Uppgift nummer 1. För sju territorier i Ural-regionen För 199X är värdena för två tecken kända.Bord 1.

Nödvändig: 1. För att karakterisera beroendet av y på x, beräkna parametrarna för följande funktioner:

a) linjär;

b) maktlag (tidigare är det nödvändigt att utföra proceduren för linearisering av variabler genom att ta logaritmen för båda delarna);

c) demonstrativt;

d) liksidig hyperbel (du måste också ta reda på hur du förlinjärisera denna modell).

2. Utvärdera varje modell genom det genomsnittliga approximationsfelet A och Fishers F-test.

Lösning (alternativ #1)

För att beräkna parametrarna a och b för den linjära regressionen y=a+b·x (beräkningen kan göras med hjälp av en miniräknare).lösa normalekvationssystemet med avseende på men Och b:

Baserat på initialdata beräknar vi ∑y, ∑x, ∑y x, ∑x², ∑y²:

| y | x | yx | x2 | y2 | y x | y-y x | Ai | |

| l | 68,8 | 45,1 | 3102,88 | 2034,01 | 4733,44 | 61,3 | 7,5 | 10,9 |

| 2 | 61,2 | 59,0 | 3610,80 | 3481,00 | 3745,44 | 56,5 | 4,7 | 7,7 |

| 3 | 59,9 | 57,2 | 3426,28 | 3271,84 | 3588,01 | 57,1 | 2,8 | 4,7 |

| 4 | 56,7 | 61,8 | 3504,06 | 3819,24 | 3214,89 | 55,5 | 1,2 | 2,1 |

| 5 | 55,0 | 58,8 | 3234,00 | 3457,44 | 3025,00 | 56,5 | -1,5 | 2,7 |

| 6 | 54,3 | 47,2 | 2562,96 | 2227,84 | 2948,49 | 60,5 | -6,2 | 11,4 |

| 7 | 49,3 | 55,2 | 2721,36 | 3047,04 | 2430,49 | 57,8 | -8,5 | 17,2 |

| Total | 405,2 | 384,3 | 22162,34 | 21338,41 | 23685,76 | 405,2 | 0,0 | 56,7 |

| ons värde (Totalt/n) | 57,89 y | 54,90 x | 3166,05 x y | 3048,34 x² | 3383,68 y² | X | X | 8,1 |

| s | 5,74 | 5,86 | X | X | X | X | X | X |

| s2 | 32,92 | 34,34 | X | X | X | X | X | X |

a=y -b x = 57,89+0,35 54,9 ≈ 76,88

Regressions ekvation: y= 76,88 - 0,35X. Med en ökning av den genomsnittliga dagslönen med 1 gnugga. andelen utgifter för inköp av livsmedel minskas med i genomsnitt 0,35 procentenheter.

Beräkna den linjära koefficienten för parkorrelation: ![]()

Kommunikationen är måttlig, omvänd.

Låt oss bestämma bestämningskoefficienten: r² xy =(-0,35)=0,127

Variationen på 12,7 % i resultatet förklaras av variationen i x-faktorn. Ersätter de faktiska värdena i regressionsekvationen X, bestämmer vi de teoretiska (beräknade) värdena för y x . Låt oss hitta värdet på det genomsnittliga approximationsfelet A:

I genomsnitt avviker de beräknade värdena från de faktiska med 8,1%.

Låt oss beräkna F-kriteriet:

Det erhållna värdet indikerar behovet av att acceptera hypotesen H 0 om den slumpmässiga karaktären av det avslöjade beroendet och den statistiska insignifikansen för parametrarna i ekvationen och indikatorn för anslutningens täthet.

Ib. Konstruktionen av potensmodellen y=a x b föregås av förfarandet för linearisering av variabler. I exemplet görs linearisering genom att ta logaritmen för båda sidor av ekvationen:

lg y=lg a + b lg x

Y=C+b Y

där Y=lg(y), X=lg(x), C=lg(a).

För beräkningar använder vi data i Tabell. 1.3.

Tabell 1.3

| Y | X | YX | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 1,6542 | 3,0398 | 3,3768 | 2,7364 | 61,0 | 7,8 | 60,8 | 11,3 |

| 2 | 1,7868 | 1,7709 | 3,1642 | 3,1927 | 3,1361 | 56,3 | 4,9 | 24,0 | 8,0 |

| 3 | 1,7774 | 1,7574 | 3,1236 | 3,1592 | 3,0885 | 56,8 | 3,1 | 9,6 | 5,2 |

| 4 | 1,7536 | 1,7910 | 3,1407 | 3,0751 | 3,2077 | 55,5 | 1,2 | 1,4 | 2,1 |

| 5 | 1,7404 | 1,7694 | 3,0795 | 3,0290 | 3,1308 | 56,3 | -1,3 | 1,7 | 2,4 |

| 6 | 1,7348 | 1,6739 | 2,9039 | 3,0095 | 2,8019 | 60,2 | -5,9 | 34,8 | 10,9 |

| 7 | 1,6928 | 1,7419 | 2,9487 | 2,8656 | 3,0342 | 57,4 | -8,1 | 65,6 | 16,4 |

| Total | 12,3234 | 12,1587 | 21,4003 | 21,7078 | 21,1355 | 403,5 | 1,7 | 197,9 | 56,3 |

| Betyda | 1,7605 | 1,7370 | 3,0572 | 3,1011 | 3,0194 | X | X | 28,27 | 8,0 |

| σ | 0,0425 | 0,0484 | X | X | X | X | X | X | X |

| σ2 | 0,0018 | 0,0023 | X | X | X | X | X | X | X |

Beräkna C och b:

C=Y -b X = 1,7605+0,298 1,7370 = 2,278126

Vi får en linjär ekvation: Y=2,278-0,298 X

Efter att ha potentierat den får vi: y=10 2,278 x -0,298

Ersätter i denna ekvation de faktiska värdena X, vi får de teoretiska värdena för resultatet. Baserat på dem beräknar vi indikatorerna: anslutningens täthet - korrelationsindexet p xy och det genomsnittliga approximationsfelet A .

Effektmodellens egenskaper tyder på att den beskriver sambandet något bättre än den linjära funktionen.

1c. Konstruktionen av ekvationen för exponentialkurvan y \u003d a b x föregås av proceduren för att linearisera variablerna när man tar logaritmen för båda delarna av ekvationen:

lg y=lg a + x lg b

Y=C+B x

För beräkningar använder vi tabelldata.

| Y | x | Yx | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 45,1 | 82,8758 | 3,3768 | 2034,01 | 60,7 | 8,1 | 65,61 | 11,8 |

| 2 | 1,7868 | 59,0 | 105,4212 | 3,1927 | 3481,00 | 56,4 | 4,8 | 23,04 | 7,8 |

| 3 | 1,7774 | 57,2 | 101,6673 | 3,1592 | 3271,84 | 56,9 | 3,0 | 9,00 | 5,0 |

| 4 | 1,7536 | 61,8 | 108,3725 | 3,0751 | 3819,24 | 55,5 | 1,2 | 1,44 | 2,1 |

| 5 | 1,7404 | 58,8 | 102,3355 | 3,0290 | 3457,44 | 56,4 | -1,4 | 1,96 | 2,5 |

| 6 | 1,7348 | 47,2 | 81,8826 | 3,0095 | 2227,84 | 60,0 | -5,7 | 32,49 | 10,5 |

| 7 | 1,6928 | 55,2 | 93,4426 | 2,8656 | 3047,04 | 57,5 | -8,2 | 67,24 | 16,6 |

| Total | 12,3234 | 384,3 | 675,9974 | 21,7078 | 21338,41 | 403,4 | -1,8 | 200,78 | 56,3 |

| ons zn. | 1,7605 | 54,9 | 96,5711 | 3,1011 | 3048,34 | X | X | 28,68 | 8,0 |

| σ | 0,0425 | 5,86 | X | X | X | X | X | X | X |

| σ2 | 0,0018 | 34,339 | X | X | X | X | X | X | X |

Värdena för regressionsparametrarna A och I uppgick till:

A=Y -B x = 1,7605+0,0023 54,9 = 1,887

En linjär ekvation erhålls: Y=1,887-0,0023x. Vi potentierar den resulterande ekvationen och skriver den i vanlig form:

y x =10 1,887 10 -0,0023x = 77,1 0,9947 x

Vi uppskattar förhållandets täthet genom korrelationsindexet p xy:

Regressionsanalys ligger till grund för skapandet av de flesta ekonometriska modeller, bland vilka bör inkluderas kostnadsuppskattningsmodellerna. För att bygga värderingsmodeller kan denna metod användas om antalet analoger (jämförbara objekt) och antalet kostnadsfaktorer (jämförelseelement) korrelerar med varandra enligt följande: P> (5 -g-10) x till, de där. det borde finnas 5-10 gånger fler analoger än kostnadsfaktorer. Samma krav på förhållandet mellan mängden data och antalet faktorer gäller för andra uppgifter: fastställa ett förhållande mellan kostnaden och konsumentparametrarna för ett objekt; motivering av förfarandet för beräkning av korrigerande index; klargörande av pristrender; etablera ett samband mellan slitage och förändringar i påverkande faktorer; erhållande av beroenden för beräkning av kostnadsnormer m.m. Uppfyllelsen av detta krav är nödvändigt för att minska sannolikheten att arbeta med ett dataurval som inte uppfyller kravet på normalfördelning av slumpvariabler.

Regressionssambandet speglar endast den genomsnittliga trenden för den resulterande variabeln, såsom kostnad, från förändringar i en eller flera faktorvariabler, såsom plats, antal rum, yta, våning, etc. Detta är skillnaden mellan ett regressionsförhållande och ett funktionellt, där värdet på den resulterande variabeln är strikt definierat för ett givet värde av faktorvariabler.

Förekomsten av ett regressionsförhållande / mellan de resulterande på och faktorvariabler x sid ..., x k(faktorer) indikerar att detta samband inte bara bestäms av påverkan av de valda faktorvariablerna, utan också av påverkan av variabler, av vilka några är allmänt okända, andra kan inte bedömas och beaktas:

Inverkan av variabler som inte har redovisats betecknas med den andra termen i denna ekvation ?, som kallas approximationsfelet.

Det finns följande typer av regressionsberoende:

- ? parad regression - förhållandet mellan två variabler (resultant och faktoriell);

- ? multipel regression - beroende av en resulterande variabel och två eller flera faktorvariabler som ingår i studien.

Huvuduppgiften för regressionsanalys är att kvantifiera närheten av sambandet mellan variabler (i parad regression) och multipla variabler (i multipel regression). Förhållandets täthet kvantifieras av korrelationskoefficienten.

Användningen av regressionsanalys gör att du kan fastställa regelbundenheten i påverkan av huvudfaktorerna (hedoniska egenskaper) på indikatorn som studeras, både i sin helhet och var och en av dem individuellt. Med hjälp av regressionsanalys, som metod för matematisk statistik, är det möjligt att dels hitta och beskriva formen för den resulterande (önskade) variabelns analytiska beroende av de faktoriella och dels att uppskatta hur nära detta beroende.

Genom att lösa det första problemet erhålls en matematisk regressionsmodell med hjälp av vilken den önskade indikatorn sedan beräknas för givna faktorvärden. Lösningen av det andra problemet gör det möjligt att fastställa tillförlitligheten hos det beräknade resultatet.

Således kan regressionsanalys definieras som en uppsättning formella (matematiska) procedurer utformade för att mäta tätheten, riktningen och det analytiska uttrycket av formen av sambandet mellan de resulterande variablerna och faktorvariablerna, dvs. resultatet av en sådan analys bör vara en strukturellt och kvantitativt definierad statistisk modell av formen:

![]()

var y - medelvärdet av den resulterande variabeln (den önskade indikatorn, till exempel kostnad, hyra, kapitaliseringsgrad) över P hennes iakttagelser; x är värdet av faktorvariabeln (/-:te kostnadsfaktorn); till - antal faktorvariabler.

Fungera f(x l ,...,x lc), att beskriva beroendet av den resulterande variabeln av de faktoriella kallas regressionsekvationen (funktion). Termen "regression" (regression (lat.) - retirera, återgå till något) är förknippad med detaljerna i en av de specifika uppgifterna som löstes i det skede då metoden bildades, och återspeglar för närvarande inte hela essensen av metoden, men fortsätter att användas.

Regressionsanalys inkluderar i allmänhet följande steg:

- ? bildande av ett urval av homogena objekt och insamling av initial information om dessa objekt;

- ? urval av de viktigaste faktorerna som påverkar den resulterande variabeln;

- ? kontrollerar provet för normalitet med hjälp av X 2 eller binomialkriterium;

- ? acceptans av hypotesen om kommunikationsformen;

- ? matematisk databehandling;

- ? erhållande av en regressionsmodell;

- ? utvärdering av dess statistiska indikatorer;

- ? verifieringsberäkningar med hjälp av en regressionsmodell;

- ? analys av resultat.

Den specificerade sekvensen av operationer äger rum i studien av både ett parsamband mellan en faktorvariabel och en resulterande variabel, och ett multipelsamband mellan den resulterande variabeln och flera faktorvariabler.

Användningen av regressionsanalys ställer vissa krav på den initiala informationen:

- ? ett statistiskt urval av objekt bör vara homogent i funktionella och konstruktiv-teknologiska termer;

- ? ganska många;

- ? kostnadsindikatorn som studeras - den resulterande variabeln (pris, kostnad, kostnader) - måste reduceras till samma villkor för dess beräkning för alla objekt i urvalet;

- ? faktorvariabler måste mätas tillräckligt noggrant;

- ? faktorvariabler måste vara oberoende eller minimalt beroende.

Kraven på provets homogenitet och fullständighet är i konflikt: ju striktare urvalet av objekt utförs enligt deras homogenitet, desto mindre är urvalet, och omvänt, för att förstora urvalet, är det nödvändigt att inkludera objekt som är inte särskilt lika varandra.

Efter att data har samlats in för en grupp homogena objekt analyseras de för att fastställa formen av sambandet mellan de resulterande och faktorvariablerna i form av en teoretisk regressionslinje. Processen att hitta en teoretisk regressionslinje består av ett rimligt val av en approximativ kurva och beräkning av koefficienterna för dess ekvation. Regressionslinjen är en jämn kurva (i ett särskilt fall, en rät linje) som beskriver, med hjälp av en matematisk funktion, den allmänna trenden för beroendet som studeras och jämnar ut oregelbundna, slumpmässiga extremvärden från påverkan av sidofaktorer.

För att visa parade regressionsberoenden i bedömningsuppgifter används oftast följande funktioner: linjär - y - a 0 + ars + s kraft - y - aj&i + c demonstrativt - y - linjär exponentiell - y - a 0 + ar * + s. Här - e approximationsfel på grund av verkan av slumpmässiga faktorer som inte har redovisats.

I dessa funktioner är y den resulterande variabeln; x - faktorvariabel (faktor); men 0 , a r a 2 - regressionsmodellparametrar, regressionskoefficienter.

Den linjära exponentialmodellen tillhör klassen av så kallade hybridmodeller av formen:

var

där x (i = 1, /) - värden på faktorer;

b t (i = 0, /) är koefficienterna för regressionsekvationen.

I denna ekvation, komponenterna A, B Och Z motsvarar kostnaden för enskilda komponenter i tillgången som värderas, till exempel kostnaden för en tomt och kostnaden för förbättringar, och parametern F det är vanligt. Den är utformad för att justera värdet av alla komponenter i tillgången som värderas för en gemensam påverkansfaktor, såsom plats.

Värdena på faktorer som är i graden av motsvarande koefficienter är binära variabler (0 eller 1). De faktorer som ligger till grund för examen är diskreta eller kontinuerliga variabler.

Faktorer associerade med muär också kontinuerliga eller diskreta.

Specifikationen utförs som regel med hjälp av ett empiriskt tillvägagångssätt och inkluderar två steg:

- ? plotta punkter för regressionsfältet på grafen;

- ? grafisk (visuell) analys av typen av en möjlig approximerande kurva.

Typen av regressionskurva är inte alltid omedelbart valbar. För att bestämma det, plottas regressionsfältets punkter först på grafen enligt initialdata. Sedan ritas en linje visuellt längs punkternas position, för att försöka ta reda på det kvalitativa mönstret för anslutningen: enhetlig tillväxt eller enhetlig minskning, tillväxt (minskning) med en ökning (minskning) av dynamikens hastighet, ett smidigt tillvägagångssätt till en viss nivå.

Detta empiriska tillvägagångssätt kompletteras med logisk analys, med utgångspunkt från redan kända idéer om den ekonomiska och fysiska karaktären hos de faktorer som studeras och deras ömsesidiga inflytande.

Till exempel är det känt att beroenden av de resulterande variablerna - ekonomiska indikatorer (priser, hyra) på ett antal faktorvariabler - prisbildande faktorer (avstånd från bebyggelsens centrum, område etc.) är icke-linjära , och de kan beskrivas ganska strikt med en potens, exponentiell eller kvadratisk funktion. Men med små intervall av faktorer kan acceptabla resultat också erhållas med en linjär funktion.

Om det fortfarande är omöjligt att omedelbart göra ett säkert val av en funktion, väljs två eller tre funktioner, deras parametrar beräknas, och sedan, med hjälp av lämpliga kriterier för anslutningens täthet, väljs slutligen funktionen.

I teorin kallas regressionsprocessen för att hitta formen på en kurva Specifikation modell och dess koefficienter - kalibrering modeller.

Om det visar sig att den resulterande variabeln y beror på flera faktorvariabler (faktorer) x ( , x 2 , ..., x k, sedan tillgriper de att bygga en multipel regressionsmodell. Vanligtvis används tre former av multipel kommunikation: linjär - y - a 0 + a x x x + a^x 2+ ... + a k x k, demonstrativt - y - a 0 a*i a x t- a x b, kraft - y - a 0 x x ix 2 a 2. .x^ eller kombinationer därav.

De exponentiella och exponentiella funktionerna är mer universella, eftersom de approximerar icke-linjära samband, som är majoriteten av de beroenden som studeras i bedömningen. Dessutom kan de användas vid utvärdering av objekt och i metoden för statistisk modellering för massutvärdering, och i metoden för direkt jämförelse vid individuell utvärdering vid fastställande av korrektionsfaktorer.

På kalibreringsstadiet beräknas parametrarna för regressionsmodellen med minsta kvadratmetoden, vars kärna är att summan av de kvadrerade avvikelserna för de beräknade värdena för den resulterande variabeln på., dvs. beräknat enligt den valda relationsekvationen, från de faktiska värdena ska vara minimala:

Värden j) (. och y. känd alltså Fär en funktion av endast ekvationens koefficienter. För att hitta minimum S ta partiella derivator F med ekvationens koefficienter och likställ dem med noll:

Som ett resultat får vi ett system med normala ekvationer, vars antal är lika med antalet bestämda koefficienter för den önskade regressionsekvationen.

Antag att vi behöver hitta koefficienterna för den linjära ekvationen y - a 0 + ars. Summan av kvadrerade avvikelser är:

/=1

Differentiera en funktion F med okända koefficienter en 0 och och likställa de partiella derivatorna till noll:

Efter transformationer får vi:

var P - antal ursprungliga faktiska värden på dem (antalet analoger).

Ovanstående procedur för att beräkna koefficienterna för regressionsekvationen är också tillämplig för icke-linjära beroenden, om dessa beroenden kan linjäriseras, dvs. få till en linjär form med hjälp av en förändring av variabler. Potens- och exponentialfunktioner efter att ha tagit logaritm och motsvarande förändring av variabler får en linjär form. Till exempel har en potensfunktion efter att ha tagit en logaritm formen: I y \u003d 1n 0 +a x 1ph. Efter förändring av variabler Y- I y, L 0 - I och nr. X- I x får vi en linjär funktion

Y=A0 + cijX, vars koefficienter återfinns enligt beskrivningen ovan.

Minsta kvadratmetoden används också för att beräkna koefficienterna för en multipel regressionsmodell. Så, systemet med normala ekvationer för att beräkna en linjär funktion med två variabler Xj Och x 2 efter en serie transformationer ser det ut så här:

Vanligtvis löses detta ekvationssystem med linjära algebrametoder. En multipel exponentialfunktion bringas till en linjär form genom att ta logaritmer och ändra variabler på samma sätt som en parad exponentialfunktion.

När hybridmodeller används, hittas multipla regressionskoefficienter med användning av numeriska procedurer för metoden för successiva approximationer.

För att göra ett slutgiltigt val bland flera regressionsekvationer är det nödvändigt att testa varje ekvation för förhållandets täthet, vilket mäts av korrelationskoefficienten, variansen och variationskoefficienten. För utvärdering kan du också använda kriterierna Student och Fisher. Ju större anslutningen är tätare avslöjar kurvan, desto mer föredraget är det, allt annat lika.

Om ett problem av en sådan klass håller på att lösas, när det är nödvändigt att fastställa beroendet av en kostnadsindikator på kostnadsfaktorer, är önskan att ta hänsyn till så många påverkande faktorer som möjligt och därigenom bygga en mer exakt multipel regressionsmodell. begriplig. Två objektiva begränsningar hindrar dock ökningen av antalet faktorer. För det första kräver att bygga en multipel regressionsmodell ett mycket större urval av objekt än att bygga en parad modell. Det är allmänt accepterat att antalet objekt i urvalet bör överstiga antalet P faktorer, minst 5-10 gånger. Av detta följer att för att bygga en modell med tre påverkande faktorer är det nödvändigt att samla ett urval av cirka 20 objekt med olika uppsättningar av faktorvärden. För det andra bör de faktorer som väljs för modellen i deras inverkan på värdeindikatorn vara tillräckligt oberoende av varandra. Detta är inte lätt att säkerställa, eftersom provet vanligtvis kombinerar objekt som tillhör samma familj, där det sker en regelbunden förändring av många faktorer från objekt till objekt.

Kvaliteten på regressionsmodeller testas vanligtvis med hjälp av följande statistik.

Standardavvikelse för regressionsekvationens fel (uppskattningsfel):

var P - provstorlek (antal analoger);

till - antal faktorer (kostnadsfaktorer);

Fel som inte förklaras av regressionsekvationen (Fig. 3.2);

y. - det faktiska värdet av den resulterande variabeln (till exempel kostnad); y t - beräknat värde för den resulterande variabeln.

Denna indikator kallas också standardfel för uppskattning (RMS-fel). I figuren indikerar prickarna specifika värden för provet, symbolen indikerar linjen för medelvärdena för provet, den lutande streckade linjen är regressionslinjen.

Ris. 3.2.

Standardavvikelsen för uppskattningsfelet mäter mängden avvikelse för de faktiska värdena för y från motsvarande beräknade värden. på( , erhållen med hjälp av regressionsmodellen. Om urvalet som modellen bygger på är föremål för normalfördelningslagen, så kan man hävda att 68 % av de verkliga värdena på finns i sortimentet på ± &e från regressionslinjen och 95% - i intervallet på ± 2d e. Denna indikator är bekväm eftersom måttenheterna sg? matcha måttenheterna på,. I detta avseende kan den användas för att indikera noggrannheten hos resultatet som erhållits i utvärderingsprocessen. Till exempel, i ett värdecertifikat, kan du ange att värdet av marknadsvärdet erhålls med hjälp av regressionsmodellen V med en sannolikhet på 95% ligger i intervallet från (V-2d,.) innan (på + 2ds).

Variationskoefficient för den resulterande variabeln:

var y - medelvärdet för den resulterande variabeln (Figur 3.2).

I regressionsanalys är variationskoefficienten var standardavvikelsen för resultatet, uttryckt i procent av medelvärdet av resultatvariabeln. Variationskoefficienten kan fungera som ett kriterium för de prediktiva egenskaperna hos den resulterande regressionsmodellen: ju mindre värde var, desto högre är modellens prediktiva egenskaper. Användningen av variationskoefficienten är att föredra framför exponenten &e, eftersom det är en relativ exponent. I den praktiska användningen av denna indikator kan det rekommenderas att inte använda en modell vars variationskoefficient överstiger 33%, eftersom det i detta fall inte kan sägas att dessa prover omfattas av normalfördelningslagen.

Bestämningskoefficient (multipelkorrelationskoefficient i kvadrat):

Denna indikator används för att analysera den övergripande kvaliteten på den resulterande regressionsmodellen. Den anger hur stor andel av variationen i den resulterande variabeln som beror på påverkan av alla faktorvariabler som ingår i modellen. Bestämningskoefficienten ligger alltid i intervallet från noll till ett. Ju närmare värdet av bestämningskoefficienten enhet, desto bättre beskriver modellen den ursprungliga dataserien. Bestämningskoefficienten kan representeras på ett annat sätt:

Här är felet som förklaras av regressionsmodellen,

![]() men

men ![]() - fel oförklarat

- fel oförklarat

regressionsmodell. Ur ekonomisk synvinkel gör detta kriterium det möjligt att bedöma hur stor andel av prisvariationen som förklaras av regressionsekvationen.

Den exakta acceptansgränsen för indikatorn R2 det är omöjligt att specificera för alla fall. Både urvalsstorleken och den meningsfulla tolkningen av ekvationen måste beaktas. Som regel, när man studerar data om föremål av samma typ, erhållna vid ungefär samma tidpunkt, värdet R2 inte överstiger nivån 0,6-0,7. Om alla prediktionsfel är noll, dvs. när förhållandet mellan de resulterande variablerna och faktorvariablerna är funktionellt, då R2 =1.

Justerad bestämningskoefficient:

Behovet av att införa en justerad bestämningskoefficient förklaras av det faktum att med en ökning av antalet faktorer till den vanliga bestämningskoefficienten ökar nästan alltid, men antalet frihetsgrader minskar (n - k- ett). Den inmatade justeringen minskar alltid värdet R2, i den mån som (P - 1) > (p- till - ett). Som ett resultat, värdet R 2 CKOf) kan till och med bli negativ. Detta innebär att värdet R2 var nära noll före justering och andelen varians förklaras av variabelns regressionsekvation på väldigt liten.

Av de två versioner av regressionsmodeller som skiljer sig åt i värdet på den justerade bestämningskoefficienten, men som har lika bra andra kvalitetskriterier, är varianten med ett stort värde på den justerade bestämningskoefficienten att föredra. Bestämningskoefficienten justeras inte om (n - k): k> 20.

Fisher ratio:

Detta kriterium används för att bedöma betydelsen av bestämningskoefficienten. Restsumma av kvadrater ![]() är ett mått på prediktionsfel som använder en regression av kända kostnadsvärden på.. Dess jämförelse med regressionssumman av kvadrater visar hur många gånger regressionsberoendet förutsäger resultatet bättre än medelvärdet på. Det finns en tabell med kritiska värden F R Fisher-koefficient beroende på antalet frihetsgrader för täljaren - till, nämnare v 2 = p - k- 1 och signifikansnivå a. Om det beräknade värdet av Fisher-kriteriet F Rär större än tabellvärdet, då hypotesen om bestämningskoefficientens obetydlighet, dvs. om diskrepansen mellan relationerna inbäddade i regressionsekvationen och de verkligt existerande, med en sannolikhet p = 1 - a förkastas.

är ett mått på prediktionsfel som använder en regression av kända kostnadsvärden på.. Dess jämförelse med regressionssumman av kvadrater visar hur många gånger regressionsberoendet förutsäger resultatet bättre än medelvärdet på. Det finns en tabell med kritiska värden F R Fisher-koefficient beroende på antalet frihetsgrader för täljaren - till, nämnare v 2 = p - k- 1 och signifikansnivå a. Om det beräknade värdet av Fisher-kriteriet F Rär större än tabellvärdet, då hypotesen om bestämningskoefficientens obetydlighet, dvs. om diskrepansen mellan relationerna inbäddade i regressionsekvationen och de verkligt existerande, med en sannolikhet p = 1 - a förkastas.

Genomsnittligt uppskattningsfel(genomsnittlig procentuell avvikelse) beräknas som den genomsnittliga relativa skillnaden, uttryckt i procent, mellan de faktiska och beräknade värdena för den resulterande variabeln:

Ju lägre värde denna indikator har, desto bättre är modellens prediktiva kvalitet. När värdet på denna indikator inte är högre än 7% indikerar de modellens höga noggrannhet. Om 8 > 15 %, anger modellens otillfredsställande noggrannhet.

Standardfel för regressionskoefficienten:

där (/I) -1 .- diagonalt element i matrisen (X G X) ~ 1 till - antal faktorer;

X- matris av faktorvariabler värden:

X7- transponerad matris av faktorvariabler värden;

(JL) _| är en matris invers till en matris.

Ju mindre dessa poäng för varje regressionskoefficient, desto mer tillförlitlig är uppskattningen av motsvarande regressionskoefficient.

Elevens prov (t-statistik):

Detta kriterium låter dig mäta graden av tillförlitlighet (signifikans) av sambandet på grund av en given regressionskoefficient. Om det beräknade värdet t. större än tabellvärdet

t av , var v - p - k - 1 är antalet frihetsgrader, då förkastas hypotesen att denna koefficient är statistiskt insignifikant med en sannolikhet på (100 - a)%. Det finns speciella tabeller över /-fördelningen som gör det möjligt att bestämma det kritiska värdet av kriteriet genom en given signifikansnivå a och antalet frihetsgrader v. Det vanligaste värdet på a är 5 %.

Multikollinearitet, dvs. effekten av ömsesidiga samband mellan faktorvariabler leder till att man måste nöja sig med ett begränsat antal av dem. Om man inte tar hänsyn till detta kan man sluta med en ologisk regressionsmodell. För att undvika den negativa effekten av multikollinearitet, innan man bygger en multipel regressionsmodell, beräknas parkorrelationskoefficienter rxjxj mellan valda variabler X. Och X

Här XjX; - medelvärdet av produkten av två faktorvariabler;

XjXj- produkten av medelvärdena för två faktorvariabler;

Utvärdering av variansen för faktorvariabeln x..

Två variabler anses vara regressivt relaterade (d.v.s. kolinjära) om deras parvisa korrelationskoefficient är strikt större än 0,8 i absolut värde. I detta fall bör någon av dessa variabler uteslutas från övervägande.

För att utöka möjligheterna till ekonomisk analys av de resulterande regressionsmodellerna används medelvärden elasticitetskoefficienter, bestäms av formeln:

var Xj- medelvärdet för motsvarande faktorvariabel;

y - medelvärdet av den resulterande variabeln; ett jag - regressionskoefficient för motsvarande faktorvariabel.

Elasticitetskoefficienten visar hur många procent värdet på den resulterande variabeln kommer att förändras i genomsnitt när faktorvariabeln ändras med 1 %, d.v.s. hur den resulterande variabeln reagerar på en förändring i faktorvariabeln. Till exempel, hur fungerar priset på kvm. m område av lägenheten på avstånd från centrum.

Användbar ur synvinkeln för att analysera betydelsen av en viss regressionskoefficient är skattningen privat bestämningskoefficient:

Här är uppskattningen av variansen för resultatet

variabel. Denna koefficient visar hur många procent variationen av den resulterande variabeln förklaras av variationen av den /-te faktorvariabeln som ingår i regressionsekvationen.

- Hedoniska egenskaper förstås som egenskaperna hos ett objekt som återspeglar dess användbara (värdefulla) egenskaper ur köpares och säljares synvinkel.

Under sina studier möter studenter mycket ofta en mängd olika ekvationer. En av dem - regressionsekvationen - behandlas i den här artikeln. Denna typ av ekvation används specifikt för att beskriva egenskaperna hos förhållandet mellan matematiska parametrar. Denna typ av jämställdhet används inom statistik och ekonometri.

Definition av regression

I matematik förstås regression som en viss kvantitet som beskriver beroendet av medelvärdet för en datamängd på värdena för en annan kvantitet. Regressionsekvationen visar, som en funktion av en viss egenskap, medelvärdet för en annan egenskap. Regressionsfunktionen har formen av en enkel ekvation y \u003d x, där y fungerar som en beroende variabel och x är en oberoende variabel (funktionsfaktor). Faktum är att regressionen uttrycks som y = f (x).

Vilka typer av samband finns det mellan variabler

Generellt särskiljs två motsatta typer av samband: korrelation och regression.

Den första kännetecknas av likhet mellan betingade variabler. I det här fallet är det inte säkert känt vilken variabel som beror på den andra.

Om det inte finns någon likhet mellan variablerna och villkoren säger vilken variabel som är förklarande och vilken som är beroende, så kan vi prata om förekomsten av ett samband av den andra typen. För att bygga en linjär regressionsekvation kommer det att vara nödvändigt att ta reda på vilken typ av samband som observeras.

Typer av regressioner

Hittills finns det 7 olika typer av regression: hyperbolisk, linjär, multipel, olinjär, parvis, invers, logaritmiskt linjär.

Hyperbolisk, linjär och logaritmisk

Den linjära regressionsekvationen används i statistik för att tydligt förklara ekvationens parametrar. Det ser ut som y = c + m * x + E. Den hyperboliska ekvationen har formen av en vanlig hyperbel y \u003d c + m / x + E. Den logaritmiskt linjära ekvationen uttrycker förhållandet med den logaritmiska funktionen: In y \u003d In c + m * In x + In E.

Multipel och icke-linjär

Två mer komplexa typer av regression är multipel och icke-linjär. Den multipla regressionsekvationen uttrycks av funktionen y \u003d f (x 1, x 2 ... x c) + E. I denna situation är y den beroende variabeln och x är den förklarande variabeln. Variabeln E är stokastisk och inkluderar påverkan av andra faktorer i ekvationen. Den icke-linjära regressionsekvationen är lite inkonsekvent. Å ena sidan, med avseende på de indikatorer som beaktas, är den inte linjär, och å andra sidan är den linjär i rollen att bedöma indikatorer.

Inversa och parvisa regressioner

En invers är en sorts funktion som måste omvandlas till en linjär form. I de mest traditionella applikationsprogrammen har den formen av en funktion y \u003d 1 / c + m * x + E. Den parade regressionsekvationen visar sambandet mellan data som en funktion av y = f(x) + E. Precis som de andra ekvationerna beror y på x och E är en stokastisk parameter.

Begreppet korrelation

Detta är en indikator som visar att det finns ett samband mellan två fenomen eller processer. Styrkan i sambandet uttrycks som en korrelationskoefficient. Dess värde fluktuerar inom intervallet [-1;+1]. En negativ indikator indikerar närvaron av återkoppling, en positiv indikator indikerar en direkt. Om koefficienten tar ett värde lika med 0, så finns det inget samband. Ju närmare värdet är 1 - desto starkare förhållandet mellan parametrarna, desto närmare 0 - desto svagare.

Metoder

Korrelationsparametriska metoder kan uppskatta förhållandets täthet. De används på basis av fördelningsuppskattningar för att studera parametrar som följer normalfördelningslagen.

Parametrarna för den linjära regressionsekvationen är nödvändiga för att identifiera typen av beroende, funktionen av regressionsekvationen och utvärdera indikatorerna för den valda relationsformeln. Korrelationsfältet används som en metod för att identifiera ett samband. För att göra detta måste alla befintliga data representeras grafiskt. I ett rektangulärt tvådimensionellt koordinatsystem måste alla kända data plottas. Så här bildas korrelationsfältet. Värdet på den beskrivande faktorn markeras längs abskissan, medan värdena på den beroende faktorn är markerade längs ordinatan. Om det finns ett funktionellt samband mellan parametrarna radas de upp i form av en linje.

Om korrelationskoefficienten för sådana data är mindre än 30% kan vi prata om den nästan fullständiga frånvaron av en anslutning. Om det är mellan 30% och 70%, indikerar detta närvaron av länkar med medelhög täthet. En 100 %-indikator är ett bevis på en funktionell anslutning.

En icke-linjär regressionsekvation, precis som en linjär, måste kompletteras med ett korrelationsindex (R).

Korrelation för multipel regression

Bestämningskoefficienten är en indikator på kvadraten av multipelkorrelationen. Han talar om tätheten i förhållandet mellan den presenterade uppsättningen indikatorer och egenskapen som studeras. Det kan också tala om arten av påverkan av parametrar på resultatet. Den multipla regressionsekvationen utvärderas med denna indikator.

För att beräkna multipelkorrelationsindexet är det nödvändigt att beräkna dess index.

Minsta kvadratiska metod

Denna metod är ett sätt att uppskatta regressionsfaktorer. Dess essens ligger i att minimera summan av kvadrerade avvikelser som erhålls på grund av faktorns beroende av funktionen.

En parad linjär regressionsekvation kan uppskattas med en sådan metod. Denna typ av ekvationer används vid detektering mellan indikatorerna för ett parat linjärt samband.

Ekvationsalternativ

Varje parameter i den linjära regressionsfunktionen har en specifik betydelse. Den parade linjära regressionsekvationen innehåller två parametrar: c och m. Parametern t visar den genomsnittliga förändringen i den slutliga indikatorn för funktionen y, med förbehåll för en minskning (ökning) av variabeln x med en konventionell enhet. Om variabeln x är noll är funktionen lika med parametern c. Om variabeln x inte är noll, är faktorn c inte ekonomiskt vettig. Den enda inverkan på funktionen är tecknet framför faktorn c. Om det finns ett minus kan vi säga om en långsam förändring i resultatet jämfört med faktorn. Om det finns ett plus, indikerar detta en accelererad förändring i resultatet.

Varje parameter som ändrar värdet på regressionsekvationen kan uttryckas i termer av en ekvation. Till exempel har faktorn c formen c = y - mx.

Grupperade data

Det finns sådana villkor för uppgiften där all information är grupperad enligt attributet x, men samtidigt, för en viss grupp, anges motsvarande medelvärden för den beroende indikatorn. I det här fallet kännetecknar medelvärdena hur indikatorn beror på x. Den grupperade informationen hjälper alltså till att hitta regressionsekvationen. Det används som en relationsanalys. Denna metod har dock sina nackdelar. Tyvärr är genomsnitt ofta föremål för externa fluktuationer. Dessa fluktuationer är inte en återspegling av relationens mönster, de maskerar bara dess "brus". Genomsnitt visar relationsmönster mycket värre än en linjär regressionsekvation. De kan dock användas som underlag för att hitta en ekvation. Genom att multiplicera storleken på en viss population med motsvarande medelvärde kan du få summan av y inom gruppen. Därefter måste du slå ut alla mottagna belopp och hitta den slutliga indikatorn y. Det är lite svårare att göra beräkningar med summaindikatorn xy. I händelse av att intervallen är små kan vi villkorligt ta indikatorn x för alla enheter (inom gruppen) lika. Multiplicera det med summan av y för att hitta summan av produkterna av x och y. Vidare slås alla summor ihop och den totala summan xy erhålls.

Ekvationsregression med flera par: Att bedöma betydelsen av ett förhållande

Som diskuterats tidigare har multipel regression en funktion av formen y \u003d f (x 1, x 2, ..., x m) + E. Oftast används en sådan ekvation för att lösa problemet med tillgång och efterfrågan på varor, ränteintäkter på återköpta aktier, studera orsakerna och typen av produktionskostnadsfunktion. Den används också aktivt i en mängd olika makroekonomiska studier och beräkningar, men på mikroekonominivå används denna ekvation lite mer sällan.

Huvuduppgiften för multipel regression är att bygga en datamodell som innehåller en enorm mängd information för att ytterligare bestämma vilken effekt var och en av faktorerna har individuellt och i sin helhet på indikatorn som ska modelleras och dess koefficienter. Regressionsekvationen kan anta en mängd olika värden. I det här fallet används vanligtvis två typer av funktioner för att bedöma sambandet: linjär och olinjär.

En linjär funktion avbildas i form av ett sådant förhållande: y \u003d a 0 + a 1 x 1 + a 2 x 2, + ... + a m x m. I detta fall anses a2, a m vara koefficienterna för "ren" regression. De är nödvändiga för att karakterisera den genomsnittliga förändringen i parametern y med en förändring (minskning eller ökning) i varje motsvarande parameter x med en enhet, med villkoret för ett stabilt värde för andra indikatorer.

Icke-linjära ekvationer har till exempel formen av en potensfunktion y=ax 1 b1 x 2 b2 ...x m bm . I det här fallet kallas indikatorerna b 1, b 2 ..... bm - elasticitetskoefficienter, de visar hur resultatet kommer att förändras (med hur mycket%) med en ökning (minskning) av motsvarande indikator x med 1% och med en stabil indikator på andra faktorer.

Vilka faktorer bör beaktas när man bygger en multipel regression

För att korrekt konstruera en multipel regression är det nödvändigt att ta reda på vilka faktorer som bör ägnas särskild uppmärksamhet.

Det är nödvändigt att ha en viss förståelse för karaktären av sambandet mellan ekonomiska faktorer och det modellerade. Faktorerna som ska inkluderas måste uppfylla följande kriterier:

- Måste vara mätbart. För att använda en faktor som beskriver kvaliteten på ett objekt bör det i alla fall ges en kvantitativ form.

- Det ska inte finnas någon faktorinterkorrelation eller funktionell relation. Sådana handlingar leder oftast till oåterkalleliga konsekvenser - systemet med vanliga ekvationer blir obetingat, och detta medför dess opålitlighet och luddiga uppskattningar.

- I fallet med en enorm korrelationsindikator finns det inget sätt att ta reda på den isolerade påverkan av faktorer på det slutliga resultatet av indikatorn, därför blir koefficienterna otolkbara.

Konstruktionsmetoder

Det finns ett stort antal metoder och sätt att förklara hur du kan välja faktorerna för ekvationen. Alla dessa metoder är dock baserade på valet av koefficienter med hjälp av korrelationsindex. Bland dem finns:

- Uteslutningsmetod.

- Slå på metoden.

- Stegvis regressionsanalys.

Den första metoden går ut på att sålla bort alla koefficienter från den aggregerade uppsättningen. Den andra metoden innebär införandet av många ytterligare faktorer. Tja, den tredje är elimineringen av faktorer som tidigare tillämpades på ekvationen. Var och en av dessa metoder har rätt att existera. De har sina för- och nackdelar, men de kan alla på sitt sätt lösa frågan om att sålla bort onödiga indikatorer. Som regel är resultaten som erhålls med varje enskild metod ganska nära.

Metoder för multivariat analys

Sådana metoder för att bestämma faktorer är baserade på övervägande av individuella kombinationer av inbördes relaterade egenskaper. Dessa inkluderar diskriminantanalys, mönsterigenkänning, huvudkomponentanalys och klusteranalys. Dessutom finns det också faktoranalys, men den dök upp som ett resultat av utvecklingen av komponentmetoden. Alla gäller under vissa omständigheter, under vissa förutsättningar och faktorer.

Modern statsvetenskap utgår från positionen för förhållandet mellan alla fenomen och processer i samhället. Det är omöjligt att förstå händelser och processer, förutsäga och hantera det politiska livets fenomen utan att studera de samband och beroenden som finns i samhällets politiska sfär. En av policyforskningens vanligaste uppgifter är att studera sambandet mellan några observerbara variabler. En hel klass av statistiska analysmetoder, förenade med det vanliga namnet "regressionsanalys" (eller, som det också kallas, "korrelations-regressionsanalys"), hjälper till att lösa detta problem. Men om korrelationsanalys gör det möjligt att bedöma styrkan i sambandet mellan två variabler, är det med hjälp av regressionsanalys möjligt att bestämma typen av detta samband, för att förutsäga beroendet av värdet av en variabel på värdet av en annan variabel .

Låt oss först komma ihåg vad en korrelation är. Korrelativ kallas det viktigaste specialfallet av statistiskt samband, som består i det faktum att lika värden på en variabel motsvarar olika medelvärden annan. Med en förändring av värdet på attributet x ändras naturligt medelvärdet av attributet y, medan värdet på attributet i varje enskilt fall på(med olika sannolikheter) kan anta många olika värden.

Utseendet på termen "korrelation" i statistik (och statsvetenskap lockar till att uppnå statistik för att lösa sina problem, som därför är en disciplin relaterad till statsvetenskap) är associerad med namnet på den engelske biologen och statistikern Francis Galton, som friade på 1800-talet. teoretiska grunder för korrelations-regressionsanalys. Termen "korrelation" inom vetenskapen var känd tidigare. I synnerhet inom paleontologin på 1700-talet. den tillämpades av den franske vetenskapsmannen Georges Cuvier. Han införde den så kallade korrelationslagen, med hjälp av vilken det, enligt resterna av djur som hittats vid utgrävningar, var möjligt att återställa deras utseende.

Det finns en välkänd historia förknippad med namnet på denna vetenskapsman och hans lag om korrelation. Så, på dagarna av en universitetssemester, drog studenter som bestämde sig för att spela en berömd professor ett spratt ett getskinn med horn och hovar över en student. Han klättrade in i fönstret till Cuviers sovrum och ropade: "Jag äter dig." Professorn vaknade, tittade på siluetten och svarade: ”Om du har horn och hovar, då är du en växtätare och kan inte äta mig. Och för okunnighet om korrelationslagen får du en tvåa. Han vände sig om och somnade. Ett skämt är ett skämt, men i det här exemplet ser vi ett specialfall av att använda multipel korrelations-regressionsanalys. Här härledde professorn, baserat på kunskapen om värdena för de två observerade egenskaperna (närvaron av horn och hovar), baserat på korrelationslagen, medelvärdet för den tredje egenskapen (klassen som detta djur tillhör är en växtätare). I det här fallet talar vi inte om det specifika värdet av denna variabel (dvs detta djur kan anta olika värden på en nominell skala - det kan vara en get, en bagge eller en tjur ...).

Låt oss nu gå vidare till termen "regression". Strängt taget hänger det inte ihop med innebörden av de statistiska problem som löses med hjälp av denna metod. En förklaring av begreppet kan endast ges på grundval av kunskap om historien om utvecklingen av metoder för att studera sambanden mellan egenskaper. Ett av de första exemplen på studier av detta slag var statistikerna F. Galton och K. Pearsons arbete, som försökte hitta ett mönster mellan fäders och deras barns tillväxt enligt två observerbara tecken (där X- fars längd och U- barns tillväxt). I sin studie bekräftade de den initiala hypotesen att långa fäder i genomsnitt uppfostrar medellånga barn. Samma princip gäller låga fäder och barn. Men om forskarna hade stannat där, skulle deras verk aldrig ha nämnts i läroböcker om statistik. Forskarna hittade ett annat mönster inom den redan nämnda bekräftade hypotesen. De visade att mycket långa fäder producerar barn som är långa i genomsnitt, men som inte skiljer sig särskilt mycket från barn vars fäder, även om de är över genomsnittet, inte skiljer sig särskilt mycket från medellängden. Detsamma gäller för fäder med mycket liten statur (som avviker från genomsnittet för den korta gruppen) - deras barn skilde sig i genomsnitt inte i längd från jämnåriga vars fäder helt enkelt var korta. De kallade funktionen som beskriver denna regelbundenhet regressionsfunktion. Efter denna studie började alla ekvationer som beskriver liknande funktioner och konstruerade på liknande sätt att kallas regressionsekvationer.

Regressionsanalys är en av metoderna för multivariat statistisk dataanalys, som kombinerar en uppsättning statistiska tekniker utformade för att studera eller modellera samband mellan en beroende och flera (eller en) oberoende variabler. Den beroende variabeln, enligt traditionen accepterad i statistiken, kallas respons och betecknas som V De oberoende variablerna kallas prediktorer och betecknas som x. Under analysens gång kommer vissa variabler att vara svagt relaterade till svaret och kommer så småningom att uteslutas från analysen. De återstående variablerna förknippade med den beroende kan också kallas faktorer.

Regressionsanalys gör det möjligt att förutsäga värdena för en eller flera variabler beroende på en annan variabel (till exempel benägenheten för okonventionellt politiskt beteende beroende på utbildningsnivå) eller flera variabler. Det beräknas på PC. För att sammanställa en regressionsekvation som låter dig mäta graden av beroende av den kontrollerade funktionen på faktorn, är det nödvändigt att involvera professionella matematiker-programmerare. Regressionsanalys kan ge en ovärderlig tjänst för att bygga prediktiva modeller för utvecklingen av en politisk situation, bedöma orsakerna till sociala spänningar och genomföra teoretiska experiment. Regressionsanalys används aktivt för att studera inverkan på medborgarnas valbeteende av ett antal sociodemografiska parametrar: kön, ålder, yrke, bostadsort, nationalitet, nivå och typ av inkomst.

I relation till regressionsanalys, begreppen oberoende Och beroende variabler. En oberoende variabel är en variabel som förklarar eller orsakar en förändring i en annan variabel. En beroende variabel är en variabel vars värde förklaras av den första variabelns inflytande. Till exempel i presidentvalet 2004 var de avgörande faktorerna, dvs. oberoende variabler var indikatorer som stabilisering av den ekonomiska situationen för befolkningen i landet, graden av popularitet för kandidater och faktorn tjänstgöring. I det här fallet kan andelen avgivna röster för kandidater betraktas som en beroende variabel. På liknande sätt, i paret av variabler "väljarens ålder" och "nivå av valaktivitet", är den första oberoende, den andra är beroende.

Regressionsanalys låter dig lösa följande problem:

- 1) fastställa själva faktumet av närvaron eller frånvaron av ett statistiskt signifikant samband mellan Ci x;

- 2) bygga de bästa (i statistisk mening) uppskattningarna av regressionsfunktionen;

- 3) enligt de givna värdena X skapa en förutsägelse för det okända På

- 4) utvärdera den specifika vikten av påverkan av varje faktor X på På och följaktligen utesluta obetydliga egenskaper från modellen;

- 5) genom att identifiera orsakssamband mellan variabler, delvis hantera värdena för P genom att justera värdena för förklarande variabler x.

Regressionsanalys är förknippat med behovet av att välja ömsesidigt oberoende variabler som påverkar värdet på den indikator som studeras, bestämma formen på regressionsekvationen och utvärdera parametrar med hjälp av statistiska metoder för bearbetning av primär sociologisk data. Denna typ av analys är baserad på idén om förhållandets form, riktning och närhet (densitet). Skilja på ångbastu Och multipel regression beroende på antalet studerade funktioner. I praktiken utförs regressionsanalys vanligtvis i samband med korrelationsanalys. Regressions ekvation beskriver ett numeriskt samband mellan kvantiteter, uttryckt som en tendens för en variabel att öka eller minska medan en annan ökar eller minskar. Samtidigt, razl och h a yut l glasera Och icke-linjär regression. Vid beskrivning av politiska processer återfinns båda varianterna av regression lika.

Scatterplot för fördelning av ömsesidigt beroende av intressen i politiska artiklar ( U) och utbildning av respondenterna (X)är en linjär regression (fig. 30).

Ris. trettio.

Scatterplot för fördelning av nivån på valaktivitet ( U) och respondentens ålder (A) (villkorligt exempel) är en icke-linjär regression (Fig. 31).

Ris. 31.

För att beskriva förhållandet mellan två egenskaper (A "och Y) i en parad regressionsmodell används en linjär ekvation

![]()

där a, är ett slumpmässigt värde på felet i ekvationen med variation av egenskaper, dvs. ekvationens avvikelse från "linjäritet".

För att utvärdera koefficienterna men Och b använd minsta kvadratmetoden, som förutsätter att summan av de kvadrerade avvikelserna för varje punkt på spridningsdiagrammet från regressionslinjen ska vara minimal. Odds a h b kan beräknas med hjälp av ekvationssystemet:

Metoden för uppskattning av minsta kvadrater ger sådana uppskattningar av koefficienterna men Och b, för vilken linjen går genom punkten med koordinater X Och y, de där. det finns ett samband på = yxa + b. Den grafiska representationen av regressionsekvationen kallas teoretisk regressionslinje. Med ett linjärt beroende representerar regressionskoefficienten på grafen tangenten för lutningen av den teoretiska regressionslinjen till x-axeln. Tecknet vid koefficienten visar förhållandets riktning. Om det är större än noll är sambandet direkt, om det är mindre är det omvänt.

Följande exempel från studien "Politisk Petersburg-2006" (Tabell 56) visar ett linjärt samband mellan medborgarnas uppfattning om graden av tillfredsställelse med sina liv i nuet och förväntningar på förändringar i livskvaliteten i framtiden. Kopplingen är direkt, linjär (den standardiserade regressionskoefficienten är 0,233, signifikansnivån är 0,000). I det här fallet är regressionskoefficienten inte hög, men den överskrider den nedre gränsen för den statistiskt signifikanta indikatorn (den nedre gränsen för kvadraten av den statistiskt signifikanta indikatorn för Pearson-koefficienten).

Tabell 56

Inverkan av medborgarnas livskvalitet i nuet på förväntningarna

(S:t Petersburg, 2006)

* Beroende variabel: "Hur tror du att ditt liv kommer att förändras under de kommande 2-3 åren?"

I det politiska livet beror värdet av den studerade variabeln oftast samtidigt på flera egenskaper. Till exempel påverkas nivån och arten av politisk aktivitet samtidigt av statens politiska regim, politiska traditioner, särdragen hos människors politiska beteende i ett visst område och respondentens sociala mikrogrupp, hans ålder, utbildning, inkomst nivå, politisk inriktning m.m. I det här fallet måste du använda ekvationen multipel regression, som har följande form:

där koefficient b.- partiell regressionskoefficient. Den visar bidraget från varje oberoende variabel för att bestämma värdena för den oberoende (utfalls)variabeln. Om den partiella regressionskoefficienten är nära 0, kan vi dra slutsatsen att det inte finns något direkt samband mellan de oberoende och beroende variablerna.

Beräkningen av en sådan modell kan utföras på en PC med hjälp av matrisalgebra. Multipel regression låter dig återspegla den multifaktoriella karaktären hos sociala band och förtydliga måttet på effekten av varje faktor individuellt och tillsammans på den resulterande egenskapen.

Koefficient betecknad b, kallas linjär regressionskoefficient och visar styrkan i sambandet mellan variationen av faktorattributet X och variation av den effektiva funktionen Y Denna koefficient mäter styrkan av sambandet i absoluta måttenheter för egenskaper. Emellertid kan närheten av korrelationen av egenskaper också uttryckas i termer av standardavvikelsen för den resulterande egenskapen (en sådan koefficient kallas korrelationskoefficienten). Till skillnad från regressionskoefficienten b Korrelationskoefficienten beror inte på de accepterade måttenheterna för egenskaper, och därför är den jämförbar för alla egenskaper. Vanligtvis anses kopplingen vara stark om /> 0,7, medel täthet - vid 0,5 g 0,5.

Den närmaste anknytningen är som bekant en funktionell koppling, då varje enskild värde Y kan unikt tilldelas värdet x. Således, ju närmare korrelationskoefficienten är 1, desto närmare är relationen en funktionell. Signifikansnivån för regressionsanalys bör inte överstiga 0,001.

Korrelationskoefficienten har länge ansetts som huvudindikatorn på hur nära förhållandet mellan funktioner är. Men senare blev bestämningskoefficienten en sådan indikator. Innebörden av denna koefficient är som följer - den återspeglar andelen av den totala variansen av den resulterande egenskapen På, förklaras av funktionens varians x. Den hittas genom att helt enkelt kvadrera korrelationskoefficienten (som ändras från 0 till 1) och i sin tur, för ett linjärt samband reflekterar andelen från 0 (0%) till 1 (100 %) karakteristiska värden Y, bestäms av värdena för attributet x. Det är inspelat som jag 2, och i de resulterande tabellerna för regressionsanalys i SPSS-paketet - utan en kvadrat.

Låt oss beteckna huvudproblemen med att konstruera den multipla regressionsekvationen.

- 1. Val av faktorer som ingår i regressionsekvationen. I detta skede sammanställer forskaren först en allmän lista över de huvudsakliga orsakerna som enligt teorin orsakar fenomenet som studeras. Sedan måste han välja funktionerna i regressionsekvationen. Huvudurvalsregeln är att de faktorer som ingår i analysen ska korrelera så lite som möjligt med varandra; endast i detta fall är det möjligt att tillskriva ett visst faktorattribut ett kvantitativt mått på inflytande.

- 2. Välja formen för multipla regressionsekvationen(i praktiken används oftare linjär eller linjär-logaritmisk). Så för att använda multipel regression måste forskaren först bygga en hypotetisk modell av påverkan av flera oberoende variabler på den resulterande. För att de erhållna resultaten ska vara tillförlitliga är det nödvändigt att modellen exakt matchar den verkliga processen, d.v.s. relationen mellan variabler måste vara linjär, inte en enda signifikant oberoende variabel kan ignoreras, precis som inte en enda variabel som inte är direkt relaterad till den process som studeras kan inkluderas i analysen. Dessutom måste alla mätningar av variabler vara extremt exakta.

Från ovanstående beskrivning följer ett antal villkor för tillämpningen av denna metod, utan vilka det är omöjligt att gå vidare till proceduren för multipel regressionsanalys (MRA). Endast överensstämmelse med alla följande punkter gör att du kan utföra en regressionsanalys korrekt.

- I kontakt med 0

- Google Plus 0

- OK 0

- Facebook 0