Analiza regresji jest metodą ustalenia analitycznego wyrazu stochastycznego związku między badanymi cechami. Równanie regresji pokazuje, jak średnio się zmienia w przy zmianie któregokolwiek z x i , i wygląda tak:

gdzie y - zmienna zależna (zawsze jest jedna);

x i - zmienne niezależne (czynniki) (może być ich kilka).

Jeśli istnieje tylko jedna zmienna niezależna, jest to prosta analiza regresji. Jeśli jest ich kilka P  2),

wtedy taka analiza nazywana jest wielowymiarową.

2),

wtedy taka analiza nazywana jest wielowymiarową.

W trakcie analizy regresji rozwiązywane są dwa główne zadania:

konstrukcja równania regresji, tj. znalezienie rodzaju zależności pomiędzy wskaźnikiem rezultatu a czynnikami niezależnymi x 1 , x 2 , …, x n .

ocena istotności otrzymanego równania, tj. określenie na ile wybrane cechy czynnikowe wyjaśniają zmienność cechy tak.

Analiza regresji jest wykorzystywana głównie do planowania, a także do opracowywania ram regulacyjnych.

W przeciwieństwie do analizy korelacji, która odpowiada jedynie na pytanie, czy istnieje związek między analizowanymi cechami, analiza regresji daje również swój sformalizowany wyraz. Ponadto, jeśli analiza korelacji bada jakąkolwiek relację czynników, to analiza regresji bada zależność jednostronną, tj. połączenie pokazujące, jak zmiana znaków czynnika wpływa na znak wynikowy.

Analiza regresji jest jedną z najbardziej rozwiniętych metod statystyki matematycznej. Ściśle mówiąc, wdrożenie analizy regresji wymaga spełnienia szeregu specjalnych wymagań (w szczególności x ja ,x 2 ,...,x n ;tak muszą być niezależnymi zmiennymi losowymi o rozkładzie normalnym i stałymi wariancjami). W rzeczywistości ścisła zgodność z wymogami analizy regresji i korelacji jest bardzo rzadka, ale obie te metody są bardzo powszechne w badaniach ekonomicznych. Zależności w gospodarce mogą być nie tylko bezpośrednie, ale także odwrotne i nieliniowe. Model regresji można zbudować przy dowolnej zależności, jednak w analizie wielowymiarowej wykorzystuje się tylko modele liniowe postaci:

Konstrukcja równania regresji realizowana jest z reguły metodą najmniejszych kwadratów, której istotą jest minimalizacja sumy kwadratów odchyleń rzeczywistych wartości otrzymanego atrybutu od jego wartości obliczonych, tj.:

gdzie T - liczba obserwacji;

J

=a+b 1 x 1 J +b 2 x 2 J + ... + b n x n J

-

obliczona wartość współczynnika wyniku.

J

=a+b 1 x 1 J +b 2 x 2 J + ... + b n x n J

-

obliczona wartość współczynnika wyniku.

Zaleca się wyznaczanie współczynników regresji za pomocą pakietów analitycznych na komputer osobisty lub specjalnego kalkulatora finansowego. W najprostszym przypadku współczynniki regresji jednoczynnikowego równania regresji liniowej postaci y = a + bx można znaleźć za pomocą wzorów:

analiza skupień

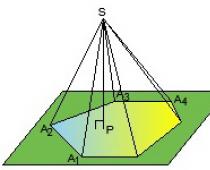

Analiza skupień jest jedną z metod analizy wielowymiarowej, przeznaczoną do grupowania (grupowania) populacji, której elementy charakteryzują się wieloma cechami. Wartości każdej z cech służą jako współrzędne każdej jednostki badanej populacji w wielowymiarowej przestrzeni cech. Każdą obserwację, charakteryzującą się wartościami kilku wskaźników, można przedstawić jako punkt w przestrzeni tych wskaźników, których wartości są traktowane jako współrzędne w przestrzeni wielowymiarowej. Odległość między punktami r I Q od k współrzędne definiuje się jako:

Głównym kryterium grupowania jest to, że różnice między skupieniami powinny być bardziej znaczące niż między obserwacjami przypisanymi do tego samego skupienia, tj. w przestrzeni wielowymiarowej należy zaobserwować nierówność:

gdzie r 1, 2 - odległość między klastrami 1 i 2.

Podobnie jak procedury analizy regresji, procedura klastrowania jest dość pracochłonna, zaleca się wykonanie jej na komputerze.

Główny cel analizy regresji polega na określeniu analitycznej postaci relacji, w której zmiana atrybutu wypadkowego jest spowodowana wpływem jednego lub więcej znaków czynnika, a zbiór wszystkich innych czynników, które również wpływają na atrybut wypadkowy, przyjmuje się jako wartości stałe i średnie .Zadania analizy regresji:

a) Ustalenie formy zależności. Ze względu na charakter i formę zależności między zjawiskami wyróżnia się dodatnią regresję liniową i nieliniową oraz ujemną regresję liniową i nieliniową.

b) Definicja funkcji regresji w postaci równania matematycznego dowolnego typu i ustalenie wpływu zmiennych objaśniających na zmienną zależną.

c) Estymacja nieznanych wartości zmiennej zależnej. Korzystając z funkcji regresji można odtworzyć wartości zmiennej zależnej w przedziale podanych wartości zmiennych objaśniających (tj. rozwiązać problem interpolacji) lub ocenić przebieg procesu poza podanym przedziałem (tj. rozwiązać problem ekstrapolacji). Wynikiem jest oszacowanie wartości zmiennej zależnej.

Regresja par - równanie relacji dwóch zmiennych y i x: y=f(x), gdzie y jest zmienną zależną (znak wynikowy); x - niezależna zmienna objaśniająca (cecha-czynnik).

Istnieją regresje liniowe i nieliniowe.

Regresja liniowa: y = a + bx + ε

Regresje nieliniowe dzielą się na dwie klasy: regresje nieliniowe ze względu na zmienne objaśniające uwzględnione w analizie, ale liniowe ze względu na szacowane parametry oraz regresje nieliniowe ze względu na szacowane parametry.

Regresje nieliniowe w zmiennych objaśniających:

Regresje nieliniowe w szacowanych parametrach:

- moc y=a x b ε

- wykładniczy y=a b x ε

- wykładniczy y=e a+b x ε

Dla równań liniowych i nieliniowych sprowadzalnych do liniowych, dla a i b jest rozwiązywany następujący układ:

Możesz skorzystać z gotowych formuł, które wynikają z tego systemu:

Bliskość związku między badanymi zjawiskami jest szacowana współczynnikiem liniowej korelacji par r xy dla regresji liniowej (-1≤r xy ≤1):

oraz indeks korelacji p xy - dla regresji nieliniowej (0≤p xy ≤1):

Ocenę jakości zbudowanego modelu da współczynnik (wskaźnik) determinacji oraz średni błąd aproksymacji.

Średni błąd aproksymacji to średnie odchylenie wartości obliczonych od rzeczywistych:

Dopuszczalny limit wartości A - nie więcej niż 8-10%.

Średni współczynnik sprężystości E pokazuje, o ile procent średnio zmieni się wynik y od swojej średniej wartości, gdy czynnik x zmieni się o 1% od swojej średniej wartości:

.

Zadaniem analizy wariancji jest analiza wariancji zmiennej zależnej:

∑(y-y )²=∑(y x -y )²+∑(y-y x)²

gdzie ∑(y-y)² to całkowita suma kwadratów odchyleń;

∑(y x -y)² - suma kwadratów odchyleń wynikających z regresji („wyjaśnione” lub „silnikowe”);

∑(y-y x)² - szczątkowa suma kwadratów odchyleń.

Udział wariancji wyjaśnionej regresją w całkowitej wariancji efektywnej cechy y charakteryzuje współczynnik (wskaźnik) determinacji R2:

Współczynnik determinacji to kwadrat współczynnika lub wskaźnika korelacji.

Test F - ocena jakości równania regresji - polega na sprawdzeniu hipotezy Ale o statystycznej nieistotności równania regresji i wskaźniku bliskości powiązania. W tym celu dokonuje się porównania rzeczywistego faktu F i krytycznej (tabelarycznej) tabeli F wartości kryterium F Fishera. Fakt F jest określany ze stosunku wartości wariancji czynnikowej i rezydualnej obliczonej dla jednego stopnia swobody:  ,

,

gdzie n to liczba jednostek populacji; m to liczba parametrów dla zmiennych x.

Tablica F jest maksymalną możliwą wartością kryterium pod wpływem czynników losowych dla danych stopni swobody i poziomu istotności a. Poziom istotności a - prawdopodobieństwo odrzucenia poprawnej hipotezy, pod warunkiem, że jest prawdziwa. Zwykle przyjmuje się, że a jest równe 0,05 lub 0,01.

Jeśli stół F< F факт, то Н о - гипотеза о случайной природе оцениваемых характеристик отклоняется и признается их статистическая значимость и надежность. Если F табл >F jest faktem, to hipoteza H o nie jest odrzucana i uznaje się nieistotność statystyczną, zawodność równania regresji.

Aby ocenić istotność statystyczną współczynników regresji i korelacji, oblicza się test t-Studenta i przedziały ufności dla każdego ze wskaźników. Postawiono hipotezę H o losowym charakterze wskaźników, tj. o ich nieznacznej różnicy od zera. Ocenę istotności współczynników regresji i korelacji za pomocą testu t-Studenta przeprowadza się porównując ich wartości z wielkością błędu losowego:

; ; .

Błędy losowe parametrów regresji liniowej i współczynnika korelacji określają wzory:

Porównując rzeczywiste i krytyczne (tabelaryczne) wartości statystyk t - t tabl i t fakt - przyjmujemy lub odrzucamy hipotezę Ho.

Związek między testem F Fishera a statystyką t-Studenta jest wyrażony przez równość

Jeśli t tabela< t факт то H o отклоняется, т.е. a , b и r xy не случайно отличаются от нуля и сформировались под влиянием систематически действующего фактора х. Если t табл >t fakt, że hipoteza H o nie jest odrzucana i uznawany jest losowy charakter formowania a, b lub r xy.

Aby obliczyć przedział ufności, wyznaczamy błąd krańcowy D dla każdego wskaźnika:

Δ a = t tabela m a , Δ b = t tabela m b .

Wzory na obliczanie przedziałów ufności są następujące:

γ a \u003d aΔ a; γ a \u003d a-Δ a; γ a =a+Δa

γb = bΔb; γb = b-Δb; γb =b+Δb

Jeżeli zero mieści się w granicach przedziału ufności, tj. Jeżeli dolna granica jest ujemna, a górna jest dodatnia, to zakłada się, że oszacowany parametr wynosi zero, ponieważ nie może jednocześnie przyjmować zarówno wartości dodatnich, jak i ujemnych.

Wartość prognozowaną y p określa się przez podstawienie odpowiedniej (prognozowanej) wartości x p do równania regresji y x =a+b·x . Średni błąd standardowy prognozy m y x oblicza się:  ,

,

gdzie

a przedział ufności prognozy jest budowany:

γ y x = y p Δ y p ; γ y x min=y p -Δ y p ; γ y x max=y p +Δ y p

gdzie Δ y x = t tabela ·m y x .

Przykład rozwiązania

Zadanie numer 1. Dla siedmiu terytoriów Uralu Dla 199X znane są wartości dwóch znaków.Tabela 1.

Wymagany: 1. Aby scharakteryzować zależność y od x, oblicz parametry następujących funkcji:

a) liniowy;

b) prawo potęgowe (wcześniej konieczne było wykonanie procedury linearyzacji zmiennych poprzez logarytmowanie obu części);

c) demonstracyjne;

d) hiperbola równoboczna (musisz też wymyślić, jak wstępnie zlinearyzować ten model).

2. Oceń każdy model za pomocą średniego błędu aproksymacji A i testu F Fishera.

Rozwiązanie (opcja nr 1)

Aby obliczyć parametry aib regresji liniowej y=a+b·x (obliczenia można wykonać za pomocą kalkulatora).rozwiązać układ równań normalnych względem ale I b:

Na podstawie danych początkowych obliczamy ∑y, ∑x, ∑y x, ∑x², ∑y²:

| tak | x | yx | x2 | y2 | y x | y-y x | Ai | |

| ja | 68,8 | 45,1 | 3102,88 | 2034,01 | 4733,44 | 61,3 | 7,5 | 10,9 |

| 2 | 61,2 | 59,0 | 3610,80 | 3481,00 | 3745,44 | 56,5 | 4,7 | 7,7 |

| 3 | 59,9 | 57,2 | 3426,28 | 3271,84 | 3588,01 | 57,1 | 2,8 | 4,7 |

| 4 | 56,7 | 61,8 | 3504,06 | 3819,24 | 3214,89 | 55,5 | 1,2 | 2,1 |

| 5 | 55,0 | 58,8 | 3234,00 | 3457,44 | 3025,00 | 56,5 | -1,5 | 2,7 |

| 6 | 54,3 | 47,2 | 2562,96 | 2227,84 | 2948,49 | 60,5 | -6,2 | 11,4 |

| 7 | 49,3 | 55,2 | 2721,36 | 3047,04 | 2430,49 | 57,8 | -8,5 | 17,2 |

| Całkowity | 405,2 | 384,3 | 22162,34 | 21338,41 | 23685,76 | 405,2 | 0,0 | 56,7 |

| Poślubić wartość (ogółem/n) | 57,89 tak | 54,90 x | 3166,05 x y | 3048,34 x² | 3383,68 y² | x | x | 8,1 |

| s | 5,74 | 5,86 | x | x | x | x | x | x |

| s2 | 32,92 | 34,34 | x | x | x | x | x | x |

a=y -b x = 57,89+0,35 54,9 ≈ 76,88

Równanie regresji: y= 76,88 - 0,35X. Wraz ze wzrostem średniej dziennej płacy o 1 rub. udział wydatków na zakup artykułów spożywczych zmniejsza się średnio o 0,35% punktu.

Oblicz liniowy współczynnik korelacji par: ![]()

Komunikacja jest umiarkowana, odwrotna.

Wyznaczmy współczynnik determinacji: r² xy =(-0,35)=0,127

Zmienność wyniku o 12,7% tłumaczy się zmiennością współczynnika x. Podstawianie rzeczywistych wartości do równania regresji x, określamy teoretyczne (obliczone) wartości y x . Znajdźmy wartość średniego błędu aproksymacji A :

Średnio obliczone wartości odbiegają od rzeczywistych o 8,1%.

Obliczmy kryterium F:

Uzyskana wartość wskazuje na konieczność przyjęcia hipotezy H 0 o losowym charakterze ujawnionej zależności oraz nieistotności statystycznej parametrów równania i wskaźnika bliskości powiązania.

1b. Konstrukcję modelu potęgowego y=a x b poprzedza procedura linearyzacji zmiennych. W tym przykładzie linearyzację wykonuje się logarytmując obie strony równania:

lg y=lg a + b lg x

Y=C+b Y

gdzie Y=lg(y), X=lg(x), C=lg(a).

Do obliczeń wykorzystujemy dane z tabeli. 1.3.

Tabela 1.3

| Y | x | YX | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 1,6542 | 3,0398 | 3,3768 | 2,7364 | 61,0 | 7,8 | 60,8 | 11,3 |

| 2 | 1,7868 | 1,7709 | 3,1642 | 3,1927 | 3,1361 | 56,3 | 4,9 | 24,0 | 8,0 |

| 3 | 1,7774 | 1,7574 | 3,1236 | 3,1592 | 3,0885 | 56,8 | 3,1 | 9,6 | 5,2 |

| 4 | 1,7536 | 1,7910 | 3,1407 | 3,0751 | 3,2077 | 55,5 | 1,2 | 1,4 | 2,1 |

| 5 | 1,7404 | 1,7694 | 3,0795 | 3,0290 | 3,1308 | 56,3 | -1,3 | 1,7 | 2,4 |

| 6 | 1,7348 | 1,6739 | 2,9039 | 3,0095 | 2,8019 | 60,2 | -5,9 | 34,8 | 10,9 |

| 7 | 1,6928 | 1,7419 | 2,9487 | 2,8656 | 3,0342 | 57,4 | -8,1 | 65,6 | 16,4 |

| Całkowity | 12,3234 | 12,1587 | 21,4003 | 21,7078 | 21,1355 | 403,5 | 1,7 | 197,9 | 56,3 |

| Mieć na myśli | 1,7605 | 1,7370 | 3,0572 | 3,1011 | 3,0194 | x | x | 28,27 | 8,0 |

| σ | 0,0425 | 0,0484 | x | x | x | x | x | x | x |

| σ2 | 0,0018 | 0,0023 | x | x | x | x | x | x | x |

Oblicz C i b:

C=Y -b X = 1,7605+0,298 1,7370 = 2,278126

Otrzymujemy równanie liniowe: Y=2,278-0,298 X

Po jego wzmocnieniu otrzymujemy: y=10 2,278 x -0,298

Podstawiając w tym równaniu rzeczywiste wartości X, uzyskujemy teoretyczne wartości wyniku. Na ich podstawie obliczamy wskaźniki: szczelność połączenia – wskaźnik korelacji p xy oraz średni błąd aproksymacji A .

Charakterystyki modelu potęgowego wskazują, że opisuje on zależność nieco lepiej niż funkcja liniowa.

1c. Konstrukcja równania krzywej wykładniczej y \u003d a b x jest poprzedzona procedurą linearyzacji zmiennych przy logarytmowaniu obu części równania:

lg y=lg a + x lg b

Y=C+B x

Do obliczeń wykorzystujemy dane tabeli.

| Y | x | Yx | Y2 | x2 | y x | y-y x | (y-yx)² | Ai | |

| 1 | 1,8376 | 45,1 | 82,8758 | 3,3768 | 2034,01 | 60,7 | 8,1 | 65,61 | 11,8 |

| 2 | 1,7868 | 59,0 | 105,4212 | 3,1927 | 3481,00 | 56,4 | 4,8 | 23,04 | 7,8 |

| 3 | 1,7774 | 57,2 | 101,6673 | 3,1592 | 3271,84 | 56,9 | 3,0 | 9,00 | 5,0 |

| 4 | 1,7536 | 61,8 | 108,3725 | 3,0751 | 3819,24 | 55,5 | 1,2 | 1,44 | 2,1 |

| 5 | 1,7404 | 58,8 | 102,3355 | 3,0290 | 3457,44 | 56,4 | -1,4 | 1,96 | 2,5 |

| 6 | 1,7348 | 47,2 | 81,8826 | 3,0095 | 2227,84 | 60,0 | -5,7 | 32,49 | 10,5 |

| 7 | 1,6928 | 55,2 | 93,4426 | 2,8656 | 3047,04 | 57,5 | -8,2 | 67,24 | 16,6 |

| Całkowity | 12,3234 | 384,3 | 675,9974 | 21,7078 | 21338,41 | 403,4 | -1,8 | 200,78 | 56,3 |

| Poślubić zł. | 1,7605 | 54,9 | 96,5711 | 3,1011 | 3048,34 | x | x | 28,68 | 8,0 |

| σ | 0,0425 | 5,86 | x | x | x | x | x | x | x |

| σ2 | 0,0018 | 34,339 | x | x | x | x | x | x | x |

Wartości parametrów regresji A i W wyniósł:

A=Y -B x = 1,7605+0,0023 54,9 = 1,887

Otrzymano równanie liniowe: Y=1,887-0,0023x. Wzmacniamy powstałe równanie i zapisujemy je w zwykłej formie:

y x =10 1,887 10 -0,0023x = 77,1 0,9947 x

Ścisłość związku szacujemy za pomocą wskaźnika korelacji p xy:

Analiza regresji stanowi podstawę tworzenia większości modeli ekonometrycznych, do których należy zaliczyć modele szacowania kosztów. Do budowy modeli wyceny można zastosować tę metodę, jeśli liczba analogów (obiektów porównywalnych) i liczba czynników kosztowych (elementów porównawczych) są ze sobą skorelowane w następujący sposób: P> (5 -g-10) x do, tych. powinno być 5-10 razy więcej analogów niż czynników kosztowych. Ten sam wymóg dotyczący stosunku ilości danych do liczby czynników dotyczy innych zadań: ustalenie relacji między kosztem a parametrami konsumenckimi obiektu; uzasadnienie procedury obliczania wskaźników korygujących; wyjaśnienie trendów cenowych; ustalenie związku między zużyciem a zmianami czynników wpływających; uzyskiwanie zależności do kalkulacji standardów kosztowych itp. Spełnienie tego warunku jest konieczne w celu zmniejszenia prawdopodobieństwa pracy z próbą danych, która nie spełnia warunku rozkładu normalnego zmiennych losowych.

Zależność regresji odzwierciedla tylko średni trend zmiennej wynikowej, takiej jak koszt, ze zmian jednej lub więcej zmiennych czynników, takich jak lokalizacja, liczba pokoi, powierzchnia, piętro itp. Jest to różnica między zależnością regresji a zależnością funkcjonalną, w której wartość zmiennej wynikowej jest ściśle określona dla danej wartości zmiennych czynnikowych.

Obecność relacji regresji / między wynikowymi w i zmienne czynnikowe x p ..., x k(czynniki) wskazuje, że zależność ta jest determinowana nie tylko wpływem wybranych zmiennych czynnikowych, ale także wpływem zmiennych, z których część jest ogólnie nieznana, innych nie można ocenić i uwzględnić:

Wpływ nieuwzględnionych zmiennych jest oznaczony drugim członem tego równania ?, co nazywa się błędem aproksymacji.

Istnieją następujące typy zależności regresji:

- ? regresja parowana – związek między dwiema zmiennymi (wypadkową i czynnikową);

- ? regresja wielokrotna - zależność jednej zmiennej wynikowej od dwóch lub więcej zmiennych czynnikowych uwzględnionych w badaniu.

Głównym zadaniem analizy regresji jest ilościowe określenie bliskości związku między zmiennymi (w regresji sparowanej) a zmiennymi wielokrotnymi (w regresji wielorakiej). Ścisłość związku jest określana ilościowo przez współczynnik korelacji.

Zastosowanie analizy regresji pozwala na ustalenie schematu wpływu głównych czynników (cech hedonicznych) na badany wskaźnik, zarówno w ich całości, jak i każdego z nich z osobna. Za pomocą analizy regresji, jako metody statystyki matematycznej, można po pierwsze znaleźć i opisać postać analitycznej zależności wynikowej (pożądanej) zmiennej od czynnikowych, a po drugie oszacować bliskość ta zależność.

Rozwiązując pierwszy problem, otrzymujemy matematyczny model regresji, za pomocą którego następnie obliczany jest pożądany wskaźnik dla danych wartości czynników. Rozwiązanie drugiego problemu umożliwia ustalenie wiarygodności obliczonego wyniku.

Analizę regresji można zatem zdefiniować jako zestaw procedur formalnych (matematycznych) służących do pomiaru ścisłości, kierunku i analitycznego wyrazu postaci zależności między zmienną wynikową a zmienną czynnikową, tj. wynikiem takiej analizy powinien być strukturalnie i ilościowo zdefiniowany model statystyczny o postaci:

![]()

gdzie y -średnia wartość zmiennej wynikowej (pożądany wskaźnik, np. koszt, czynsz, stopa kapitalizacji) powyżej P jej obserwacje; x to wartość zmiennej czynnika (/-ty czynnik kosztu); do - liczba zmiennych czynnikowych.

Funkcjonować f(x l ,...,x lc), opisując zależność zmiennej wynikowej od zmiennych czynnikowych nazywamy równaniem (funkcją) regresji. Termin „regresja” (regresja (łac.) – wycofanie się, powrót do czegoś) wiąże się ze specyfiką jednego z konkretnych zadań rozwiązywanych na etapie powstawania metody, a obecnie nie oddaje całej istoty metody. metoda, ale nadal jest stosowana.

Analiza regresji zazwyczaj obejmuje następujące kroki:

- ? tworzenie próbki jednorodnych obiektów i gromadzenie wstępnych informacji o tych obiektach;

- ? wybór głównych czynników wpływających na zmienną wynikową;

- ? sprawdzenie próbki pod kątem normalności za pomocą x 2 lub kryterium dwumianowe;

- ? przyjęcie hipotezy o formie komunikacji;

- ? przetwarzanie danych matematycznych;

- ? uzyskanie modelu regresji;

- ? ocena jego wskaźników statystycznych;

- ? obliczenia weryfikacyjne z wykorzystaniem modelu regresji;

- ? analiza wyników.

Określona sekwencja operacji ma miejsce w badaniu zarówno relacji parowej między zmienną czynnikową a jedną zmienną wynikową, jak i relacji wielokrotnej między zmienną wynikową a kilkoma zmiennymi czynnikowymi.

Zastosowanie analizy regresji nakłada pewne wymagania na informacje początkowe:

- ? statystyczna próba obiektów powinna być jednorodna pod względem funkcjonalnym i konstrukcyjno-technologicznym;

- ? dość liczne;

- ? badany wskaźnik kosztu – zmienna wynikowa (cena, koszt, koszty) – musi zostać sprowadzony do tych samych warunków dla jego obliczenia dla wszystkich obiektów w próbie;

- ? zmienne czynnikowe muszą być mierzone wystarczająco dokładnie;

- ? zmienne czynnikowe muszą być niezależne lub minimalnie zależne.

Wymagania dotyczące jednorodności i kompletności próbki są ze sobą sprzeczne: im ściślej dokonuje się selekcji obiektów według ich jednorodności, tym mniejsza jest próbka i odwrotnie, aby powiększyć próbkę, konieczne jest uwzględnienie obiektów, które nie są do siebie bardzo podobne.

Po zebraniu danych dla grupy jednorodnych obiektów są one analizowane w celu ustalenia postaci zależności między zmiennymi wynikowymi i czynnikowymi w postaci teoretycznej linii regresji. Proces znajdowania teoretycznej linii regresji polega na rozsądnym wyborze krzywej aproksymacyjnej i obliczeniu współczynników jej równania. Linia regresji jest gładką krzywą (w szczególnym przypadku linią prostą), która opisuje za pomocą funkcji matematycznej ogólny trend badanej zależności i wygładza nieregularne, losowe wartości odstające od wpływu czynników ubocznych.

Aby wyświetlić sparowane zależności regresji w zadaniach oceny, najczęściej używane są następujące funkcje: liniowa - y - 0 + ars + s moc - y - aj&i + c demonstracyjny - y - wykładniczy liniowy - y - a 0 + ar * + s. Tutaj - mi błąd aproksymacji spowodowany działaniem nieuwzględnionych czynników losowych.

W tych funkcjach y jest zmienną wynikową; x - zmienna czynnika (czynnik); ale 0 , a r a 2 - parametry modelu regresji, współczynniki regresji.

Liniowy model wykładniczy należy do klasy tzw. modeli hybrydowych postaci:

gdzie

gdzie x (i = 1, /) - wartości współczynników;

b t (i = 0, /) to współczynniki równania regresji.

W tym równaniu składniki A, B I Z odpowiadają kosztowi poszczególnych składników wycenianego składnika aktywów, na przykład kosztowi działki i kosztowi ulepszeń, a parametr Q jest powszechny. Ma na celu dostosowanie wartości wszystkich składników wycenianego zasobu do wspólnego czynnika wpływającego, takiego jak lokalizacja.

Wartości czynników, które znajdują się w stopniach odpowiednich współczynników, są zmiennymi binarnymi (0 lub 1). Czynniki, które są podstawą stopnia, są zmiennymi dyskretnymi lub ciągłymi.

Czynniki związane ze współczynnikami znaku mnożenia są również ciągłe lub dyskretne.

Specyfikacja prowadzona jest co do zasady w podejściu empirycznym i obejmuje dwa etapy:

- ? wykreślanie punktów pola regresji na wykresie;

- ? analiza graficzna (wizualna) rodzaju możliwej krzywej aproksymującej.

Nie zawsze można od razu wybrać rodzaj krzywej regresji. Aby to określić, punkty pola regresji są najpierw wykreślane na wykresie zgodnie z danymi początkowymi. Następnie linia jest wizualnie rysowana wzdłuż pozycji punktów, próbując znaleźć jakościowy wzór relacji: równomierny wzrost lub równomierny spadek, wzrost (spadek) ze wzrostem (spadek) tempa dynamiki, płynne podejście do pewien poziom.

Uzupełnieniem tego empirycznego podejścia jest analiza logiczna, wychodząc od znanych już wyobrażeń o ekonomicznym i fizycznym charakterze badanych czynników oraz ich wzajemnym oddziaływaniu.

Przykładowo wiadomo, że zależności zmiennych wynikowych – wskaźników ekonomicznych (ceny, czynsz) od szeregu zmiennych czynnikowych – czynników cenotwórczych (odległość od centrum miejscowości, powierzchnia itp.) są nieliniowe , i można je dość ściśle opisać za pomocą funkcji potęgowej, wykładniczej lub kwadratowej . Ale przy niewielkich zakresach współczynników akceptowalne wyniki można również uzyskać za pomocą funkcji liniowej.

Jeśli nadal nie można od razu dokonać pewnego wyboru jednej funkcji, wybiera się dwie lub trzy funkcje, oblicza się ich parametry, a następnie, stosując odpowiednie kryteria szczelności połączenia, ostatecznie wybiera się funkcję.

Teoretycznie proces regresji znajdowania kształtu krzywej nazywa się specyfikacja model i jego współczynniki - kalibrowanie modele.

Jeżeli okaże się, że wynikowa zmienna y zależy od kilku zmiennych czynnikowych (czynników) x ( , x 2 , ..., x k, następnie uciekają się do budowania modelu regresji wielokrotnej. Zwykle stosowane są trzy formy komunikacji wielokrotnej: liniowa - y - a 0 + a x x x + a^x 2 + ... + k x k, demonstracyjny - y - 0 a*i a x t- a x b, moc - y - a 0 x x ix 2 a 2. x^ lub ich kombinacje.

Funkcje wykładnicze i wykładnicze są bardziej uniwersalne, ponieważ przybliżają zależności nieliniowe, które stanowią większość zależności badanych w ocenie. Ponadto mogą być wykorzystywane w ocenie obiektów oraz w metodzie modelowania statystycznego do oceny masy oraz w metodzie bezpośredniego porównania w ocenie indywidualnej przy ustalaniu współczynników korekcyjnych.

Na etapie kalibracji parametry modelu regresji oblicza się metodą najmniejszych kwadratów, której istotą jest suma kwadratów odchyleń obliczonych wartości zmiennej wynikowej w., tj. obliczone zgodnie z wybranym równaniem relacyjnym, z wartości rzeczywistych powinno być minimalne:

Wartości j) (. i tak. znany zatem Q jest funkcją tylko współczynników równania. Aby znaleźć minimum S weź pochodne cząstkowe Q przez współczynniki równania i przyrównać je do zera:

W efekcie otrzymujemy układ równań normalnych, których liczba jest równa liczbie wyznaczonych współczynników żądanego równania regresji.

Załóżmy, że musimy znaleźć współczynniki równania liniowego y - 0 + ar. Suma kwadratów odchyleń wynosi:

/=1

Rozróżnij funkcję Q przez nieznane współczynniki 0 i przyrównać pochodne cząstkowe do zera:

Po przekształceniach otrzymujemy:

gdzie P - liczba oryginalnych wartości rzeczywistych w je (liczba analogów).

Powyższa procedura obliczania współczynników równania regresji ma zastosowanie również dla zależności nieliniowych, jeśli te zależności można zlinearyzować, tj. doprowadzić do postaci liniowej za pomocą zmiany zmiennych. Funkcje potęgowe i wykładnicze po logarytmowaniu i odpowiadającej im zmianie zmiennych przybierają postać liniową. Na przykład funkcja potęgowa po logarytmowaniu przyjmuje postać: In y \u003d 1n 0 +x 1 godz. Po zmianie zmiennych T- w y, L 0 - w i nr X- W x otrzymujemy funkcję liniową

Y=A0 + cijX, których współczynniki znajdują się w sposób opisany powyżej.

Metoda najmniejszych kwadratów służy również do obliczania współczynników modelu regresji wielokrotnej. Tak więc układ równań normalnych do obliczania funkcji liniowej z dwiema zmiennymi Xj I x 2 po serii przekształceń wygląda to tak:

Zwykle ten układ równań jest rozwiązywany za pomocą metod algebry liniowej. Wielokrotna funkcja wykładnicza jest sprowadzana do postaci liniowej poprzez logarytmowanie i zmianę zmiennych w taki sam sposób, jak sparowana funkcja wykładnicza.

Stosując modele hybrydowe, współczynniki regresji wielokrotnej wyznacza się za pomocą procedur numerycznych metody kolejnych przybliżeń.

Aby dokonać ostatecznego wyboru spośród kilku równań regresji, konieczne jest przetestowanie każdego równania pod kątem ścisłości związku, który jest mierzony współczynnikiem korelacji, wariancją i współczynnikiem zmienności. Do oceny można również skorzystać z kryteriów Studenta i Fishera. Im większa szczelność połączenia odsłania krzywą, tym bardziej jest to korzystne, wszystkie inne rzeczy są równe.

Jeśli problem takiej klasy jest rozwiązywany, gdy konieczne jest ustalenie zależności wskaźnika kosztów od czynników kosztowych, to chęć uwzględnienia jak największej liczby czynników wpływających i tym samym zbudowania dokładniejszego modelu regresji wielokrotnej jest zrozumiale. Jednak rozszerzanie się liczby czynników utrudniają dwa obiektywne ograniczenia. Po pierwsze, budowanie modelu regresji wielokrotnej wymaga znacznie większej próbki obiektów niż budowanie modelu sparowanego. Ogólnie przyjmuje się, że liczba obiektów w próbie powinna przekraczać liczbę P czynniki, co najmniej 5-10 razy. Wynika z tego, że aby zbudować model z trzema czynnikami wpływającymi, konieczne jest zebranie próbki około 20 obiektów o różnych zestawach wartości czynników. Po drugie, wybrane do modelu czynniki w ich wpływie na wskaźnik wartości powinny być od siebie wystarczająco niezależne. Nie jest to łatwe do zapewnienia, ponieważ próbka zwykle łączy obiekty należące do tej samej rodziny, w której występuje regularna zmiana wielu czynników z obiektu na obiekt.

Jakość modeli regresji jest zwykle testowana przy użyciu następujących statystyk.

Odchylenie standardowe błędu równania regresji (błąd estymacji):

gdzie P - wielkość próbki (liczba analogów);

do - liczba czynników (czynniki kosztowe);

Błąd niewyjaśniony równaniem regresji (rys. 3.2);

tak. - rzeczywista wartość wynikowej zmiennej (na przykład koszt); y t - obliczona wartość zmiennej wynikowej.

Ten wskaźnik jest również nazywany standardowy błąd estymacji (błąd RMS). Na rysunku kropki wskazują określone wartości próbki, symbol wskazuje linię średnich wartości próbki, nachylona linia przerywana to linia regresji.

Ryż. 3.2.

Odchylenie standardowe błędu oszacowania mierzy, jak bardzo rzeczywiste wartości y odbiegają od odpowiadających im wartości obliczonych. w( , uzyskana za pomocą modelu regresji. Jeżeli próba, na której budowany jest model, podlega prawu rozkładu normalnego, to można twierdzić, że 68% wartości rzeczywistych w są w zasięgu w ± &mi od linii regresji, a 95% - w zakresie w ± 2d e. Ten wskaźnik jest wygodny, ponieważ jednostki miary sg? dopasuj jednostki miary w,. W związku z tym można go wykorzystać do wskazania dokładności wyniku uzyskanego w procesie oceny. Na przykład w świadectwie wartości można wskazać, że wartość wartości rynkowej uzyskana za pomocą modelu regresji V z prawdopodobieństwem 95% mieści się w przedziale od (V-2d.) zanim (w + 2ds).

Współczynnik zmienności zmiennej wynikowej:

gdzie y -średnia wartość otrzymanej zmiennej (rysunek 3.2).

W analizie regresji współczynnik zmienności var jest odchyleniem standardowym wyniku, wyrażonym jako procent średniej zmiennej wynikowej. Współczynnik zmienności może służyć jako kryterium predykcyjnych właściwości otrzymanego modelu regresji: im mniejsza wartość var, tym wyższe są właściwości predykcyjne modelu. Stosowanie współczynnika zmienności jest lepsze niż wykładnika &e, ponieważ jest to wykładnik względny. W praktycznym zastosowaniu tego wskaźnika można zalecić niestosowanie modelu, którego współczynnik zmienności przekracza 33%, gdyż w tym przypadku nie można powiedzieć, że próbki te podlegają prawu rozkładu normalnego.

Współczynnik determinacji (współczynnik korelacji wielokrotnej do kwadratu):

Wskaźnik ten służy do analizy ogólnej jakości otrzymanego modelu regresji. Wskazuje, jaki procent zmienności zmiennej wynikowej wynika z wpływu wszystkich zmiennych czynnikowych uwzględnionych w modelu. Współczynnik determinacji zawsze mieści się w zakresie od zera do jednego. Im wartość współczynnika determinacji bliższa jedności, tym lepiej model opisuje oryginalne szeregi danych. Współczynnik determinacji można przedstawić w inny sposób:

Oto błąd wyjaśniony przez model regresji,

![]() ale

ale ![]() - błąd niewyjaśniony

- błąd niewyjaśniony

Model regresji. Z ekonomicznego punktu widzenia kryterium to pozwala ocenić, jaki procent zmienności ceny wyjaśnia równanie regresji.

Dokładny limit akceptacji wskaźnika R2 nie można określić dla wszystkich przypadków. Należy wziąć pod uwagę zarówno wielkość próby, jak i sensowną interpretację równania. Z reguły przy badaniu danych o obiektach tego samego typu, uzyskanych w przybliżeniu w tym samym czasie, wartość R2 nie przekracza poziomu 0,6-0,7. Jeśli wszystkie błędy przewidywania wynoszą zero, tj. gdy zależność między zmienną wynikową i czynnikową jest funkcjonalna, wtedy R2 =1.

Skorygowany współczynnik determinacji:

Konieczność wprowadzenia skorygowanego współczynnika determinacji tłumaczy się tym, że wraz ze wzrostem liczby czynników do zwykły współczynnik determinacji prawie zawsze wzrasta, ale liczba stopni swobody maleje (n - k- jeden). Wprowadzona korekta zawsze zmniejsza wartość R2, o ile (P - 1) > (p- do - jeden). W rezultacie wartość R 2 CKOf) może nawet stać się ujemna. Oznacza to, że wartość R2 był bliski zeru przed korektą, a proporcja wariancji wyjaśniona równaniem regresji zmiennej w bardzo mały.

Spośród dwóch wersji modeli regresji, które różnią się wartością skorygowanego współczynnika determinacji, ale mają równie dobre inne kryteria jakości, preferowany jest wariant z dużą wartością skorygowanego współczynnika determinacji. Współczynnik determinacji nie jest korygowany, jeżeli (n - k): k> 20.

Współczynnik Fishera:

Kryterium to służy do oceny istotności współczynnika determinacji. Pozostała suma kwadratów ![]() jest miarą błędu predykcji przy użyciu regresji znanych wartości kosztów w.. Jego porównanie z sumą kwadratów regresji pokazuje, ile razy zależność regresji przewiduje wynik lepiej niż średnia w. Istnieje tabela wartości krytycznych F R Współczynnik Fishera zależny od liczby stopni swobody licznika - do, mianownik v 2 = p - k- 1 i poziom istotności a. Jeżeli obliczona wartość kryterium Fishera F R jest większa od wartości tabeli, to hipoteza o nieistotności współczynnika determinacji, tj. o rozbieżności między zależnościami zawartymi w równaniu regresji a rzeczywiście istniejącymi, z prawdopodobieństwem p = 1 - a jest odrzucane.

jest miarą błędu predykcji przy użyciu regresji znanych wartości kosztów w.. Jego porównanie z sumą kwadratów regresji pokazuje, ile razy zależność regresji przewiduje wynik lepiej niż średnia w. Istnieje tabela wartości krytycznych F R Współczynnik Fishera zależny od liczby stopni swobody licznika - do, mianownik v 2 = p - k- 1 i poziom istotności a. Jeżeli obliczona wartość kryterium Fishera F R jest większa od wartości tabeli, to hipoteza o nieistotności współczynnika determinacji, tj. o rozbieżności między zależnościami zawartymi w równaniu regresji a rzeczywiście istniejącymi, z prawdopodobieństwem p = 1 - a jest odrzucane.

Średni błąd aproksymacji(odchylenie średnie procentowe) oblicza się jako średnią względną różnicę, wyrażoną w procentach, między wartościami rzeczywistymi i obliczonymi zmiennej wynikowej:

Im niższa wartość tego wskaźnika, tym lepsza jakość predykcyjna modelu. Gdy wartość tego wskaźnika nie przekracza 7%, wskazują one na dużą dokładność modelu. Jeśli 8 > 15%, wskazują na niezadowalającą dokładność modelu.

Błąd standardowy współczynnika regresji:

gdzie (/I) -1 .- przekątny element macierzy (X G X) ~ 1 do - liczba czynników;

X- macierz wartości zmiennych czynnikowych:

X7- transponowana macierz wartości zmiennych czynnikowych;

(JL) _| jest macierzą odwrotną do macierzy.

Im mniejsze są te wyniki dla każdego współczynnika regresji, tym bardziej wiarygodne jest oszacowanie odpowiedniego współczynnika regresji.

Test studenta (statystyka t):

Kryterium to pozwala zmierzyć stopień wiarygodności (istotności) związku ze względu na dany współczynnik regresji. Jeśli obliczona wartość T. większa niż wartość tabeli

T av , gdzie v - p - k - 1 to liczba stopni swobody, to hipoteza, że współczynnik ten jest statystycznie nieistotny jest odrzucana z prawdopodobieństwem (100 - a)%. Istnieją specjalne tablice rozkładu /, które umożliwiają wyznaczenie wartości krytycznej kryterium przy zadanym poziomie istotności a i liczbie stopni swobody v. Najczęściej stosowana wartość a to 5%.

Wielokoliniowość, tj. efekt wzajemnych relacji między zmiennymi czynnikowymi prowadzi do konieczności zadowolenia się ograniczoną ich liczbą. Jeśli nie zostanie to wzięte pod uwagę, możesz skończyć z nielogicznym modelem regresji. Aby uniknąć negatywnego wpływu współliniowości, przed zbudowaniem modelu regresji wielokrotnej obliczane są współczynniki korelacji par rxjxj między wybranymi zmiennymi X. I x

Tutaj XjX; -średnia wartość iloczynu dwóch zmiennych czynnikowych;

XjXj- iloczyn średnich wartości dwóch zmiennych czynnikowych;

Ocena wariancji zmiennej czynnikowej x..

Dwie zmienne są uważane za powiązane regresywnie (tj. współliniowe), jeśli ich współczynnik korelacji parami jest ściśle większy niż 0,8 w wartości bezwzględnej. W takim przypadku każdą z tych zmiennych należy wykluczyć z rozważania.

W celu poszerzenia możliwości analizy ekonomicznej powstałych modeli regresji stosuje się średnie współczynniki sprężystości, określone wzorem:

gdzie Xj-średnia wartość odpowiedniej zmiennej czynnika;

y -średnia wartość zmiennej wynikowej; ja - współczynnik regresji dla odpowiedniej zmiennej czynnika.

Współczynnik elastyczności pokazuje, o ile procent zmieni się przeciętnie wartość zmiennej wynikowej, gdy zmienna czynnika zmieni się o 1%, tj. jak zmienna wynikowa reaguje na zmianę zmiennej czynnika. Na przykład, jak wygląda cena mkw. m powierzchni mieszkania w odległości od centrum miasta.

Przydatne z punktu widzenia analizy istotności konkretnego współczynnika regresji jest oszacowanie prywatny współczynnik determinacji:

Oto oszacowanie wariancji wyniku

zmienny. Współczynnik ten pokazuje, o ile procent zmienność wynikowej zmiennej jest wyjaśniona zmiennością /-tej zmiennej czynnika zawartej w równaniu regresji.

- Przez cechy hedoniczne rozumie się cechy przedmiotu, które odzwierciedlają jego użyteczne (cenne) właściwości z punktu widzenia kupujących i sprzedających.

Podczas studiów studenci bardzo często spotykają się z różnymi równaniami. Jeden z nich - równanie regresji - jest rozważany w tym artykule. Ten typ równania jest używany w szczególności do opisywania charakterystyk zależności między parametrami matematycznymi. Ten rodzaj równości jest używany w statystyce i ekonometrii.

Definicja regresji

W matematyce regresja jest rozumiana jako pewna wielkość, która opisuje zależność średniej wartości zbioru danych od wartości innej wielkości. Równanie regresji pokazuje, jako funkcję określonej cechy, średnią wartość innej cechy. Funkcja regresji ma postać prostego równania y \u003d x, w którym y działa jako zmienna zależna, a x jest zmienną niezależną (czynnik cech). W rzeczywistości regresja jest wyrażona jako y = f (x).

Jakie są rodzaje relacji między zmiennymi?

Generalnie rozróżnia się dwa przeciwstawne typy relacji: korelację i regresję.

Pierwsza charakteryzuje się równością zmiennych warunkowych. W tym przypadku nie wiadomo na pewno, która zmienna zależy od drugiej.

Jeśli nie ma równości między zmiennymi, a warunki mówią, która zmienna jest objaśniająca, a która zależna, to możemy mówić o obecności połączenia drugiego typu. Aby zbudować równanie regresji liniowej, konieczne będzie ustalenie, jaki rodzaj zależności jest obserwowany.

Rodzaje regresji

Do chwili obecnej istnieje 7 różnych typów regresji: hiperboliczna, liniowa, wielokrotna, nieliniowa, parami, odwrotna, logarytmicznie liniowa.

Hiperboliczny, liniowy i logarytmiczny

Równanie regresji liniowej jest używane w statystyce do jasnego wyjaśnienia parametrów równania. Wygląda na to, że y = c + m * x + E. Równanie hiperboliczne ma postać regularnej hiperboli y \u003d c + m / x + E. Równanie logarytmicznie liniowe wyraża zależność za pomocą funkcji logarytmicznej: In y \u003d In c + m * In x + In E.

Wielokrotne i nieliniowe

Dwa bardziej złożone typy regresji są wielokrotne i nieliniowe. Równanie regresji wielokrotnej wyraża funkcja y \u003d f (x 1, x 2 ... x c) + E. W tej sytuacji y jest zmienną zależną, a x jest zmienną objaśniającą. Zmienna E jest stochastyczna i uwzględnia w równaniu wpływ innych czynników. Równanie regresji nieliniowej jest nieco niespójne. Z jednej strony w odniesieniu do branych pod uwagę wskaźników nie jest on liniowy, z drugiej zaś w roli wskaźników oceny jest liniowy.

Regresje odwrotne i parami

Odwrotność to rodzaj funkcji, którą należy przekształcić w formę liniową. W najbardziej tradycyjnych programach użytkowych ma postać funkcji y \u003d 1 / c + m * x + E. Równanie regresji sparowanej pokazuje zależność między danymi jako funkcję y = f(x) + E. Podobnie jak inne równania, y zależy od x, a E jest parametrem stochastycznym.

Pojęcie korelacji

Jest to wskaźnik, który pokazuje istnienie związku między dwoma zjawiskami lub procesami. Siła związku jest wyrażona jako współczynnik korelacji. Jego wartość waha się w przedziale [-1;+1]. Wskaźnik ujemny wskazuje na obecność sprzężenia zwrotnego, wskaźnik dodatni wskazuje na bezpośredni. Jeśli współczynnik przyjmuje wartość równą 0, to nie ma związku. Im wartość jest bliższa 1 - im silniejszy związek między parametrami, im bliżej 0 - tym słabszy.

Metody

Metody parametryczne korelacji mogą oszacować szczelność związku. Są one używane na podstawie oszacowań rozkładu do badania parametrów zgodnych z prawem rozkładu normalnego.

Parametry równania regresji liniowej są niezbędne do określenia rodzaju zależności, funkcji równania regresji oraz oceny wskaźników wybranego wzoru zależności. Pole korelacji jest używane jako metoda identyfikacji relacji. Aby to zrobić, wszystkie istniejące dane muszą być przedstawione graficznie. W prostokątnym dwuwymiarowym układzie współrzędnych należy wykreślić wszystkie znane dane. W ten sposób powstaje pole korelacji. Wartość czynnika opisującego zaznaczona jest wzdłuż odciętej, natomiast wartości czynnika zależnego zaznaczono wzdłuż rzędnej. Jeśli istnieje związek funkcjonalny między parametrami, układają się one w formie linii.

Jeśli współczynnik korelacji takich danych jest mniejszy niż 30%, możemy mówić o prawie całkowitym braku połączenia. Jeśli wynosi od 30% do 70%, oznacza to obecność ogniw o średniej szczelności. Wskaźnik 100% świadczy o funkcjonalnym połączeniu.

Równanie regresji nieliniowej, podobnie jak liniowe, musi być uzupełnione wskaźnikiem korelacji (R).

Korelacja dla regresji wielokrotnej

Współczynnik determinacji jest wskaźnikiem kwadratu korelacji wielokrotnej. Mówi o ścisłym związku prezentowanego zestawu wskaźników z badaną cechą. Może też mówić o charakterze wpływu parametrów na wynik. Za pomocą tego wskaźnika ocenia się równanie regresji wielokrotnej.

W celu obliczenia wskaźnika korelacji wielokrotnej konieczne jest obliczenie jego wskaźnika.

Metoda najmniejszych kwadratów

Ta metoda jest sposobem szacowania czynników regresji. Jego istota polega na minimalizowaniu sumy kwadratów odchyleń uzyskanych dzięki zależności współczynnika od funkcji.

Za pomocą takiej metody można oszacować sparowane równanie regresji liniowej. Tego typu równania stosuje się w przypadku wykrycia między wskaźnikami sparowanej zależności liniowej.

Opcje równań

Każdy parametr funkcji regresji liniowej ma określone znaczenie. Równanie sparowanej regresji liniowej zawiera dwa parametry: ci m. Parametr t pokazuje średnią zmianę końcowego wskaźnika funkcji y, z zastrzeżeniem spadku (wzrostu) zmiennej x o jedną jednostkę umowną. Jeżeli zmienna x wynosi zero, to funkcja jest równa parametrowi c. Jeśli zmienna x nie jest równa zeru, to czynnik c nie ma ekonomicznego sensu. Jedyny wpływ na funkcję ma znak przed współczynnikiem c. Jeśli jest minus, to możemy powiedzieć o powolnej zmianie wyniku w porównaniu do współczynnika. Jeśli jest plus, oznacza to przyspieszoną zmianę wyniku.

Każdy parametr zmieniający wartość równania regresji można wyrazić w postaci równania. Na przykład czynnik c ma postać c = y - mx.

Zgrupowane dane

Istnieją takie warunki zadania, w których wszystkie informacje są pogrupowane według atrybutu x, ale jednocześnie dla pewnej grupy wskazane są odpowiednie średnie wartości wskaźnika zależnego. W tym przypadku wartości średnie charakteryzują zależność wskaźnika od x. W ten sposób zgrupowane informacje pomagają znaleźć równanie regresji. Służy do analizy relacji. Jednak ta metoda ma swoje wady. Niestety średnie często podlegają wahaniom zewnętrznym. Te wahania nie są odzwierciedleniem wzorców relacji, tylko maskują jej „szum”. Średnie pokazują wzorce relacji znacznie gorsze niż równanie regresji liniowej. Można je jednak wykorzystać jako podstawę do znalezienia równania. Mnożąc wielkość danej populacji przez odpowiednią średnią, możesz otrzymać sumę y w grupie. Następnie musisz wybić wszystkie otrzymane kwoty i znaleźć ostateczny wskaźnik y. Nieco trudniej jest wykonać obliczenia ze wskaźnikiem sumy xy. W przypadku, gdy przedziały są małe, możemy warunkowo przyjąć, że wskaźnik x dla wszystkich jednostek (w ramach grupy) jest taki sam. Pomnóż to przez sumę y, aby znaleźć sumę iloczynów x i y. Ponadto wszystkie sumy są zbijane razem i uzyskuje się całkowitą sumę xy.

Regresja równań wielokrotnych par: ocena ważności związku

Jak omówiono wcześniej, regresja wielokrotna ma funkcję postaci y \u003d f (x 1, x 2, ..., x m) + E. Najczęściej takie równanie służy do rozwiązywania problemu podaży i popytu na towary, dochodów odsetkowych od odkupionych akcji, badania przyczyn i rodzaju funkcji kosztu produkcji. Jest również aktywnie wykorzystywane w wielu różnych badaniach i obliczeniach makroekonomicznych, ale na poziomie mikroekonomii to równanie jest używane nieco rzadziej.

Głównym zadaniem regresji wielokrotnej jest zbudowanie modelu danych zawierającego ogromną ilość informacji w celu dalszego określenia, jaki wpływ każdy z czynników ma indywidualnie i w całości na modelowany wskaźnik i jego współczynniki. Równanie regresji może przyjmować różne wartości. W tym przypadku do oceny zależności stosuje się zwykle dwa rodzaje funkcji: liniową i nieliniową.

Funkcja liniowa jest przedstawiona w postaci takiej zależności: y \u003d a 0 + a 1 x 1 + a 2 x 2, + ... + a m x m. W tym przypadku a2, a m , uważa się za współczynniki „czystej” regresji. Są one niezbędne do scharakteryzowania średniej zmiany parametru y ze zmianą (spadek lub wzrost) w każdym odpowiednim parametrze x o jedną jednostkę, pod warunkiem stabilnej wartości innych wskaźników.

Równania nieliniowe mają na przykład postać funkcji potęgowej y=ax 1 b1 x 2 b2 ...x m bm . W tym przypadku wskaźniki b 1, b 2 ..... bm - nazywane są współczynnikami elastyczności, pokazują, jak zmieni się wynik (o ile%) wraz ze wzrostem (spadkiem) odpowiedniego wskaźnika x o 1% oraz ze stabilnym wskaźnikiem innych czynników.

Jakie czynniki należy wziąć pod uwagę podczas budowania regresji wielokrotnej

Aby poprawnie skonstruować regresję wielokrotną, konieczne jest ustalenie, na które czynniki należy zwrócić szczególną uwagę.

Niezbędne jest zrozumienie natury relacji między czynnikami ekonomicznymi a modelowanym. Uwzględniane czynniki muszą spełniać następujące kryteria:

- Musi być mierzalny. Aby w każdym przypadku użyć czynnika opisującego jakość przedmiotu, należy mu nadać postać ilościową.

- Nie powinno być korelacji między czynnikami ani związku funkcjonalnego. Takie działania prowadzą najczęściej do nieodwracalnych konsekwencji – układ równań zwyczajnych staje się nieuwarunkowany, a to pociąga za sobą jego zawodność i rozmyte oszacowania.

- W przypadku dużego wskaźnika korelacji nie ma możliwości ustalenia wyizolowanego wpływu czynników na wynik końcowy wskaźnika, dlatego współczynniki stają się nieczytelne.

Metody budowy

Istnieje ogromna liczba metod i sposobów wyjaśnienia, w jaki sposób można wybrać czynniki do równania. Jednak wszystkie te metody opierają się na doborze współczynników za pomocą wskaźnika korelacji. Wśród nich są:

- Metoda wykluczenia.

- Włącz metodę.

- Analiza regresji krokowej.

Pierwsza metoda polega na odsianiu wszystkich współczynników ze zbioru agregatów. Druga metoda polega na wprowadzeniu wielu dodatkowych czynników. Cóż, trzecia to eliminacja czynników, które wcześniej były stosowane w równaniu. Każda z tych metod ma prawo istnieć. Mają swoje plusy i minusy, ale potrafią na swój sposób rozwiązać problem odsiewania niepotrzebnych wskaźników. Z reguły wyniki uzyskane każdą pojedynczą metodą są dość zbliżone.

Metody analizy wielowymiarowej

Takie metody określania czynników opierają się na rozważeniu poszczególnych kombinacji powiązanych ze sobą cech. Obejmują one analizę dyskryminacyjną, rozpoznawanie wzorców, analizę głównych składowych i analizę skupień. Ponadto istnieje również analiza czynnikowa, jednak pojawiła się ona w wyniku rozwoju metody składowej. Wszystkie są stosowane w określonych okolicznościach, pod pewnymi warunkami i czynnikami.

Współczesna politologia wychodzi ze stanowiska dotyczącego relacji wszystkich zjawisk i procesów w społeczeństwie. Nie da się zrozumieć wydarzeń i procesów, przewidywać i zarządzać zjawiskami życia politycznego bez badania powiązań i zależności istniejących w politycznej sferze społeczeństwa. Jednym z najczęstszych zadań badań nad polityką jest badanie relacji między niektórymi obserwowalnymi zmiennymi. Cała klasa statystycznych metod analizy, które łączy wspólna nazwa „analiza regresji” (lub, jak się ją nazywa, „analiza korelacji i regresji”), pomaga rozwiązać ten problem. Jeżeli jednak analiza korelacji pozwala ocenić siłę związku między dwiema zmiennymi, to za pomocą analizy regresji można określić rodzaj tej zależności, przewidzieć zależność wartości dowolnej zmiennej od wartości innej zmiennej .

Najpierw pamiętajmy, czym jest korelacja. Współzależny nazwany najważniejszym szczególnym przypadkiem zależności statystycznej, który polega na tym, że równe wartości jednej zmiennej odpowiadają różnym wartości średnie inne. Wraz ze zmianą wartości atrybutu x zmienia się w naturalny sposób średnia wartość atrybutu y, natomiast w każdym indywidualnym przypadku wartość atrybutu w(z różnym prawdopodobieństwem) może przybierać wiele różnych wartości.

Pojawienie się terminu „korelacja” w statystyce (a politologia przyciąga osiągnięcie statystyki dla rozwiązywania jej problemów, która jest zatem dyscypliną powiązaną z politologią) wiąże się z nazwiskiem angielskiego biologa i statystyka Francisa Galtona, który zaproponował w XIX wieku. teoretyczne podstawy analizy korelacji i regresji. Termin „korelacja” w nauce był znany już wcześniej. W szczególności w paleontologii w XVIII wieku. zastosował go francuski naukowiec Georges Cuvier. Wprowadził tzw. prawo korelacji, za pomocą którego, według szczątków zwierząt znalezionych podczas wykopalisk, można było przywrócić ich wygląd.

Z nazwiskiem tego naukowca i jego prawem korelacji wiąże się znana historia. Tak więc w dni wolne od pracy studenci, którzy postanowili oszukać słynnego profesora, naciągnęli na jednego studenta kozią skórę z rogami i kopytami. Wszedł do okna sypialni Cuviera i krzyknął: „Zjem cię”. Profesor obudził się, spojrzał na sylwetkę i odpowiedział: „Jeśli masz rogi i kopyta, to jesteś roślinożercą i nie możesz mnie zjeść. A za nieznajomość prawa korelacji dostaniesz dwójkę. Odwrócił się i zasnął. Żart to żart, ale w tym przykładzie widzimy szczególny przypadek użycia analizy wielokrotnej korelacji i regresji. Tutaj profesor na podstawie znajomości wartości dwóch obserwowanych cech (obecność rogów i kopyt), na podstawie prawa korelacji, wyprowadził średnią wartość trzeciej cechy (klasa, do której należy to zwierzę jest roślinożercą). W tym przypadku nie mówimy o konkretnej wartości tej zmiennej (tzn. zwierzę to mogło przybierać różne wartości w skali nominalnej - może to być koza, baran, czy byk...).

Przejdźmy teraz do terminu „regresja”. Ściśle mówiąc, nie jest to związane ze znaczeniem tych problemów statystycznych, które rozwiązuje się za pomocą tej metody. Wyjaśnienie tego terminu można podać tylko na podstawie znajomości historii rozwoju metod badania związków między cechami. Jednym z pierwszych przykładów tego rodzaju badań była praca statystyków F. Galtona i K. Pearsona, którzy próbowali znaleźć wzorzec między rozwojem ojców i ich dzieci według dwóch obserwowalnych znaków (gdzie X- wzrost ojca i U- wzrost dzieci). W swoim badaniu potwierdzili początkową hipotezę, że przeciętnie wysocy ojcowie wychowują przeciętnie wysokie dzieci. Ta sama zasada dotyczy niskich ojców i dzieci. Gdyby jednak naukowcy na tym poprzestali, ich prace nigdy nie znalazłyby się w podręcznikach do statystyki. We wspomnianej już potwierdzonej hipotezie badacze znaleźli inny wzór. Udowodnili, że bardzo wysocy ojcowie rodzą dzieci przeciętnie wysokie, ale niewiele różniące się wzrostem od dzieci, których ojcowie, choć powyżej przeciętnej, nie różnią się zbytnio od przeciętnego wzrostu. To samo dotyczy ojców o bardzo niskim wzroście (odbiegającym od średniej z grupy niskiego wzrostu) – ich dzieci średnio nie różniły się wzrostem od rówieśników, których ojcowie byli po prostu niscy. Nazwali funkcję opisującą tę prawidłowość funkcja regresji. Po tych badaniach wszystkie równania opisujące podobne funkcje i skonstruowane w podobny sposób zaczęto nazywać równaniami regresji.

Analiza regresji jest jedną z metod wielowymiarowej analizy danych statystycznych, łącząc zestaw technik statystycznych zaprojektowanych do badania lub modelowania relacji między jedną zmienną zależną a kilkoma (lub jedną) zmienną niezależną. Zmienna zależna, zgodnie z tradycją przyjętą w statystyce, nazywana jest odpowiedzią i oznaczona jako V Zmienne niezależne nazywane są predyktorami i są oznaczone jako x. W trakcie analizy niektóre zmienne będą słabo powiązane z odpowiedzią i ostatecznie zostaną wykluczone z analizy. Pozostałe zmienne związane z zależnymi można również nazwać czynnikami.

Analiza regresji umożliwia przewidywanie wartości jednej lub więcej zmiennych w zależności od innej zmiennej (np. skłonność do niekonwencjonalnych zachowań politycznych w zależności od poziomu wykształcenia) lub kilku zmiennych. Jest obliczany na PC. Aby skompilować równanie regresji, które pozwala zmierzyć stopień zależności kontrolowanej cechy od czynnikowych, konieczne jest zaangażowanie profesjonalnych matematyków-programistów. Analiza regresji może być nieocenioną pomocą w budowaniu modeli predykcyjnych rozwoju sytuacji politycznej, ocenie przyczyn napięć społecznych oraz przeprowadzaniu eksperymentów teoretycznych. Analiza regresji jest aktywnie wykorzystywana do badania wpływu na zachowania wyborcze obywateli szeregu parametrów społeczno-demograficznych: płci, wieku, zawodu, miejsca zamieszkania, narodowości, poziomu i charakteru dochodów.

W odniesieniu do analizy regresji pojęcia niezależny I zależny zmienne. Zmienna niezależna to zmienna, która wyjaśnia lub powoduje zmianę innej zmiennej. Zmienna zależna to zmienna, której wartość tłumaczy się wpływem pierwszej zmiennej. Na przykład w wyborach prezydenckich w 2004 r. decydujące czynniki, tj. zmiennymi niezależnymi były wskaźniki takie jak stabilizacja sytuacji materialnej ludności kraju, poziom popularności kandydatów oraz czynnik beneficjum. W tym przypadku procent głosów oddanych na kandydatów można uznać za zmienną zależną. Podobnie w parze zmiennych „wiek wyborcy” i „poziom aktywności wyborczej” pierwsza jest niezależna, druga zależna.

Analiza regresji pozwala na rozwiązanie następujących problemów:

- 1) ustalić sam fakt występowania lub braku statystycznie istotnej zależności między Ci x;

- 2) zbudować najlepsze (w sensie statystycznym) oszacowania funkcji regresji;

- 3) według podanych wartości x zbuduj prognozę dla nieznanego Na

- 4) ocenić wagę właściwą wpływu każdego czynnika x na Na i odpowiednio wykluczyć z modelu nieistotne cechy;

- 5) identyfikując związki przyczynowe między zmiennymi, częściowo zarządzaj wartościami P, dostosowując wartości zmiennych objaśniających x.

Analiza regresji wiąże się z koniecznością wyselekcjonowania wzajemnie niezależnych zmiennych, które wpływają na wartość badanego wskaźnika, określenia postaci równania regresji oraz oceny parametrów z wykorzystaniem metod statystycznych do przetwarzania pierwotnych danych socjologicznych. Ten rodzaj analizy opiera się na idei formy, kierunku i bliskości (gęstości) relacji. Wyróżnić łaźnia parowa I wielokrotna regresja w zależności od liczby badanych cech. W praktyce analiza regresji jest zwykle wykonywana w połączeniu z analizą korelacji. Równanie regresji opisuje liczbowy związek między wielkościami, wyrażony jako tendencja wzrostu lub spadku jednej zmiennej, podczas gdy inna wzrasta lub maleje. W tym samym czasie razl i ha yut l mróz I regresja nieliniowa. W opisie procesów politycznych spotyka się oba warianty regresji.

Wykres punktowy dla rozkładu współzależności interesów artykułami politycznymi ( U) i edukacja respondentów (X) jest regresją liniową (ryc. 30).

Ryż. trzydzieści.

Wykres punktowy rozkładu poziomu aktywności wyborczej ( U) a wiek respondenta (A) (przykład warunkowy) jest regresją nieliniową (ryc. 31).

Ryż. 31.

Aby opisać związek dwóch cech (A” i Y) w modelu regresji sparowanej, stosuje się równanie liniowe

![]()

gdzie a, jest wartością losową błędu równania ze zmiennością cech, tj. odchylenie równania od „liniowości”.

Aby ocenić współczynniki ale I b użyj metody najmniejszych kwadratów, która zakłada, że suma kwadratów odchyleń każdego punktu na wykresie rozrzutu od linii regresji powinna być minimalna. Szanse a h b można obliczyć za pomocą układu równań:

Metoda najmniejszych kwadratów daje takie oszacowania współczynników ale I b, dla którego linia przechodzi przez punkt o współrzędnych x I tak, tych. jest stosunek w = topór + b. Graficzna reprezentacja równania regresji nazywa się teoretyczna linia regresji. W przypadku zależności liniowej współczynnik regresji przedstawia na wykresie tangens nachylenia teoretycznej linii regresji do osi x. Znak przy współczynniku pokazuje kierunek relacji. Jeśli jest większe od zera, to zależność jest bezpośrednia, jeśli jest mniejsza, jest odwrotna.

Poniższy przykład z badania „Petersburg polityczny 2006” (tabela 56) pokazuje liniową zależność między postrzeganiem przez obywateli stopnia zadowolenia z życia w teraźniejszości a oczekiwaniami zmian jakości życia w przyszłości. Połączenie jest bezpośrednie, liniowe (standaryzowany współczynnik regresji to 0,233, poziom istotności to 0,000). W tym przypadku współczynnik regresji nie jest wysoki, ale przekracza dolną granicę wskaźnika istotnego statystycznie (dolną granicę kwadratu wskaźnika istotnego statystycznie współczynnika Pearsona).

Tabela 56

Wpływ jakości życia obywateli w teraźniejszości na oczekiwania

(Petersburg, 2006)

* Zmienna zależna: „Jak Twoim zdaniem zmieni się Twoje życie w ciągu najbliższych 2-3 lat?”

W życiu politycznym wartość badanej zmiennej najczęściej zależy jednocześnie od kilku cech. Na przykład na poziom i charakter działalności politycznej wpływa jednocześnie ustrój polityczny państwa, tradycje polityczne, specyfika zachowań politycznych ludzi na danym terenie oraz mikrogrupa społeczna respondenta, jego wiek, wykształcenie, dochody poziom, orientacja polityczna itp. W takim przypadku musisz użyć równania wielokrotna regresja, który ma następującą postać:

gdzie współczynnik b.- częściowy współczynnik regresji. Pokazuje wkład każdej zmiennej niezależnej w wyznaczenie wartości zmiennej niezależnej (wynikowej). Jeżeli częściowy współczynnik regresji jest bliski 0, to możemy stwierdzić, że nie ma bezpośredniego związku między zmienną niezależną i zależną.

Obliczenia takiego modelu można przeprowadzić na komputerze PC przy użyciu algebry macierzowej. Regresja wielokrotna pozwala odzwierciedlić wieloczynnikowy charakter więzi społecznych i wyjaśnić miarę wpływu każdego czynnika z osobna i wszystkich razem na uzyskaną cechę.

Oznaczony współczynnik b, nazywa się współczynnikiem regresji liniowej i pokazuje siłę związku między zmiennością cechy czynnika x i zmienność efektywnej funkcji Y Współczynnik ten mierzy siłę związku w bezwzględnych jednostkach miary cech. Jednak bliskość korelacji cech można również wyrazić w postaci odchylenia standardowego otrzymanej cechy (taki współczynnik nazywamy współczynnikiem korelacji). W przeciwieństwie do współczynnika regresji b współczynnik korelacji nie zależy od przyjętych jednostek miary cech, a zatem jest porównywalny dla dowolnych cech. Zwykle połączenie uważa się za mocne, jeśli /> 0,7, średnia szczelność - na 0,5 g 0,5.

Jak wiadomo, najbliższym połączeniem jest połączenie funkcjonalne, gdy każda pojedyncza wartość Y można jednoznacznie przypisać do wartości x. Zatem im bliższy współczynnikowi korelacji jest 1, tym bliższy jest związek funkcjonalny. Poziom istotności dla analizy regresji nie powinien przekraczać 0,001.

Współczynnik korelacji od dawna uważany jest za główny wskaźnik bliskości związku cech. Jednak później takim wskaźnikiem stał się współczynnik determinacji. Znaczenie tego współczynnika jest następujące – odzwierciedla udział całkowitej wariancji otrzymanej cechy Na, wyjaśnione przez wariancję funkcji x. Oblicza się go po prostu podnosząc do kwadratu współczynnik korelacji (zmieniający się z 0 na 1), a dla zależności liniowej odzwierciedla udział od 0 (0%) do 1 (100%) wartości charakterystyczne Tak, określone przez wartości atrybutu x. Jest rejestrowany jako ja 2 , aw powstałych tabelach analizy regresji w pakiecie SPSS - bez kwadratu.

Oznaczmy główne problemy konstrukcji równania regresji wielorakiej.

- 1. Wybór czynników zawartych w równaniu regresji. Na tym etapie badacz najpierw sporządza ogólną listę głównych przyczyn, które zgodnie z teorią determinują badane zjawisko. Następnie musi wybrać cechy w równaniu regresji. Główną zasadą selekcji jest to, aby czynniki uwzględnione w analizie były ze sobą jak najmniej skorelowane; tylko w tym przypadku możliwe jest przypisanie ilościowej miary wpływu do pewnego czynnika-atrybutu.

- 2. Wybór postaci równania regresji wielokrotnej(w praktyce częściej stosuje się liniową lub liniowo-logarytmiczną). Aby więc zastosować regresję wielokrotną, badacz musi najpierw zbudować hipotetyczny model wpływu kilku zmiennych niezależnych na wynikową. Aby uzyskane wyniki były wiarygodne, konieczne jest, aby model dokładnie odpowiadał rzeczywistemu procesowi, tj. zależność między zmiennymi musi być liniowa, żadna istotna zmienna niezależna nie może być pominięta, podobnie jak żadna zmienna, która nie jest bezpośrednio związana z badanym procesem, nie może zostać uwzględniona w analizie. Ponadto wszystkie pomiary zmiennych muszą być niezwykle dokładne.

Z powyższego opisu wynika szereg warunków stosowania tej metody, bez których nie można przejść do procedury analizy regresji wielokrotnej (MRA). Tylko zgodność ze wszystkimi poniższymi punktami pozwala na prawidłowe przeprowadzenie analizy regresji.

- W kontakcie z 0

- Google+ 0

- ok 0

- Facebook 0